Einführung in Methoden des maschinellen Lernens

Der folgende Artikel, Methoden des maschinellen Lernens, enthält eine Übersicht über die am häufigsten verwendeten Methoden des maschinellen Lernens. Maschinelles Lernen ist eine Technik, mit der ein Computer Dinge selbstständig „lernen“ kann. Die Algorithmen verbessern ihre Leistung adaptiv, wenn die für das Lernen verfügbaren Daten zunehmen. Je genauer die Daten sind, desto genauer ist unser Modell.

Wie lernen Maschinen?

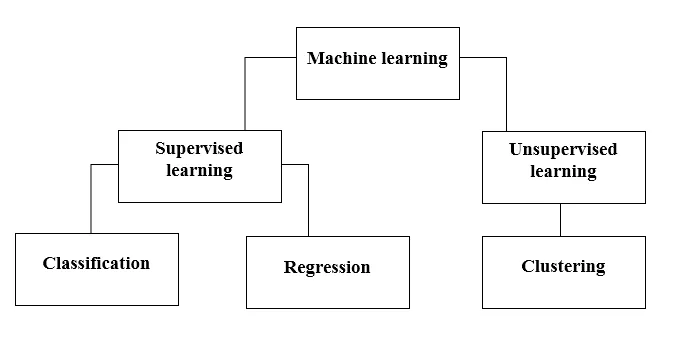

Dafür gibt es verschiedene Methoden. Welche Methode vollständig anzuwenden ist, hängt von der Problemstellung ab. Je nach Datensatz und unserem Problem gibt es zwei verschiedene Möglichkeiten, tiefer zu gehen. Einer ist überwachtes Lernen und der andere ist unbeaufsichtigtes Lernen. Die folgende Tabelle erläutert die weitere Klassifizierung der Methoden des maschinellen Lernens. Wir werden sie einzeln besprechen.

Schauen Sie sich die folgende Tabelle an!

Lassen Sie uns verstehen, was betreutes Lernen bedeutet.

Überwachtes Lernen

Stellen Sie sich, wie der Name schon sagt, einen Lehrer oder einen Vorgesetzten vor, der Ihnen beim Lernen hilft. Das gilt auch für Maschinen. Wir trainieren oder lehren die Maschine mit Daten, die beschriftet sind.

Einige der coolsten betreuten Lernanwendungen sind:

- Stimmungsanalyse (Twitter, Facebook, Netflix, YouTube usw.)

- Verarbeitung natürlicher Sprache

- Bildklassifizierung

- Vorausschauende Analyse

- Mustererkennung

- Spam-Erkennung

- Sprach- / Sequenzverarbeitung

Betreutes Lernen wird nun weiter in Klassifikation und Regression unterteilt. Verstehen wir das.

Einstufung

Bei der Klassifizierung wird ein Modell gefunden, mit dessen Hilfe die Daten in verschiedene kategoriale Klassen unterteilt werden können. In diesem Prozess werden die Daten gemäß einigen in der Eingabe angegebenen Parametern unter verschiedenen Bezeichnungen kategorisiert und anschließend werden die Bezeichnungen für die Daten vorhergesagt. Kategorisch bedeutet, dass die Ausgabevariable eine Kategorie ist, dh rot oder schwarz, Spam oder kein Spam, Diabetiker oder Nicht-Diabetiker usw.

Zu den Klassifizierungsmodellen gehören Support Vector Machine (SVM), K-nächster Nachbar (KNN), Naive Bayes usw.

a) Support Vector Machine Classifier (SVM)

SVM ist eine überwachte Lernmethode, bei der die Daten betrachtet und in eine von zwei Kategorien sortiert werden. Ich benutze eine Hyperebene, um die Daten zu kategorisieren. Ein linearer diskriminativer Klassifikator versucht, eine gerade Linie zwischen den beiden Datensätzen zu zeichnen und dadurch ein Modell für die Klassifizierung zu erstellen. Es wird einfach versucht, eine Linie oder Kurve (in zwei Dimensionen) oder eine Mannigfaltigkeit (in mehreren Dimensionen) zu finden, die die Klassen voneinander trennt.

Hinweis - Für die Klassifizierung mehrerer Klassen verwendet SVM 'one vs rest', dh, es werden für jede Klasse unterschiedliche SVM berechnet.

b) K-Nächster-Nachbar-Klassifikator (KNN)

- Wenn Sie sorgfältig lesen, schlägt der Name selbst vor, was der Algorithmus tut. KNN betrachtet die Datenpunkte, die näher liegen, in Bezug auf Merkmale viel ähnlicher sind und daher mit größerer Wahrscheinlichkeit derselben Klasse wie der Nachbar angehören. Für jeden neuen Datenpunkt wird die Entfernung zu allen anderen Datenpunkten berechnet und die Klasse wird basierend auf K nächsten Nachbarn bestimmt. Ja, es mag lahm klingen, aber für einige der Klassifizierungen funktioniert es wie alles.

- Ein Datenpunkt wird durch die maximale Stimmenzahl seiner Nachbarn klassifiziert, dann wird der Datenpunkt der Klasse zugeordnet, die unter seinen k-Nachbarn am nächsten liegt.

- In KNN ist kein Erlernen des Modells erforderlich und die gesamte Arbeit findet zum Zeitpunkt der Anforderung einer Vorhersage statt. Aus diesem Grund wird KNN häufig als Lazy Learning-Algorithmus bezeichnet.

c) Naiver Bayes-Klassifikator

- Naïve Bayes ist ein Algorithmus für maschinelles Lernen, der bei Problemen mit der Textklassifizierung dringend empfohlen wird. Es basiert auf dem Wahrscheinlichkeitssatz von Bayes. Diese Klassifizierer werden als naiv bezeichnet, da sie davon ausgehen, dass Feature-Variablen voneinander unabhängig sind. Das heißt, wir haben zum Beispiel einen vollständigen Satz zur Eingabe, dann geht Naïve Bayes davon aus, dass jedes Wort in einem Satz unabhängig von den anderen ist. Und klassifizieren Sie sie dann entsprechend. Ich weiß, es sieht ziemlich naiv aus, aber es ist eine gute Wahl für Probleme mit der Textklassifizierung und eine beliebte Wahl für die Klassifizierung von Spam-E-Mails.

- Es bietet verschiedene Arten von Naive-Bayes-Algorithmen wie BernoulliNB, GaussianNB, MultinomialNB.

- Alle Features werden als nicht miteinander verknüpft betrachtet, sodass die Beziehung zwischen den Features nicht ermittelt werden kann. Zum Beispiel, sagen wir mal, Varun isst gerne Burger, er isst auch gerne Pommes mit Cola. Aber er isst nicht gerne einen Burger und eine Kombination aus Pommes mit Cola zusammen. Hier kann Naïve Bayes nicht die Beziehung zwischen zwei Merkmalen lernen, sondern nur die Bedeutung einzelner Merkmale.

Kommen wir nun zur anderen Seite unserer überwachten Lernmethode, die eine Regression darstellt.

Regression

Unter Regression versteht man das Auffinden eines Modells, mit dessen Hilfe die Daten anhand kontinuierlicher Werte differenziert werden können. Dabei wird die Art der vorhergesagten Daten geordnet. Einige der am häufigsten verwendeten Regressionsmodelle umfassen lineare Regression, zufällige Gesamtstruktur (Entscheidungsbäume) und neuronale Netze.

Lineare Regression

- Einer der einfachsten Ansätze beim überwachten Lernen, der zur Vorhersage der quantitativen Reaktion nützlich ist.

- Zur linearen Regression gehört das Finden der am besten passenden geraden Linie durch die Punkte. Die am besten passende Linie wird als Regressionslinie bezeichnet. Die Best-Fit-Linie verläuft nicht genau durch alle Datenpunkte, sondern versucht, möglichst nahe an sie heranzukommen.

- Es ist der weit verbreitete Algorithmus für kontinuierliche Daten. Es konzentriert sich jedoch nur auf den Mittelwert der abhängigen Variablen und beschränkt sich auf eine lineare Beziehung.

- Die lineare Regression kann für Zeitreihen und Trendprognosen verwendet werden. Es kann zukünftige Verkäufe auf der Grundlage der vorherigen Daten vorhersagen.

Unbeaufsichtigtes Lernen

- Unüberwachtes Lernen basiert auf dem Ansatz, der als Abwesenheit eines Lehrers und damit als absolute Fehlerkorrektur angesehen werden kann. Dies ist nützlich, wenn Sie das Clustering oder Gruppieren von Elementen erlernen möchten. Elemente können nach ihrer Ähnlichkeit gruppiert (gruppiert) werden.

- Beim unbeaufsichtigten Lernen werden Daten nicht gekennzeichnet, nicht kategorisiert, und die Algorithmen des Systems greifen ohne vorherige Schulung auf die Daten zurück. Unüberwachte Lernalgorithmen können komplexere Aufgaben ausführen als überwachte Lernalgorithmen.

- Unbeaufsichtigtes Lernen umfasst Clustering, das mithilfe von K-Mitteln (Clustering, hierarchisch, Gaußsche Mischung, Hidden-Markov-Modell) durchgeführt werden kann.

Nicht überwachte Lernanwendungen sind:

- Ähnlichkeitserkennung

- Automatische Etikettierung

- Objektsegmentierung (wie Person, Tier, Filme)

Clustering

- Clustering ist eine unbeaufsichtigte Lernmethode, die in vielen Bereichen für die Datenanalyse verwendet wird. Der Clustering-Algorithmus ist nützlich, wenn wir detaillierte Einblicke in unsere Daten erhalten möchten.

- Ein Beispiel für Clustering in der Praxis wären die Netflix-Genrecluster, die für verschiedene Zielkunden aufgeteilt sind, einschließlich Interessen, demografischer Merkmale, Lebensstile usw. Nun können Sie überlegen, wie nützlich Clustering ist, wenn Unternehmen ihre Kundenbasis verstehen und neue Potenziale erschließen möchten Kunden.

a) K bedeutet Clustering

- K bedeutet, dass der Clustering-Algorithmus versucht, die angegebenen unbekannten Daten in Cluster aufzuteilen. Es wählt zufällig 'k' Cluster-Schwerpunkt aus, berechnet den Abstand zwischen Datenpunkten und Cluster-Schwerpunkt und ordnet den Datenpunkt schließlich dem Cluster-Schwerpunkt zu, dessen Abstand das Minimum aller Cluster-Schwerpunkte ist.

- In k-means werden Gruppen durch den nächstgelegenen Schwerpunkt für jede Gruppe definiert. Dieser Schwerpunkt fungiert als "Gehirn" des Algorithmus, sie erfassen die Datenpunkte, die ihnen am nächsten liegen, und fügen sie dann zu den Clustern hinzu.

b) Hierarchisches Clustering

Hierarchisches Clustering ist dem normalen Clustering nahezu ähnlich, es sei denn, Sie möchten eine Hierarchie von Clustern aufbauen. Dies kann nützlich sein, wenn Sie die Anzahl der Cluster festlegen möchten. Angenommen, Sie erstellen Gruppen verschiedener Artikel im Online-Lebensmittelgeschäft. Auf der Startseite möchten Sie einige allgemeine Elemente, und wenn Sie auf eines der Elemente klicken, werden bestimmte Kategorien, dh spezifischere Cluster, geöffnet.

Dimensionsreduzierung

Die Dimensionsreduzierung kann als Komprimierung einer Datei betrachtet werden. Es bedeutet, die Informationen herauszunehmen, die nicht relevant sind. Es reduziert die Komplexität der Daten und versucht, die aussagekräftigen Daten beizubehalten. Zum Beispiel reduzieren wir bei der Bildkomprimierung die Dimensionalität des Raums, in dem das Bild verbleibt, ohne zu viel von dem sinnvollen Inhalt im Bild zu zerstören.

PCA für die Datenvisualisierung

Die Hauptkomponentenanalyse (Principal Component Analysis, PCA) ist eine Methode zur Dimensionsreduzierung, die zur Visualisierung Ihrer Daten hilfreich sein kann. PCA wird verwendet, um höherdimensionale Daten in niedrigerdimensionale Daten zu komprimieren. Das heißt, wir können PCA verwenden, um vierdimensionale Daten in drei oder zwei Dimensionen zu reduzieren, damit wir die Daten visualisieren und besser verstehen können.

Empfohlene Artikel

Dies ist eine Anleitung zu Methoden des maschinellen Lernens. Hier haben wir eine Einführung besprochen: Wie lernen Maschinen? Klassifikationen des maschinellen Lernens und ein Flussdiagramm mit einer detaillierten Erklärung. Sie können auch unsere anderen Artikelvorschläge durchgehen, um mehr zu erfahren -

- Architektur des maschinellen Lernens

- Frameworks für maschinelles Lernen

- Werkzeuge für maschinelles Lernen

- Maschinelles Lernen

- Hyperparameter Maschinelles Lernen

- Hierarchischer Clustering-Algorithmus

- Hierarchisches Clustering | Agglomeratives & Divisives Clustering