Wie installiere ich Hive?

Apache Hadoop ist eine Sammlung des Frameworks, das die Verarbeitung von über den Cluster verteilten Big Data ermöglicht. Laut Apache Hive handelt es sich um ein Data-Warehouse-Softwareprojekt, das auf Apache Hadoop aufbaut und Daten abfragt und analysiert. Apache Hive bietet eine SQL-ähnliche Schnittstelle zum Abfragen und Verarbeiten einer großen Datenmenge, die als HQL (Hive Query Language) bezeichnet wird. Apache Hive läuft auf dem Hadoop-Ökosystem und die in Form von Dateien gespeicherten Daten bedeuten das Hadoop Distributed File System (HDFS). Apache Hive bietet dem Benutzer eine hervorragende Schnittstelle, um auf die Daten in Form einer Tabelle zuzugreifen und sie zu bearbeiten. Es bietet eine hervorragende Optimierungstechnik, um die Leistung zu verbessern. Es ist sehr schwierig, die Abfrage mit Big Data zu beschleunigen, und glauben Sie mir, es ist in einer Produktionsumgebung wichtig.

Im Backend konvertiert der Compiler HQL-Abfragen in Map-Reduction-Jobs und übergibt sie zur Ausführung an das Hadoop-Framework.

Unterschied zwischen Hive und SQL

Apache Hive ist SQL sehr ähnlich, aber wie wir wissen, läuft Hive auf dem Hadoop-Ökosystem und konvertiert Jobs intern in MR-Jobs (Map Reduce-Jobs). Dies macht einen gewissen Unterschied zwischen Hive und SQL.

Hive ist nicht der beste Ansatz für Anwendungen, bei denen eine sehr schnelle Reaktion erforderlich ist, und es ist sehr wichtig zu verstehen, dass Hive besser für die Stapelverarbeitung über sehr große Mengen unveränderlicher Daten geeignet ist. Wir sollten beachten, dass Hive ein reguläres RDBMS ist und nicht zuletzt Aber nicht zuletzt ist Apache Hive ein Schema für Lesemittel (beim Einfügen von Daten in die Hive-Tabelle stört es nicht, dass der Datentyp nicht übereinstimmt, aber beim Lesen von Daten wird ein Nullwert angezeigt, wenn der Datentyp nicht mit dem Datentyp einer bestimmten Spalte übereinstimmt).

Vorherige Anforderung zur Installation von Hive

Wie ich bereits sagte, ist es sehr wichtig zu verstehen, dass Apache Hive auf Hadoop Ecosystem läuft und Hadoop mit allen Dämonen läuft.

Einige der grundlegenden Hadoop-Dämonen sind wie folgt:

- Name des Knotens

- Datenknoten

- Ressourcenmanager

- Knotenmanager

Um die Hadoop-Version zu überprüfen, geben Sie den folgenden Befehl ein:

Geben Sie → Hadoop-Version in die Eingabeaufforderung ein, um die Version von Hadoop anzuzeigen.

So überprüfen Sie den folgenden Befehl zum Auslösen des Hadoop-Clusterberichts:

Geben Sie → Hadoop dfsadmin –report in die Eingabeaufforderung ein, um den gesamten Clusterbericht anzuzeigen, wenn Ihr Server ausgeführt wird.

Wenn Hadoop nicht auf Ihrem Computer installiert ist und Sie dazu auffordert, folgen Sie den Anweisungen von Apache, um Hadoop auf Ihrem System zu installieren.

Ich hoffe, Java wurde bereits auf Ihrem System installiert. Um die Java-Version zu überprüfen, sehen Sie sich bitte den Screenshot an.

Schritte zum Installieren von Hive unter Ubuntu

Im Folgenden sind die Schritte zum Installieren von Hive unter Ubuntu aufgeführt:

Schritt 1 : Hive-Teer, den wir mit dem folgenden Befehl im Terminal herunterladen können, den wir auch direkt vom Terminal herunterladen können.

Befehl: Wir erhalten http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

Schritt 2 : Extrahieren Sie die TAR- Datei mit dem folgenden Befehl im Terminal. Sie können die TAR-Datei über der heruntergeladenen TAR-HIVE direkt extrahieren.

Befehl: tar -xzf apache-hive-2.1.0-bin.tar.gz

Ich schlage vor, dass Sie mit dem Befehl ls die extrahierte Hive-Datei überprüfen.

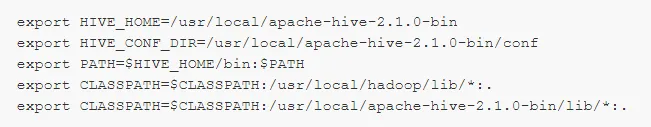

Schritt 3: Bearbeiten Sie die Datei „ .bashrc “, um die Umgebungsvariablen für den Benutzer zu aktualisieren.

Befehl: sudo the .bashrc

Fügen Sie am Ende der Datei Folgendes hinzu:

# HIVE_HOME setzen

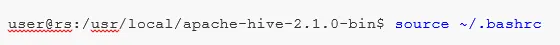

Führen Sie den folgenden Befehl aus, um die Änderungen im aktuellen Terminal abzuschließen.

Befehl: source .bashrc

Schritt 5 : Wir müssen Hive-Verzeichnisse innerhalb des HDFS-Speicherorts erstellen, und in diesem Verzeichnis "Warehouse" werden die Metadateninformationen der Hive-Tabelle und die Daten zu Hive gespeichert.

Befehl :

- hdfs dfs -mkdir -p / user / hive / warehouse

- hdfs dfs -mkdir / tmp

Schritt 6 : Führen Sie den folgenden Befehl aus, um die Lese- und Schreibberechtigung für die Hive-Tabelle festzulegen.

Befehl:

Im folgenden Befehl wird der Benutzergruppe eine Schreibberechtigung erteilt:

- hdfs dfs -chmod g + w / user / hive / warehouse

- hdfs dfs -chmod g + w / tmp

Hive konfigurieren: Für die Konfiguration mit Hadoop ist es sehr wichtig, die Installationsstruktur anzugeben. Wir müssen hive-env.sh bearbeiten, eine Datei, die sich im Verzeichnis $ HIVE_HOME / conf befindet. Die folgenden Befehle leiten zum Ordner "Hive conf" um und kopieren die Vorlagendatei:

Schritt 7 : Legen Sie in hive-env.sh einen Hadoop- Pfad fest

Bearbeiten Sie die Datei hive-env.sh, indem Sie die folgende Zeile anhängen:

Mit diesem Vorgang sind wir fast fertig und die Hive-Installationen wurden erfolgreich abgeschlossen. Es ist wichtig, Metastore mit dem externen Datenbankserver zu konfigurieren. Standardmäßig verwendet das Apache Hive-Framework die Derby-Datenbank. Mit dem folgenden Befehl wird die Derby-Datenbank initialisiert.

Befehl: bin / schematool -initSchema -dbType Derby

Schritt 8 : Starten Sie Hive .

Befehl: hive (Geben Sie hive in das Terminal innerhalb des zweiten Hive-Terminals ein.)

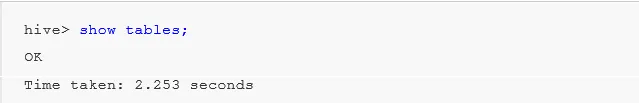

Arbeiten mit Hive: Jetzt sehen wir einige Operationen im Hive, um zu sehen, wie viele Tabellen in der Standarddatenbank verwendet werden. Siehe Screenshots in den folgenden Screenshots. Es werden keine Tabellen angezeigt. Dies bedeutet, dass wir keine Tabellen in der Standarddatenbank haben .

Um eine Tabelle in der Struktur zu erstellen, ist es sehr wichtig, die erforderliche Datenbank zu referenzieren. Andernfalls wird jede Tabelle unter der Standarddatenbank erstellt.

Wichtige Befehle in Hive

1: zeige Datenbanken (es werden alle bisher erstellten Datenbanken angezeigt).

2: Datenbank erstellen, falls nicht vorhanden mydb (dieser Befehl erstellt eine Datenbank mit dem Namen ' mydb', falls ' mydb' nicht vorhanden ist und falls ' mydb bereits vorhanden ist, wird auch kein Fehler ausgegeben )

3: Datenbank verwenden, wann immer wir einen DDl-Befehl für die bestimmte Datenbank verwenden müssen. Wir sollten den Befehl "Datenbank verwenden" verwenden, wenn wir bereits den Befehl "mydb" erstellt haben. Show würde "mydb" verwendet .

Wichtiger Hive-DDL-Befehl

ERSTELLEN, TROPFEN, TRUNKIEREN, ZEIGEN, BESCHREIBEN .

- Erstellen : - Erstellen Sie eine Anweisung zum Erstellen einer Datenbank oder einer Tabelle in einer Struktur.

Beispiel: Bienenstock> Datenbank erstellen Firma; (Datenbank erstellen)

Hive> use Company;

Hive> Tabellenmitarbeiter erstellen (ID int, Name String, Gehalt String); (Dadurch wird ein Tabellenmitarbeiter unter der Datenbank Firma erstellt, da wir den Befehl Datenbank verwenden bereits ausgeführt haben.)

- Beschreiben enthält Informationen zum Schema der Tabelle.

Bienenstock> Mitarbeiter beschreiben; (Dies gibt die Schemadetails der Mitarbeitertabelle in Details an.)

- TRUNCATE löscht die Daten der Tabelle.

Bienenstock> Tabellenmitarbeiter abschneiden;

Wir können den Hive auch in einem Fenster installieren, aber aus Best Practice-Gründen bevorzuge ich die Verwendung von Ubuntu, um eine bessere Sicht auf die Produktionsumgebung zu erhalten, und um Ihre Daten in Zukunft zu vergrößern, wird es einfach zu verwalten sein.

Empfohlene Artikel

Dies war eine Anleitung zur Installation von Hive. Hier haben wir die verschiedenen Schritte zum Installieren von Hive, DDL-Befehlen usw. besprochen. Weitere Informationen finden Sie auch in den folgenden Artikeln:

- So installieren Sie SQL Server

- So installieren Sie MATLAB

- Hive-Befehle und -Features

- Fragen im Vorstellungsgespräch bei Basic Hive

- Bienenstock Architektur | Arbeitsablauf

- Verwenden der ORDER BY-Funktion in Hive

- Hive-Installation