Einführung in Kernel-Methoden im maschinellen Lernen

Der für die Musteranalyse verwendete Algorithmus wird beim maschinellen Lernen als Kernel-Methode bezeichnet. Im Allgemeinen wird eine Analyse durchgeführt, um Beziehungen in Datensätzen zu finden. Diese Beziehungen können Clustering, Klassifizierung, Hauptkomponenten, Korrelation usw. sein. Die meisten dieser Algorithmen, die diese Aufgaben der Analyse des Musters lösen, benötigen die Daten in Rohdarstellung, um explizit in eine Merkmalsvektordarstellung umgewandelt zu werden. Diese Umwandlung kann über eine benutzerdefinierte Feature-Map erfolgen. Es kann also davon ausgegangen werden, dass nur der vom Benutzer angegebene Kernel von der Kernelmethode benötigt wird.

Die Terminologie Kernal Method beruht auf der Tatsache, dass sie die Kernelfunktion verwenden, mit der sie die Operation in einem hochdimensionalen impliziten Merkmalsraum ausführen können, ohne die Koordinaten der Daten in diesem Raum berechnen zu müssen. Stattdessen berechnen sie einfach das innere Produkt zwischen den Bildern aller Datenpaare im Featurebereich.

Diese Arten von Operationen sind die meiste Zeit rechenmäßig billiger als die explizite Berechnung der Koordinaten. Diese Technik wird als "Kernel-Trick" bezeichnet. Jedes lineare Modell kann durch Anwenden des Kernel-Tricks auf das Modell in ein nicht lineares Modell konvertiert werden.

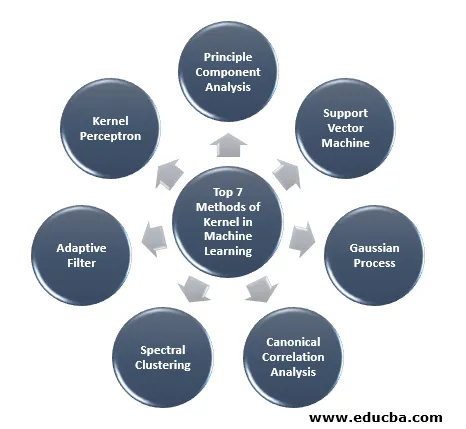

Die beim maschinellen Lernen verfügbare Kernel-Methode ist die Hauptkomponentenanalyse (PCA), Spektralclustering, Support Vector Machines (SVM), kanonische Korrelationsanalyse, Kernel-Perzeptron, Gaußsche Prozesse, Ridge-Regression, lineare adaptive Filter und viele andere. Lassen Sie uns einige dieser Kernel-Methoden auf hoher Ebene verstehen.

Top 7 Methoden des Kernels im maschinellen Lernen

Nachfolgend sind die Methoden des Kernels im maschinellen Lernen aufgeführt:

1. Prinzipielle Komponentenanalyse

Die Hauptkomponentenanalyse (PCA) ist eine Technik zum Extrahieren von Strukturen aus möglicherweise hochdimensionalen Datensätzen. Es kann leicht durchgeführt werden, indem iterative Algorithmen verwendet werden, die Hauptkomponenten schätzen, oder indem ein Eigenwertproblem gelöst wird. PCA ist eine orthogonale Transformation des Koordinatensystems, in dem wir unsere Daten beschreiben. Das neue Koordinatensystem wird durch Projektion auf die Hauptachsen der Daten erhalten. Eine kleine Anzahl von Hauptkomponenten ist häufig ausreichend, um den größten Teil der Datenstruktur zu berücksichtigen. Eine der Hauptanwendungen ist die Durchführung einer explorativen Datenanalyse zur Erstellung eines Vorhersagemodells. Es diente hauptsächlich zur Visualisierung der Beziehung zwischen Populationen und genetischer Distanz.

2. Unterstützen Sie Vector Machine

SVM kann als Klassifizierer zum Trennen der Hyperebene definiert werden, wobei die Hyperebene der Unterraum einer Dimension ist, die kleiner als der Umgebungsraum ist. Die Dimension dieses mathematischen Raums ist definiert als die minimale Anzahl von Koordinaten, die erforderlich sind, um einen Punkt anzugeben, während der Umgebungsraum der Raum ist, der das mathematische Objekt umgibt. Nun kann das mathematische Objekt als abstraktes Objekt verstanden werden, das zu keiner Zeit und an keinem Ort existiert, sondern als eine Art von Sache existiert.

3. Gaußscher Prozess

Der Gaußsche Prozess wurde nach Cark Friedrich Gauß benannt, weil er die Notation der Gaußschen Verteilung (Normalverteilung) verwendet. Es ist ein stochastischer Prozess, der eine Sammlung von Zufallsvariablen bedeutet, die nach Zeit oder Raum indiziert sind. Zufallsvariablen haben im Gaußschen Prozess eine multivariate Normalverteilung, dh alle endlichen linearen Kombinationen davon sind normalverteilt. Der Gauß-Prozess verwendet die Eigenschaften einer Normalverteilung und ist daher für die statistische Modellierung nützlich. Der Algorithmus für maschinelles Lernen, bei dem diese Kernel-Methode zum Einsatz kommt, verwendet das Maß für das langsame Lernen und die Ähnlichkeit zwischen Punkten, um den Wert nicht sichtbarer Punkte aus Trainingsdaten vorherzusagen. Diese Vorhersage ist nicht nur die Schätzung, sondern auch die Unsicherheit zu diesem Zeitpunkt.

4. Kanonische Korrelationsanalyse

Die kanonische Korrelationsanalyse ist ein Weg, Informationen aus Kreuzkovarianzmatrizen abzuleiten. Es wird auch als kanonische Variablenanalyse bezeichnet. Angenommen, wir haben zwei Vektoren X, Y einer Zufallsvariablen, nämlich zwei Vektoren X = (X1, …, Xn) und einen Vektor Y = (Y1, …, Ym), und die Variable mit Korrelation, dann berechnet CCA eine Linearkombination von X und Y, die die maximale Korrelation untereinander haben.

5. Spektrale Clusterbildung

Bei der Anwendung der Bildsegmentierung wird die spektrale Gruppierung als segmentierungsbasierte Objektkategorisierung bezeichnet. Beim spektralen Clustering wird die Dimensionsreduktion vor dem Clustering in weniger Dimensionen durchgeführt, indem der Eigenwert der Ähnlichkeitsmatrix der Daten verwendet wird. Es hat seine Wurzeln in der Graphentheorie, wo dieser Ansatz verwendet wird, um Gemeinschaften von Knoten in einem Graphen zu identifizieren, der auf den sie verbindenden Kanten basiert. Diese Methode ist flexibel genug und ermöglicht es uns, Daten auch von Nicht-Graphen zu gruppieren.

6. Adaptiver Filter

Das adaptive Filter verwendet ein lineares Filter, das eine Übertragungsfunktion umfasst, die durch variable Parameter gesteuert wird, und die Methoden, die verwendet werden, um diese Parameter gemäß dem Optimierungsalgorithmus zu optimieren. Die Komplexität dieses Optimierungsalgorithmus ist der Grund dafür, dass jedes adaptive Filter ein digitales Filter ist. Ein adaptives Filter wird in solchen Anwendungen benötigt, in denen im Voraus keine vorherigen Informationen über den gewünschten Verarbeitungsvorgang vorliegen oder sich diese ändern.

Die Kostenfunktion wird im adaptiven Filter mit geschlossenem Regelkreis verwendet, da dies für die optimale Leistung des Filters erforderlich ist. Hiermit wird festgelegt, wie die Filterübertragungsfunktion geändert werden soll, um die Kosten für die nächste Iteration zu senken. Eine der häufigsten Funktionen ist der mittlere quadratische Fehler des Fehlersignals.

7. Kernel Perceptron

Beim maschinellen Lernen ist das Kernel-Perzeptron ein Typ des beliebten Perzeptron-Lernalgorithmus, der Kernel-Maschinen lernen kann, z. Dieser Algorithmus wurde 1964 erfunden und ist damit der erste Lernende für die Kernelklassifikation.

Die meisten der diskutierten Kernel-Algorithmen basieren auf konvexen Optimierungen oder Eigenproblemen und sind statistisch fundiert. Ihre statistischen Eigenschaften werden mit Hilfe der statistischen Lerntheorie analysiert.

Die Anwendungsbereiche der Kernel-Methoden sind vielfältig und umfassen Geostatistik, Kriging, inverse Distanzgewichtung, 3D-Rekonstruktion, Bioinformatik, Chemoinformatik, Informationsextraktion und Handschrifterkennung.

Fazit

Ich habe einige der Terminologien und Arten von Kernelmethoden im maschinellen Lernen zusammengefasst. Aus Platzgründen ist dieser Artikel keineswegs umfassend und soll Ihnen nur einen Einblick in die Kernelmethode und eine kurze Zusammenfassung ihrer Typen geben. Wenn Sie diesen Artikel behandeln, werden Sie jedoch den ersten Schritt auf dem Gebiet des maschinellen Lernens machen.

Empfohlene Artikel

Dies ist eine Anleitung zur Kernel-Methode im maschinellen Lernen. Hier diskutieren wir die 7 Arten von Kernel-Methoden im maschinellen Lernen. Sie können sich auch den folgenden Artikel ansehen.

- Monolithischer Kern

- Clustering im maschinellen Lernen

- Data Science Maschinelles Lernen

- Unüberwachtes maschinelles Lernen

- PHP Filter | Wie validiere ich Benutzereingaben mit verschiedenen Filtern?

- Vollständiger Leitfaden zum Lebenszyklus des maschinellen Lernens