Einführung in Data Science Machine Learning

Bei Daten handelt es sich im Wesentlichen um Informationen, insbesondere Fakten oder Zahlen, die gesammelt werden, um sie zu untersuchen und zu berücksichtigen und zur Entscheidungsfindung zu verwenden, oder um Informationen in elektronischer Form, die von einem Computer gespeichert und verwendet werden können. Nun lernen wir die Definition von Data Science und Machine Learning.

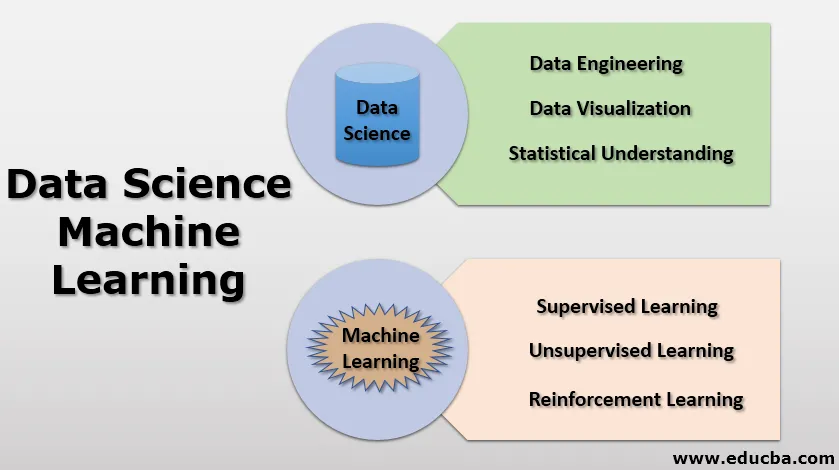

Data Science (DS) : Es ist ein sehr weites Feld, in dem verschiedene Techniken wie statistische Methoden, wissenschaftliche Ansätze, Architekturprozesse und eine Vielzahl von Algorithmen verwendet werden, um aufschlussreiche Informationen aus verfügbaren Daten zu extrahieren, die entweder strukturierte oder unstrukturierte Daten sein können.

Maschinelles Lernen ( ML ): Dies ist eine Teilmenge von Data Science. Beim maschinellen Lernen werden Maschinen grundsätzlich mit Hilfe statistischer Modelle und verschiedener Algorithmen trainiert, ohne explizite Anweisungen zu geben. Sie basieren auf Mustern, die mit Daten erstellt wurden. “

Bedeutung von Data Science

- Wir leben in einem Zeitalter der Technologie, in dem jeder Mensch auf die eine oder andere Weise Technologie für Komfort / Effektivität / Leichtigkeit einsetzt, z. B. für Mobiltelefone / Laptops / Tablets für die Kommunikation, Autos / Züge / Busse / Flugzeuge für den Transport, Dienstleistungen wie Banken / Strom und vieles mehr für mehr Lebenskomfort.

- Bei jeder dieser Gelegenheiten erstellen wir wissentlich oder unwissentlich Daten wie Anrufprotokolle / Texte / soziale Medien - Bilder / Videos / Blogs sind alle Teil der Daten, wobei der Transport unserer Navigation zu verschiedenen Orten über GPS / die Leistung des Fahrzeugs auch über das Steuergerät aufgezeichnet wird Teil der Daten. Unsere Transaktionen mit Bank- und Geldbörsen generieren eine enorme Datenmenge. Der Stromverbrauch in einem beliebigen Bereich oder einer Branche ist ebenfalls Teil der Daten.

- Und diese Daten nehmen exponentiell von Tag zu Tag oder von Minute zu Minute zu.

- Nun stellt sich die Frage, ob wir mit diesen Daten etwas anfangen können. Können wir diese Daten nutzen, um nützliche Erkenntnisse zu gewinnen? Können wir die Wirksamkeit steigern? Können wir diese Daten verwenden, um zukünftige Ergebnisse vorherzusagen?

- Um all diese Fragen zu beantworten, haben wir ein Gebiet namens Data Science.

- Data Science kann als ein weites Feld betrachtet werden, das Data Mining, Data Engineering, Datenvisualisierung, statistische Datenintegrationsmethoden, R / Python / SQL-Programmierung, maschinelles Lernen, Big Data und mehr umfasst.

Lassen Sie uns nun die wichtigen Konzepte der Datenwissenschaft verstehen.

1. Daten-Engineering

Das Data Engineering ist ein Aspekt der Datenwissenschaft, der sich hauptsächlich auf Anwendungen von Daten, Datenerfassung und Datenanalyse konzentriert. Alle Arbeiten, die Datenwissenschaftler ausführen, um verschiedene Fragen im Zusammenhang mit Vorhersagen oder Analysen zu beantworten, verwenden eine große Menge an Informationen.

Was sie jetzt brauchen, sind richtige und nützliche Informationen, wodurch die Notwendigkeit entsteht, die verfügbaren Informationen zu sammeln und zu validieren. All dies ist Teil der Engineering-Aufgaben. Einige dieser Aufgaben sind das Überprüfen auf Nullwerte (fehlende Daten), das Kategorisieren der Daten (kategoriale Daten), das Erstellen von Datenstrukturen (Zuordnungsregeln) usw.

2. Datenvisualisierung

Die Datenvisualisierung ist ein grafischer Ansatz zur Darstellung der Daten. Hier verwenden wir die eingebaute Bibliothek von Python, um visuelle Elemente wie Tabellen, Korrelationsdiagramme, Balkendiagramme, Paardiagramme usw. zu erstellen. Die Datenvisualisierung spielt eine sehr wichtige Rolle, um die Daten auf einfache Weise zu analysieren, Trends zu erkennen und zu verstehen aus den Ausreißern usw.

3. Statistisches Verständnis

Statistiken spielen im Bereich der Datenwissenschaft eine sehr wichtige Rolle. Statistik ist ein sehr leistungsfähiges Werkzeug zur Durchführung der Aufgaben von Data Science (DS). Statistiken verwenden Mathematik, um die verfügbaren Informationen technisch zu analysieren. Mit Visualisierungen wie Balken oder Diagrammen können wir die Trendinformationen abrufen, Statistiken helfen uns jedoch dabei, die Daten auf mathematische / gezielte Weise zu verarbeiten. Ohne Datenkenntnisse ist die Wissenschaftsvisualisierung nur ein Ratespiel.

Wir werden einige wichtige statistische Methoden diskutieren, die von Datenwissenschaftlern täglich verwendet werden.

- Mittelwert: Der Mittelwert ist im Wesentlichen ein Durchschnitt aller Daten, der berechnet wird, indem alle Datenelemente addiert und anschließend durch eine Reihe von Elementen dividiert werden. Dient zum Identifizieren des Mittenwerts aller Elemente.

- Median: Median wird auch zum Ermitteln des Mittelwerts der verfügbaren Elemente verwendet. Hier werden jedoch alle Daten in einer Reihenfolge angeordnet und der genaue Mittelwert wird als Median betrachtet.

Wenn die Anzahl der Elemente ungerade ist, ist der Median ((n + 1) / 2). Wenn eine Anzahl von Elementen gerade ist, ist der Median ((n / 2) + 1).

- Modus: Modus ist ein statistischer Parameter, der auf den häufigsten Wert hinweist, oder der Wert, der am häufigsten auftritt, wird als Modus behandelt.

- Standardabweichung: Die Standardabweichung gibt an, wie viel Streuung in den Daten vorhanden ist, oder ist ein Maß für die Festlegung der Streuung anhand der Mittelwerte oder des Durchschnittswerts oder des erwarteten Werts.

Wenn wir eine niedrige Standardabweichung haben, zeigt dies an, dass die meisten Datenwerte nahe am Durchschnittswert liegen. Wenn wir eine hohe Standardabweichung haben, bedeutet dies, dass unsere Datenwerte stärker vom Mittelwert abweichen.

- Varianz: Die Varianz entspricht der Standardabweichung mit einem kleinen Unterschied. Sie ist ein Quadrat der Standardabweichung. Die Standardabweichung wird von der Varianz abgeleitet, da die Standardabweichung die Streuung in Bezug auf Daten darstellt, während die Varianz die Streuung mit einem Quadrat darstellt. Es ist einfach, die Streuung anhand der Varianz zu korrelieren.

- Korrelation: Die Korrelation ist eine der wichtigsten statistischen Kennzahlen. Sie gibt an, wie die Variablen im Datensatz zusammenhängen. Wenn wir einen Parameter ändern, wirkt sich dies auf den anderen Parameter aus.

Wenn wir einen positiven Korrelationswert haben, werden die Variablen entweder parallel zunehmen oder abnehmen

Wenn wir einen negativen Korrelationswert haben, bedeutet dies, dass sich die Variablen umgekehrt verhalten und sich gegenseitig verringern und umgekehrt.

In der Statistik haben wir eine Wahrscheinlichkeitsverteilung, Bayes'sche Statistiken und Hypothesentests, die auch für einen Datenwissenschaftler sehr wichtige Werkzeuge sind.

Maschinelles Lernen

Maschinelles Lernen ist im Grunde eine Methode, mit der Maschinen anhand von Eingabemerkmalen lernen und Ausgaben erzeugen können.

Definition: „Maschinelles Lernen ist ein Studienbereich, in dem Computer aus verfügbaren Daten / historischen Daten lernen, ohne explizit programmiert zu werden.“

Beim maschinellen Lernen liegt der Schwerpunkt auf der Automatisierung und Verbesserung des Lernprozesses von Computern auf der Grundlage ihrer Eingabedatenerfahrungen, und wir werden den Code nicht explizit für jede Art von Problem programmieren, dh, die Maschine wird herausfinden, wie sie das Problem angehen soll. Hier sind die Ergebnisse möglicherweise nicht genau, aber es kann eine gute Vorhersage getroffen werden.

Verstehen wir es so:

Traditionell werden Computer verwendet, um den Berechnungsprozess zu vereinfachen. Also, wenn wir irgendeine arithmetische Berechnung haben. Was werden wir tun? Wir werden ein Computerprogramm vorbereiten, das diesen Vorgang auf einfache und schnelle Weise löst. Wenn wir beispielsweise zwei Entitäten hinzufügen möchten, erstellen wir einen Teil des Software-Codes, der zwei Eingaben übernimmt, und in der Ausgabe wird die Summe angezeigt.

Beim Ansatz des maschinellen Lernens wird anstelle der Eingabe eines direkten Algorithmus ein spezieller Algorithmus in den Softwarecode eingefügt, der versucht, ein Muster zu erkennen, und anhand dieser Muster versucht, die bestmögliche Ausgabe vorherzusagen. Hier codieren wir keinen Algorithmus explizit für eine bestimmte Operation, sondern geben Daten an eine Maschine weiter, um zu erfahren, was das Muster ist und was die Ausgabe sein könnte.

Warum müssen wir uns nun für diesen Ansatz entscheiden, wenn wir die genauen Ergebnisse direkt erhalten können, indem wir nur den genauen Algorithmus codieren? Die exakten Algorithmen sind komplex und begrenzt. Lassen Sie es uns aus einer anderen Perspektive betrachten. Dies ist eine Ära, in der wir eine Fülle von Daten haben und die jeden Tag explodiert, wie wir im vorherigen Abschnitt besprochen haben. Hier beschäftigen wir uns mit überwachtem und unbeaufsichtigtem Lernen.

Maschinelles Lernen ist heutzutage von akutem Interesse, da wir über eine Fülle von Daten verfügen. Um diese Daten zu verstehen, benötigen wir einige aussagekräftige Ergebnisse oder Muster, die analysiert und in die Praxis umgesetzt werden können.

Aber warum interessieren wir uns trotzdem für maschinelles Lernen und diese Daten?

Wir wissen, dass die Menschheit die Geschichte wiederholt, als wären wir die gleichen wie unsere vorherigen Generationen, und unsere Nachkommen werden auch mit mehreren Situationen konfrontiert sein, mit denen wir jetzt konfrontiert sind oder denen wir konfrontiert sind. Zu diesem Zeitpunkt müssen wir uns vorstellen, wie wir mit historischen Daten auf die Zukunft reagieren sollen.

Jetzt wissen wir also, dass Daten ein sehr wertvolles Gut sind.

Die Herausforderung besteht darin, wie wir diese verfügbaren Daten am besten nutzen können.

Dies ist das interessanteste Thema (Wie?), In dem wir die verfügbaren Daten verstehen. Grundsätzlich gibt es 3 Ansätze für maschinelles Lernen:

- Überwachtes Lernen

- Unbeaufsichtigtes Lernen

- Verstärkung lernen

Diese drei Ansätze werden zum Erstellen eines maschinellen Lernmodells verwendet (lineare Regression, logistische Regression, zufällige Gesamtstruktur, Entscheidungsbäume usw.).

Es gibt eine Vielzahl von Anwendungen für diese Modelle des maschinellen Lernens, zum Beispiel:

- Finanzen: Betrugserkennung

- Marketing / Vertrieb: Personalisieren Sie die Empfehlung

- Gesundheitswesen: Identifizieren Sie den Krankheitsverlauf.

Fazit - Data Science Machine Learning

- Data Science ist ein weites Feld, in dem maschinelles Lernen eine Teilmenge darstellt. Dabei analysieren wir die uns vorliegenden historischen Daten und versuchen, die wahrscheinlichsten zukünftigen Ergebnisse vorherzusagen.

- Um vorherzusagen, dass wir die Daten bereinigen müssen, ordnen Sie die Daten (Data Engineering). Mit den vorliegenden Daten visualisieren wir die Muster / Trends und schließen dann mit statistischem Verständnis aufschlussreiche Informationen.

- Diese Daten werden mithilfe eines maschinellen Lernalgorithmus einer Maschine zugeführt.

- Diese Algorithmen trainieren die Maschine und erstellen ein maschinelles Lernmodell.

- Dieses Modell kann dann zur Vorhersage verwendet werden.

Empfohlene Artikel

Dies ist ein Leitfaden für Data Science Machine Learning. Hier diskutieren wir die Bedeutung der Datenwissenschaft zusammen mit maschinellem Lernen. Sie können sich auch die folgenden Artikel ansehen, um mehr zu erfahren -

- Beste Data Science-Programme

- Data Science Skills

- Data Science Languages

- Maschinelles Lernen

- Was ist Datenintegration?

- Wie das Balkendiagramm in Matlab verwendet wird (Beispiele)

- Entscheidungsbaum im maschinellen Lernen

- Einfache Möglichkeiten zum Erstellen eines Entscheidungsbaums