Überblick über die Installation von Hadoop

Der folgende Artikel, Installieren von Hadoop, bietet einen Überblick über die gängigsten Hadoop-Framework-Schlüsselmodule und die schrittweise Installation für Hadoop. Der Apache Hadoop ist eine Sammlung von Software, die die Verarbeitung großer Datenmengen und verteilten Speichers in einem Cluster verschiedener Computersystemtypen ermöglicht. Derzeit ist Hadoop die am weitesten verbreitete Analyseplattform für Big Data („Sanchita Lobo, Autorin im Analytics Training Blog“, nd).

Hadoop Framework

Das Apache Hadoop-Framework besteht aus den folgenden Schlüsselmodulen.

- Apache Hadoop Common.

- Apache Hadoop Distributed File System (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (Ein weiterer Ressourcenmanager).

Apache Hadoop Common

Das Apache Hadoop Common-Modul besteht aus gemeinsam genutzten Bibliotheken, die für alle anderen Module verwendet werden, einschließlich Schlüsselverwaltung, generischen E / A-Paketen, Bibliotheken für die Erfassung von Metriken und Dienstprogrammen für Registrierung, Sicherheit und Streaming.

HDFS

Das HDFS basiert auf dem Google-Dateisystem und kann auf kostengünstiger Hardware ausgeführt werden. HDFS ist fehlertolerant und wurde für Anwendungen mit großen Datenmengen entwickelt.

Karte verkleinern

MapReduce ist ein inhärentes paralleles Programmiermodell für die Datenverarbeitung, und Hadoop kann MapReduce-Programme ausführen, die in verschiedenen Sprachen wie Java geschrieben sind. MapReduce teilt die Verarbeitung in die Kartenphase auf und reduziert die Phase.

Apache Hadoop GARN

Apache Hadoop YARN ist eine Kernkomponente und ist Ressourcenmanagement- und Job Scheduling-Technologie im Hadoop Distributed Processing Framework.

In diesem Artikel werden wir die Installation und Konfiguration von Hadoop 2.7.4 auf einem einzelnen Knotencluster erläutern und die Konfiguration testen, indem wir das MapReduce-Programm mit dem Namen wordcount ausführen, um die Anzahl der Wörter in der Datei zu zählen. Wir werden uns einige wichtige Hadoop File System-Befehle genauer ansehen.

Schritte zum Installieren von Hadoop

Das Folgende ist eine Zusammenfassung der Aufgaben, die mit der Konfiguration von Apache Hadoop verbunden sind.

Aufgabe 1: Die erste Aufgabe in der Hadoop-Installation umfasste das Einrichten einer Vorlage für eine virtuelle Maschine, die mit Cent OS7 konfiguriert wurde. Pakete wie Java SDK 1.8 und Laufzeitsysteme, die zum Ausführen von Hadoop erforderlich sind, wurden heruntergeladen, und die Java-Umgebungsvariable für Hadoop wurde durch Bearbeiten von bash_rc konfiguriert.

Aufgabe 2: Das Hadoop Release 2.7.4-Paket wurde von der Apache-Website heruntergeladen und im opt-Ordner extrahiert. Welches dann als Hadoop für einfachen Zugang umbenannt wurde.

Aufgabe 3: Nachdem die Hadoop-Pakete extrahiert wurden, wurde im nächsten Schritt die Umgebungsvariable für den Hadoop-Benutzer konfiguriert und anschließend die XML-Dateien des Hadoop-Knotens konfiguriert. In diesem Schritt wurde NameNode in core-site.xml und DataNode in hdfs-site.xml konfiguriert. Der Ressourcenmanager und der Knotenmanager wurden in yarn-site.xml konfiguriert.

Aufgabe 4: Die Firewall wurde deaktiviert, um YARN und DFS zu starten. Mit dem JPS-Befehl wurde überprüft, ob relevante Dämonen im Hintergrund ausgeführt werden. Die Portnummer für den Zugriff auf Hadoop wurde auf http: // localhost: 50070 / konfiguriert.

Aufgabe 5: In den nächsten Schritten wurde Hadoop überprüft und getestet. Zu diesem Zweck haben wir eine temporäre Testdatei im Eingabeverzeichnis für das WordCount-Programm erstellt. Map-Reduce-Programm Hadoop-MapReduce-examples2.7.4.jar wurde verwendet, um die Anzahl der Wörter in der Datei zu zählen. Die Ergebnisse wurden auf dem lokalen Host ausgewertet und die Protokolle des eingereichten Antrags analysiert. Alle eingereichten MapReduce-Anwendungen können über die Online-Benutzeroberfläche angezeigt werden. Die Standardportnummer lautet 8088.

Aufgabe 6: In der letzten Aufgabe werden einige grundlegende Hadoop-Dateisystembefehle eingeführt und deren Verwendung überprüft. Wir werden sehen, wie ein Verzeichnis innerhalb des Hadoop-Dateisystems erstellt werden kann, um den Inhalt eines Verzeichnisses in Bytes aufzulisten. Wir werden weiter sehen, wie man ein bestimmtes Verzeichnis und eine bestimmte Datei löscht.

Ergebnisse in der Hadoop-Installation

Das Folgende zeigt die Ergebnisse jeder der oben genannten Aufgaben:

Ergebnis von Aufgabe 1

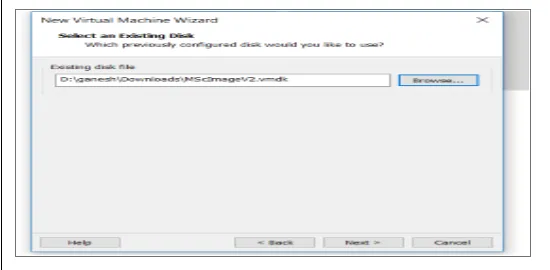

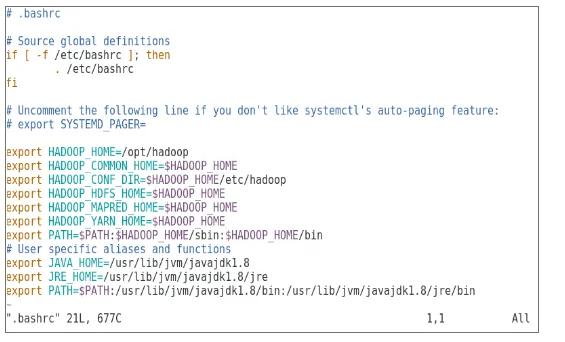

Eine neue virtuelle Maschine mit einem cenOS7-Image wurde für die Ausführung von Apache Hadoop konfiguriert. Abbildung 1 zeigt, wie das CenOS 7-Image in der virtuellen Maschine konfiguriert wurde. Abbildung 1.2 zeigt die Konfiguration der JAVA-Umgebungsvariablen in .bash_rc.

Abbildung 1: Konfiguration der virtuellen Maschine

Abbildung 1.2: Konfiguration der Java-Umgebungsvariablen

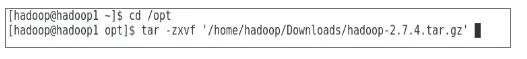

Ergebnis von Aufgabe 2

Abbildung 2 zeigt die Aufgabe, die ausgeführt wird, um das Hadoop 2.7.4-Paket in den Ordner opt zu extrahieren.

Abbildung 2: Extraktion des Pakets Hadoop 2.7.4

Ergebnis von Aufgabe 3

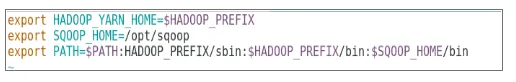

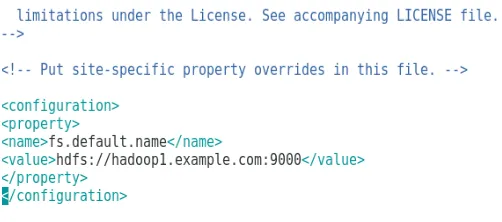

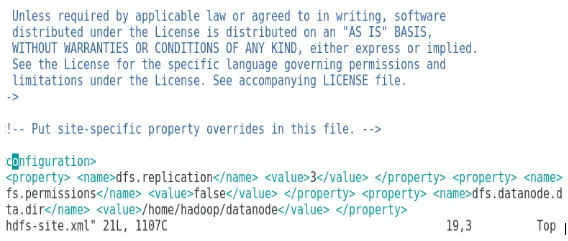

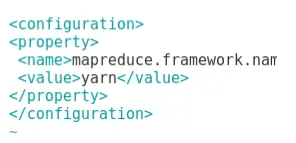

Abbildung 3 zeigt die Konfiguration für die Umgebungsvariable für Hadoop-Benutzer. Abbildung 3.1 bis 3.4 zeigen die Konfiguration für XML-Dateien, die für die Hadoop-Konfiguration erforderlich sind.

Abbildung 3: Konfigurieren der Umgebungsvariablen für Hadoop-Benutzer

Abbildung 3.1: Konfiguration von core-site.xml

Abbildung 3.2: Konfiguration von hdfs-site.xml

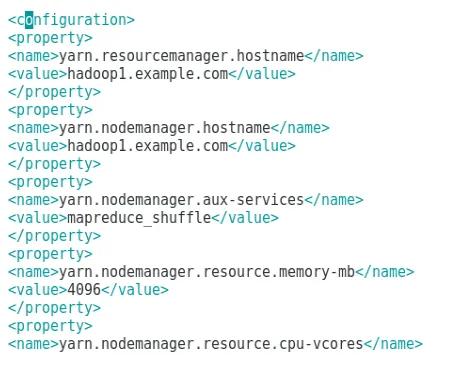

Abbildung 3.3: Konfiguration der Datei mapred-site.xml

Abbildung 3.4: Konfiguration der Datei yarn-site.xml

Ergebnis von Aufgabe 4

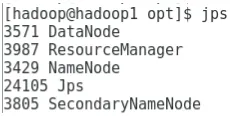

Abbildung 4 zeigt die Verwendung des Befehls jps, um zu überprüfen, ob relevante Dämonen im Hintergrund ausgeführt werden. Die folgende Abbildung zeigt die Online-Benutzeroberfläche von Hadoop.

Abbildung 4: Befehl jps zum Überprüfen der Ausführung von Daemons.

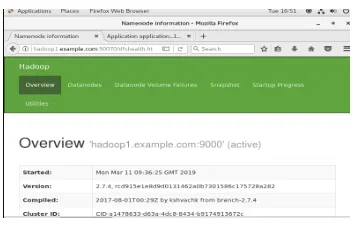

Abbildung 4.1: Zugriff auf die Hadoop-Online-Oberfläche über Port http://hadoop1.example.com:50070/

Ergebnis von Aufgabe 5

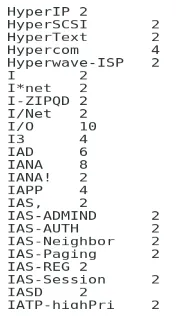

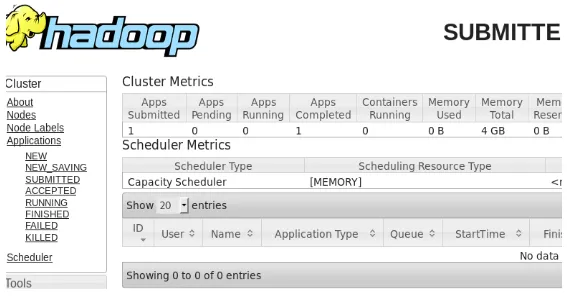

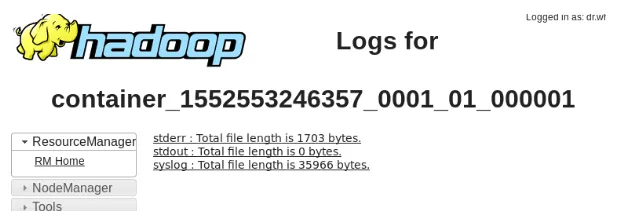

Abbildung 5 zeigt das Ergebnis für das MapReduce-Programm wordcount, das die Anzahl der Wörter in der Datei zählt. In den nächsten Abbildungen wird die Online-Benutzeroberfläche des YARN-Ressourcenmanagers für die übermittelte Aufgabe angezeigt.

Abbildung 5: Ergebnisse des MapReduce-Programms

Abbildung 5.1: Übermittelter Antrag auf Kartenreduzierung

Abbildung 5.2: Protokolle für die eingereichte MapReduce-Anwendung.

Ergebnis von Aufgabe 6

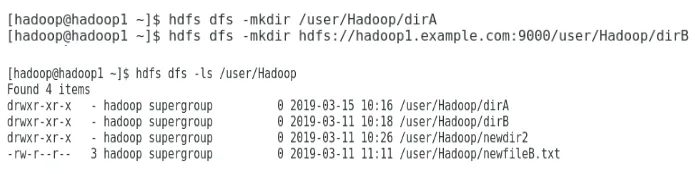

Abbildung 6 zeigt, wie Sie ein Verzeichnis im Hadoop-Dateisystem erstellen und eine Auflistung des hdfs-Verzeichnisses durchführen.

Abbildung 6: Erstellen eines Verzeichnisses im Hadoop-Dateisystem

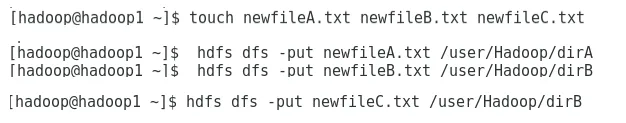

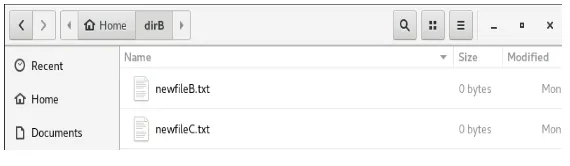

Abbildung 6.1 zeigt, wie eine Datei in das verteilte Hadoop-Dateisystem eingefügt wird, und Abbildung 6.2 zeigt die erstellte Datei im Verzeichnis dirB.

Abbildung 6.1: Erstellen einer Datei in HDFS.

Abbildung 6.2: Neue Datei erstellt.

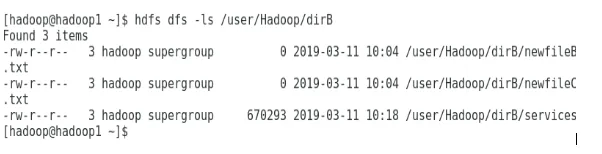

Die folgenden Abbildungen zeigen, wie Sie den Inhalt bestimmter Verzeichnisse auflisten:

Abbildung 6.3: Inhalt von dirA

Abbildung 6.4: Inhalt von dirB

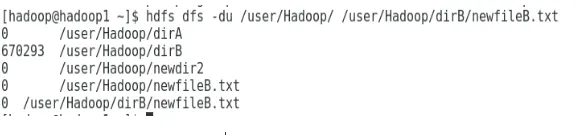

Die nächste Abbildung zeigt, wie die Größe von Dateien und Verzeichnissen angezeigt werden kann:

Abbildung 6.5: Anzeigen einer Datei- und Verzeichnisgröße

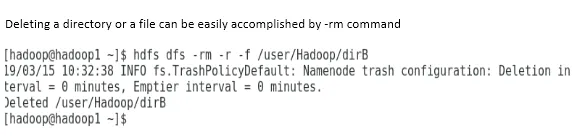

Das Löschen eines Verzeichnisses oder einer Datei kann einfach mit dem Befehl -rm ausgeführt werden.

Abbildung 6.6: Löschen einer Datei

Fazit

Big Data hat den heutigen Weltmarkt entscheidend mitgeprägt. Das Hadoop-Framework vereinfacht die Arbeit von Datenanalysten bei der Arbeit an großen Datasets. Die Konfiguration von Apache Hadoop war recht einfach und die Online-Benutzeroberfläche bot dem Benutzer mehrere Optionen zum Optimieren und Verwalten der Anwendung. Hadoop wurde in Unternehmen in großem Umfang für Datenspeicherung, Analyse des maschinellen Lernens und Datensicherung eingesetzt. Das Verwalten einer großen Datenmenge war aufgrund der verteilten Hadoop-Umgebung und MapReduce recht praktisch. Die Entwicklung von Hadoop war im Vergleich zu relationalen Datenbanken erstaunlich, da es ihnen an Optimierungs- und Leistungsoptionen mangelt. Apache Hadoop ist eine benutzerfreundliche und kostengünstige Lösung für die effiziente Verwaltung und Speicherung von Big Data. HDFS leistet auch einen wichtigen Beitrag zum Speichern von Daten.

Empfohlene Artikel

Dies ist eine Anleitung zur Installation von Hadoop. Hier diskutieren wir die Einführung in Instal Hadoop, die schrittweise Installation von Hadoop zusammen mit den Ergebnissen der Hadoop-Installation. Sie können auch unsere anderen Artikelvorschläge durchgehen, um mehr zu erfahren -

- Einführung in Hadoop Streaming

- Was ist Hadoop Cluster und wie funktioniert es?

- Apache Hadoop-Ökosystem und seine Komponenten

- Was sind die Hadoop-Alternativen?