Was ist Hadoop?

Bevor Sie die Vorteile von Hadoop verstehen, sollten Sie zunächst den Hadoop verstehen. Hadoop ist ein Paradigma für die Verarbeitung großer Datenmengen, das einen zuverlässigen, skalierbaren Ort für die Speicherung und Verarbeitung von Daten bietet. Hadoop wurde von Doug Cutting kreiert und gilt als „Vater von Hadoop“. Hadoop war der Name des Spielzeugelefanten seines Sohnes. Hadoop hatte seine Wurzeln im Nutch Search Engine Project. Hadoop ist ein Verarbeitungsframework, das enorme Änderungen in der Art und Weise mit sich gebracht hat, wie wir die Daten verarbeiten und speichern. Im Vergleich zu herkömmlichen Verarbeitungswerkzeugen wie RDBMS hat Hadoop bewiesen, dass wir die Herausforderungen von Big Data wie

Vielzahl von Daten: Hadoop kann strukturierte sowie halbstrukturierte und unstrukturierte Datenformate speichern und verarbeiten.

Das Datenvolumen: Hadoop wurde speziell für das riesige Datenvolumen im Petabyte-Bereich entwickelt.

Die Geschwindigkeit der Daten : Hadoop kann Petabytes an Daten mit hoher Geschwindigkeit verarbeiten, verglichen mit anderen Verarbeitungswerkzeugen wie RDBMS, dh die Verarbeitungszeit in Hadoop ist sehr viel kürzer.

Auffallende Merkmale von Hadoop

- Hadoop ist Open Source in der Natur.

- Es funktioniert auf einem Cluster von Maschinen. Die Größe des Clusters hängt von den Anforderungen ab.

- Es kann auf normaler Standardhardware ausgeführt werden.

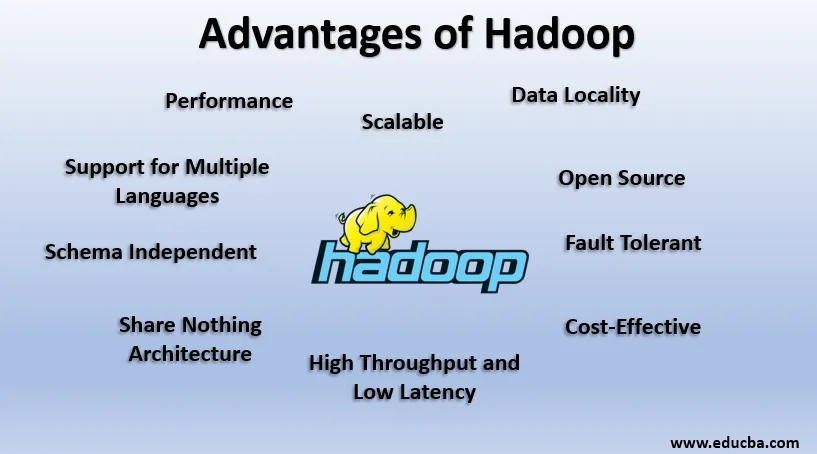

Vorteile von Hadoop

In diesem Abschnitt werden die Vorteile von Hadoop erläutert. Nun schauen wir sie uns nacheinander an:

1. Open Source

Hadoop ist Open Source, dh der Quellcode ist frei verfügbar. Wir können den Quellcode gemäß unseren Geschäftsanforderungen ändern. Sogar proprietäre Versionen von Hadoop wie Cloudera und Horton sind verfügbar.

2. Skalierbar

Hadoop arbeitet mit dem Cluster von Maschinen. Hadoop ist hoch skalierbar. Wir können die Größe unseres Clusters erhöhen, indem wir neue Knoten nach Bedarf ohne Ausfallzeiten hinzufügen. Diese Art des Hinzufügens neuer Computer zum Cluster wird als horizontale Skalierung bezeichnet, während zunehmende Komponenten wie das Verdoppeln von Festplatte und RAM als vertikale Skalierung bezeichnet werden.

3. Fehlertolerant

Fehlertoleranz ist das herausragende Merkmal von Hadoop. Standardmäßig hat jeder Block in HDFS einen Replikationsfaktor von 3. Für jeden Datenblock erstellt HDFS zwei weitere Kopien und speichert sie an einem anderen Ort im Cluster. Wenn ein Block aufgrund eines Maschinenfehlers verloren geht, haben wir noch zwei Kopien desselben Blocks und diese werden verwendet. Auf diese Weise wird in Hadoop Fehlertoleranz erreicht.

4. Schemaunabhängig

Hadoop kann mit verschiedenen Datentypen arbeiten. Es ist flexibel genug, um verschiedene Datenformate zu speichern und kann sowohl Daten mit Schema (strukturiert) als auch Daten ohne Schema (unstrukturiert) verarbeiten.

5. Hoher Durchsatz und niedrige Latenz

Durchsatz bedeutet Arbeitsaufwand pro Zeiteinheit und niedrige Latenz bedeutet, dass die Daten ohne oder mit geringer Verzögerung verarbeitet werden. Da Hadoop vom Prinzip der verteilten Speicherung und der parallelen Verarbeitung angetrieben wird, erfolgt die Verarbeitung für jeden Datenblock gleichzeitig und unabhängig voneinander. Anstatt Daten zu verschieben, wird Code auch in Daten im Cluster verschoben. Diese beiden Faktoren tragen zu hohem Durchsatz und geringer Latenz bei.

6. Datenlokalität

Hadoop arbeitet nach dem Prinzip „Bewegen Sie den Code, nicht die Daten“. In Hadoop bleiben Daten stationär und zur Verarbeitung von Daten wird Code in Form von Tasks in Daten verschoben. Dies wird als Datenlokalität bezeichnet. Da es sich um Daten im Petabyte-Bereich handelt, ist das Verschieben der Daten über das Netzwerk sowohl schwierig als auch teuer. Durch die Datenlokalität wird sichergestellt, dass die Datenverschiebung im Cluster minimal ist.

7. Leistung

In Legacy-Systemen wie RDBMS werden Daten nacheinander verarbeitet, in Hadoop wird jedoch die Verarbeitung für alle Blöcke gleichzeitig gestartet, wodurch die parallele Verarbeitung bereitgestellt wird. Aufgrund der Parallelverarbeitungstechniken ist die Leistung von Hadoop viel höher als bei Legacy-Systemen wie RDBMS. 2008 besiegte Hadoop sogar den damals schnellsten Supercomputer.

8. Teilen Sie nichts Architektur

Jeder Knoten im Hadoop-Cluster ist unabhängig voneinander. Sie teilen keine Ressourcen oder Speicher, diese Architektur wird als Share Nothing Architecture (SN) bezeichnet. Wenn ein Knoten im Cluster ausfällt, wird nicht der gesamte Cluster heruntergefahren, da jeder Knoten unabhängig agiert und somit ein einzelner Fehlerpunkt beseitigt wird.

9. Unterstützung für mehrere Sprachen

Obwohl Hadoop hauptsächlich in Java entwickelt wurde, erweitert es die Unterstützung für andere Sprachen wie Python, Ruby, Perl und Groovy.

10. Kostengünstig

Hadoop ist von Natur aus sehr sparsam. Wir können einen Hadoop-Cluster mit normaler Standardhardware erstellen und so die Hardwarekosten senken. Laut der Cloud-Ära sind die Datenverwaltungskosten von Hadoop, dh sowohl Hardware- als auch Softwarekosten und sonstige Kosten, im Vergleich zu herkömmlichen ETL-Systemen sehr gering.

11. Abstraktion

Hadoop bietet Abstraktion auf verschiedenen Ebenen. Dies erleichtert Entwicklern die Arbeit. Eine große Datei wird in gleich große Blöcke aufgeteilt und an verschiedenen Stellen des Clusters gespeichert. Während der Erstellung der Kartenreduzierungsaufgabe müssen wir uns um die Position der Blöcke kümmern. Wir geben eine vollständige Datei als Eingabe und das Hadoop-Framework kümmert sich um die Verarbeitung verschiedener Datenblöcke, die sich an verschiedenen Orten befinden. Hive ist ein Teil des Hadoop-Ökosystems und eine Abstraktion über Hadoop. Da Map-Reduce-Aufgaben in Java geschrieben wurden, konnten SQL-Entwickler auf der ganzen Welt Map Reduce nicht nutzen. Daher wird Hive eingeführt, um dieses Problem zu beheben. Wir können SQL-ähnliche Abfragen auf Hive schreiben, was wiederum Map Reduction-Jobs auslöst. Dank Hive kann die SQL-Community nun auch an Map Reduce Tasks arbeiten.

12. Kompatibilität

In Hadoop ist HDFS die Speicherebene und Map Reduce die Verarbeitungsengine. Es gibt jedoch keine strenge Regel, dass Map Reduce die Standardverarbeitungsengine sein sollte. Neue Verarbeitungsframeworks wie Apache Spark und Apache Flink verwenden HDFS als Speichersystem. Selbst in Hive können wir unsere Execution Engine gemäß unseren Anforderungen in Apache Tez oder Apache Spark ändern. Apache HBase, die NoSQL Columnar Database, verwendet HDFS für die Speicherebene.

13. Unterstützung für verschiedene Dateisysteme

Hadoop ist von Natur aus sehr flexibel. Es kann verschiedene Datenformate wie Bilder, Videos, Dateien usw. aufnehmen. Es kann auch strukturierte und unstrukturierte Daten verarbeiten. Hadoop unterstützt verschiedene Dateisysteme wie JSON, XML, Avro, Parkett usw.

Arbeiten von Hadoop

Die folgenden Punkte zeigen, wie Hadoop funktioniert:

1. Verteilte Speicherung und Parallelverarbeitung

Dies ist das Antriebsprinzip aller Frameworks des Hadoop-Ökosystems, einschließlich Apache Spark. Um die Funktionsweise von Hadoop und Spark zu verstehen, sollten wir zunächst verstehen, was „verteilter Speicher und parallele Verarbeitung“ ist.

2. Verteilter Speicher

Hadoop speichert keine Daten auf einer einzelnen Maschine. Stattdessen werden diese großen Datenmengen in gleich große Blöcke von standardmäßig 256 MB aufgeteilt und in verschiedenen Knoten eines Clusters (Worker-Knoten) gespeichert. Es speichert die Metadaten dieser Blöcke im Masterknoten. Diese Art der Speicherung der Datei an verteilten Speicherorten in einem Cluster wird als Hadoop Distributed File System - HDFS bezeichnet.

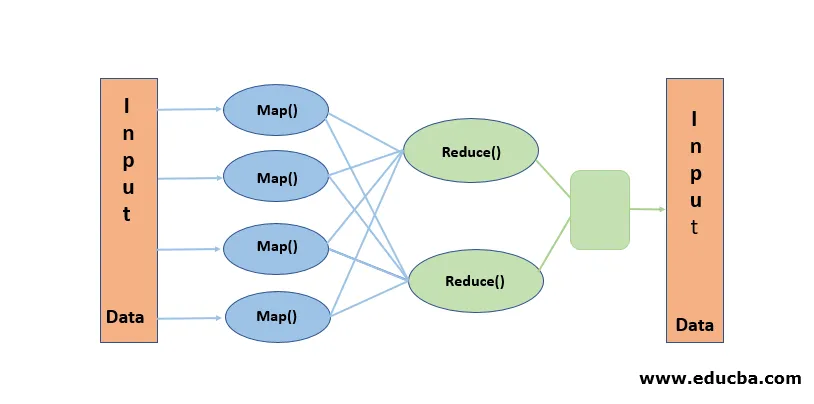

3. Parallelverarbeitung

Es ist ein Verarbeitungsparadigma, bei dem die Verarbeitung der in HDFS gespeicherten Datenblöcke gleichzeitig erfolgt. Die parallele Verarbeitung basiert auf dem Begriff „Code verschieben, nicht Daten“. Daten bleiben in HDFS stationär, aber Code wird zur Verarbeitung in Daten verschoben. In einfachen Worten, wenn unsere Datei in 100 Blöcke unterteilt ist, werden 100 Kopien des Jobs erstellt und sie werden über den Cluster an den Speicherort übertragen, an dem sich der Block befindet, und die Verarbeitung von 100 Blöcken beginnt gleichzeitig (Kartenphase). Die Ausgabedaten aller Blöcke werden gesammelt und auf die endgültige Ausgabe reduziert (Reduce Phase). Map Reduce gilt als "Herz von Hadoop".

Fazit-Vorteile von Hadoop

In diesem Datenzeitalter ebnete Hadoop den Weg für eine andere Herangehensweise an die Herausforderungen, die Big Data mit sich bringt. Wenn wir sagen, Hadoop ist nicht nur Hadoop, sondern es enthält Hadoop-Ökosystem-Tools wie Apache Hive, die SQL-ähnliche Operationen auf Hadoop, Apache Pig, Apache HBase für spaltenbasierte Speicherdatenbanken, Apache Spark für die In-Memory-Verarbeitung und viele mehr bereitstellen Mehr. Obwohl Hadoop seine eigenen Nachteile hat, ist es hochgradig anpassungsfähig und entwickelt sich mit jeder Veröffentlichung ständig weiter.

Empfohlene Artikel

Dies ist eine Anleitung zu den Vorteilen von Hadoop. Hier diskutieren wir, was der Hadoop und die Hauptvorteile von Hadoop sind. Sie können auch unsere anderen verwandten Artikel durchgehen, um mehr zu erfahren.

- HADOOP Framework

- Was ist Hadoop Cluster?

- Was ist MapReduce in Hadoop?

- Hadoop-Datenbank

- Was ist Hadoop? | Anwendungen und Funktionen