Unterschied zwischen Apache Storm und Apache Spark

Apache Storm ist ein Open Source, skalierbares, fehlertolerantes und verteiltes Echtzeit-Rechensystem. Apache Storm konzentriert sich auf die Stream- oder Ereignisverarbeitung. Apache Storm implementiert eine fehlertolerante Methode zum Durchführen einer Berechnung oder zum Pipelining mehrerer Berechnungen für ein Ereignis, während es in ein System fließt. Apache Spark ist ein blitzschnelles Framework für die Cluster-Computing-Technologie, das für die schnelle Berechnung von Daten in großem Umfang entwickelt wurde. Apache Spark ist eine verteilte Verarbeitungsengine, verfügt jedoch nicht über einen integrierten Cluster-Ressourcenmanager und ein verteiltes Speichersystem. Sie müssen einen Cluster-Manager und ein Speichersystem Ihrer Wahl anschließen.

Einführung in Apache Storm vs Apache Spark:

- Apache Storm ist eine aufgabenparallele kontinuierliche Rechenmaschine. Es definiert seine Workflows in gerichteten azyklischen Diagrammen (Directed Acyclic Graphs, DAGs), die als Topologien bezeichnet werden. Diese Topologien werden ausgeführt, bis der Benutzer sie herunterfährt oder ein nicht behebbarer Fehler auftritt. Apache Storm wird nicht auf Hadoop-Clustern ausgeführt, sondern verwendet Zookeeper und seinen eigenen Minion Worker, um seine Prozesse zu verwalten. Apache Storm kann Dateien in HDFS lesen und schreiben.

- Apache Storm lässt sich in die Warteschlangen- und Datenbanktechnologien integrieren, die Sie bereits verwenden. Eine Storm-Topologie verwendet Datenströme und verarbeitet diese Datenströme auf beliebig komplexe Weise. Dabei werden die Datenströme nach Bedarf zwischen den einzelnen Stufen der Berechnung neu aufgeteilt. Apache Storm basiert auf Tupeln und Streams. Ein Tupel ist im Grunde genommen, was Ihre Daten sind und wie sie strukturiert sind.

- Das Apache Spark- Framework besteht aus Spark Core und einer Reihe von Bibliotheken. Spark Core führt und verwaltet unsere Arbeit, indem es dem Endbenutzer eine nahtlose Erfahrung bietet. Ein Benutzer muss einen Auftrag an Spark Core senden, und Spark Core übernimmt die weitere Verarbeitung, Ausführung und Antwort an den Benutzer. Wir haben Spark Core API in verschiedenen Skriptsprachen wie Scala, Python, Java und R.

- In Apache Spark kann der Benutzer Apache Storm verwenden, um unstrukturierte Daten in das gewünschte Format zu transformieren. Sie müssen einen Cluster-Manager und ein Speichersystem Ihrer Wahl anschließen.

- Sie können Apache YARN oder Mesos als Cluster-Manager für Apache Spark auswählen.

- Sie können zwischen Hadoop Distributed File System (HDFS), Google Cloud Storage, Amazon S3 und Microsoft Azure für den Ressourcenmanager für Apache Spark wählen.

- Apache Spark ist eine Datenverarbeitungs-Engine für Batch- und Streaming-Modi mit SQL-Abfragen, Grafikverarbeitung und maschinellem Lernen.

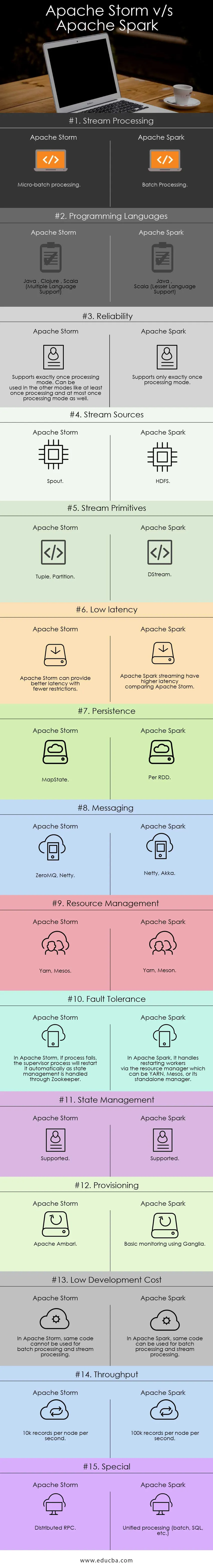

Direkter Vergleich zwischen Apache Storm und Apache Spark (Infografik):

Hauptunterschiede zwischen Apache Storm und Apache Spark:

Nachfolgend sind die Punktelisten aufgeführt, die die wichtigsten Unterschiede zwischen Apache Storm und Apache Spark beschreiben:

- Apache Storm führt aufgabenparallele Berechnungen durch, während Apache Spark datenparallele Berechnungen durchführt.

- Wenn der Worker-Knoten in Apache Storm ausfällt, weist Nimbus die Worker-Aufgabe dem anderen Knoten zu, und alle an den ausgefallenen Knoten gesendeten Tupel werden nach Ablauf des Zeitlimits automatisch wiedergegeben Übrig gebliebene Kopien von Eingabedaten und Daten können verloren gehen, wenn Daten nicht repliziert werden.

- Die Liefergarantie für Apache Strom hängt von einer sicheren Datenquelle ab, während die in Apache Spark HDFS gesicherte Datenquelle sicher ist.

- Apache Storm ist eine Stream-Processing-Engine zur Verarbeitung von Echtzeit-Streaming-Daten, während Apache Spark eine Universal-Computing-Engine ist.

Eigenschaften von Apache Storm:

- Fehlertoleranz - Wenn Worker-Threads ausfallen oder ein Knoten ausfällt, werden die Worker automatisch neu gestartet

- Skalierbarkeit - Durch die hohe Skalierbarkeit kann Storm die Leistung auch bei zunehmender Last aufrechterhalten, indem Ressourcen linear hinzugefügt werden, wobei Durchsatzraten von sogar einer Million 100-Byte-Nachrichten pro Sekunde und Knoten erreicht werden können

- Latenz - Storm führt die Datenaktualisierung und die End-to-End-Zustellungsantwort in Sekunden oder Minuten durch. Dies hängt vom Problem ab. Die Latenz ist sehr gering.

- Einfache Bereitstellung und Bedienung des Systems.

- In Hadoop integriert, um höhere Durchsätze zu erzielen

- Einfach zu implementieren und kann in jede Programmiersprache integriert werden

- Apache Storm ist Open Source, robust und benutzerfreundlich. Es kann sowohl in kleinen als auch in großen Unternehmen eingesetzt werden

- Ermöglicht unglaublich schnelle Stream-Verarbeitung in Echtzeit, da es eine enorme Verarbeitungsleistung für die Daten hat.

- Apache Storm verfügt über operative Intelligenz.

- Apache Storm bietet eine garantierte Datenverarbeitung, selbst wenn einer der verbundenen Knoten im Cluster ausfällt oder Nachrichten verloren gehen

Funktionen von Apache Spark:

- Geschwindigkeit: Mit Apache Spark können Sie eine Anwendung im Hadoop-Cluster ausführen, die bis zu 100-mal schneller im Arbeitsspeicher und 10-mal schneller auf der Festplatte ausgeführt wird.

- Echtzeitverarbeitung: Apache Spark kann Echtzeit-Streaming-Daten verarbeiten.

- Benutzerfreundlichkeit : Apache Spark unterstützt mehrere Sprachen wie Java, Scala, Python und R

- Faule Bewertung: In Apache Spark sind Transformationen von Natur aus faul. Das Ergebnis wird nach der Bildung einer neuen RDD aus der vorhandenen RDD angezeigt.

- Integration mit Hadoop: Apache Spark kann unabhängig und auch auf Hadoop YARN Cluster Manager ausgeführt werden und somit vorhandene Hadoop-Daten lesen.

- Fehlertoleranz: Apache Spark bietet Fehlertoleranz mithilfe des RDD-Konzepts. Spark-RDDs sind so konzipiert, dass sie den Ausfall eines beliebigen Arbeitsknotens im Cluster behandeln.

Apache Storm vs Apache Spark Vergleichstabelle

Ich diskutiere Hauptartefakte und unterscheide zwischen Apache Storm und Apache Spark.

| Apache Storm | Apache Spark | |

| Stream-Verarbeitung | Micro-Batch-Verarbeitung | Stapelverarbeitung |

| Programmiersprachen | Java, Clojure, Scala (Unterstützung mehrerer Sprachen) | Java, Scala (Unterstützung für weniger Sprachen) |

| Verlässlichkeit | Unterstützt genau einmal den Verarbeitungsmodus. Kann in den anderen Modi verwendet werden, z. B. mindestens einmal und höchstens einmal | Unterstützt nur genau einmal den Bearbeitungsmodus |

| Stream-Quellen | Tülle | HDFS |

| Stream-Primitive | Tupel, Partition | DStream |

| Geringe Wartezeit | Apache Storm bietet eine bessere Latenz mit weniger Einschränkungen | Apache Spark Streaming hat eine höhere Latenz im Vergleich zu Apache Storm |

| Beharrlichkeit | MapState | Per RDD |

| Messaging | ZeroMQ, Netty | Netty, Akka |

| Resourcenmanagement | Garn, Mesos | Garn, Meson |

| Fehlertoleranz | Wenn der Prozess in Apache Storm fehlschlägt, wird er vom Supervisor-Prozess automatisch neu gestartet, da die Statusverwaltung über Zookeeper erfolgt | In Apache Spark wird der Neustart von Workern über den Ressourcenmanager ausgeführt, der YARN, Mesos oder sein eigenständiger Manager sein kann |

| State Management | Unterstützt | Unterstützt |

| Bereitstellung | Apache Ambari | Grundlegende Überwachung mit Ganglia |

| Niedrige Entwicklungskosten | In Apache Storm kann nicht derselbe Code für die Stapelverarbeitung und die Stream-Verarbeitung verwendet werden | In Apache Spark kann derselbe Code für die Stapelverarbeitung und die Stream-Verarbeitung verwendet werden |

| Durchsatz | 10k Datensätze pro Knoten pro Sekunde | 100.000 Datensätze pro Knoten pro Sekunde |

| Besondere | Distributed RPC | Einheitliche Verarbeitung (Batch, SQL usw.) |

Fazit - Apache Storm vs Apache Spark:

Apache Storm und Apache Spark sind großartige Lösungen, die das Problem der Streaming-Aufnahme und -Transformation lösen. Apache Storm und Apache Spark können beide Teil des Hadoop-Clusters zur Datenverarbeitung sein. Apache Storm ist eine Lösung für die Stream-Verarbeitung in Echtzeit. Aufgrund der begrenzten Ressourcen ist es für Entwickler jedoch sehr komplex, Anwendungen zu entwickeln.

Apache Storm kann hauptsächlich für die Stream-Verarbeitung verwendet werden. Die Industrie braucht jedoch eine allgemeine Lösung, die alle Arten von Problemen lösen kann. Zum Beispiel Stapelverarbeitung, Stream-Verarbeitung, interaktive Verarbeitung sowie iterative Verarbeitung. Apache Spark rückt ins Rampenlicht und ist eine universelle Rechenmaschine. Aus diesem Grund vergleicht die Nachfrage von Apache Spark eher andere Tools von IT-Experten. Apache Spark kann mit verschiedenen Arten von Problemen umgehen. Abgesehen davon ist Apache Spark für Entwickler viel zu einfach und lässt sich sehr gut in Hadoop integrieren. Apache Spark bietet Ihnen die Flexibilität, in verschiedenen Sprachen und Umgebungen zu arbeiten.

Empfohlener Artikel

Dies war eine Anleitung zu Apache Storm und Apache Spark, deren Bedeutung, Kopf-an-Kopf-Vergleich, Hauptunterschiede, Vergleichstabelle und Schlussfolgerung. Sie können sich auch die folgenden Artikel ansehen, um mehr zu erfahren -

- Iaas vs Azure Pass - Unterschiede, die Sie kennen müssen

- Apache Hadoop gegen Apache Spark | Top 10 Vergleiche, die Sie kennen müssen!

- 7 Erstaunliche Anleitung zu Apache Spark (Anleitung)

- Die besten 15 Dinge, die Sie über MapReduce vs Spark wissen müssen

- Hadoop vs Apache Spark - Interessante Dinge, die Sie wissen müssen