Unterschied zwischen Apache Spark und Apache Flink

Apache Spark ist ein Open-Source-Cluster-Computing-Framework, das von Apache Software entwickelt wurde. Apache Spark ist sehr schnell und kann für die Verarbeitung großer Datenmengen verwendet werden. Es ist eine Alternative für vorhandene umfangreiche Datenverarbeitungswerkzeuge im Bereich der Big Data-Technologien. Apache Flink ist ein Open-Source-Framework für die Stream-Verarbeitung von Datenstreaming-Anwendungen für hohe Verfügbarkeit, hohe Leistung, Stabilität und Genauigkeit in verteilten Anwendungen. Apache Flink bietet eine niedrige Latenz und einen hohen Durchsatz in der Streaming-Engine mit Fehlertoleranz im Falle eines Ausfalls der Data-Engine oder des Computers.

Lassen Sie uns viel mehr über Apache Spark und Apache Flink im Detail lernen:

- Spark ist ein von der Apache Software Foundation entwickeltes Open-Source-Cluster-Computing-Framework, das ursprünglich von der University of California Berkeley entwickelt wurde und später an die Apache Foundation gespendet wurde, um es zu Open Source zu machen.

- Apache Flink ist ein Open-Source-Software-Framework, das von Apache Software Foundation entwickelt wurde. Die Kernkomponente von Flink ist eine verteilte Streaming- und Datenverarbeitungs-Engine, die in Java und Scala geschrieben wurde.

- Apache Spark ist sehr schnell und kann für die groß angelegte Datenverarbeitung verwendet werden, die sich heutzutage hervorragend entwickelt. Es hat sich zu einer Alternative für viele vorhandene Tools für die Datenverarbeitung in großem Maßstab im Bereich der Big-Data-Technologien entwickelt.

- Mit Apache Spark können Programme 100-mal schneller ausgeführt werden als mit Map Reduce-Jobs in der Hadoop-Umgebung. Spark kann auch in einer Hadoop- oder Amazon AWS-Cloud ausgeführt werden, indem eine Amazon EC2-Instanz (Elastic Cloud Compute) oder ein eigenständiger Cluster-Modus erstellt wird. Außerdem kann auf verschiedene Datenbanken wie Cassandra, Amazon Dynamo DB usw. zugegriffen werden.

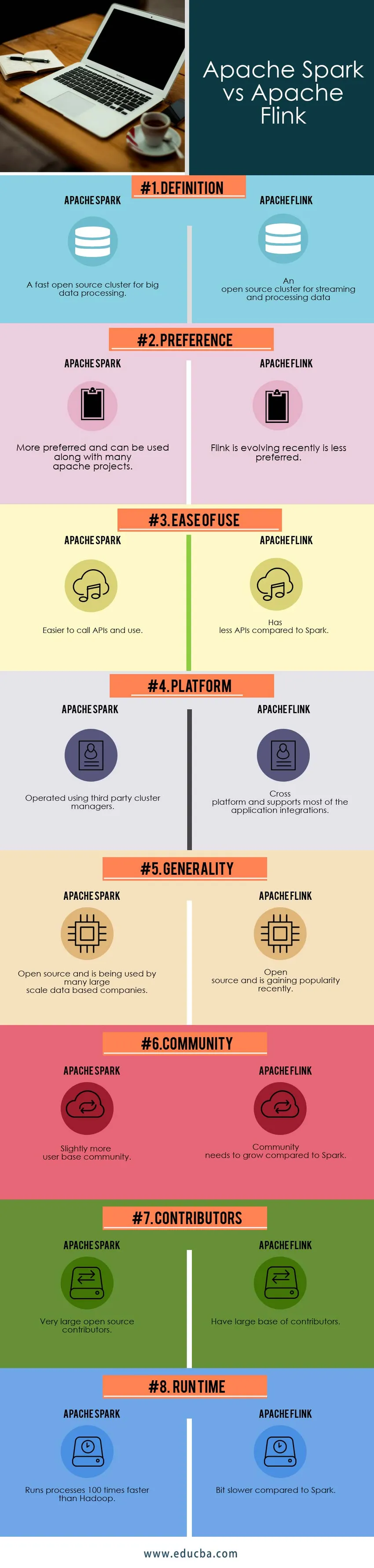

Head to Head Vergleich zwischen Apache Flink und Apache Spark (Infografik)

Unten ist der Top 8 Vergleich zwischen Apache Spark und Apache Flink

Hauptunterschiede zwischen Apache Spark und Apache Flink

- Spark ist eine Reihe von APIs (Application Programming Interfaces) aus allen bestehenden Hadoop-Projekten, die mehr als 30 umfassen. Apache Flink war zuvor ein Forschungsprojekt mit dem Namen Stratosphere, bevor seine Entwickler den Namen in Flink änderten.

- Spark bietet High-Level-APIs in verschiedenen Programmiersprachen wie Java, Python, Scala und R. 2014 wurde Apache Flink von der Apache Projects Group als Apache Incubator Project anerkannt.

- Spark verfügt über Kernfunktionen wie Spark Core, Spark SQL, MLib (Maschinenbibliothek), GraphX (für die Grafikverarbeitung) und Spark Streaming und Flink werden zum Ausführen von zyklischen und iterativen Prozessen durch Iterieren von Sammlungen verwendet.

- Sowohl Apache Spark als auch Apache Flink sind Allzweck-Streaming- oder Datenverarbeitungsplattformen in der Big-Data-Umgebung. Der Spark-Cluster-Modus kann zum Streamen und Verarbeiten der Daten in verschiedenen Clustern für umfangreiche Daten verwendet werden, um eine schnelle und parallele Verarbeitung zu ermöglichen.

- Im Spark-Cluster-Modus werden Anwendungen als einzelne Prozesse im Cluster ausgeführt. Flink ist ein leistungsstarkes Tool für Stapelverarbeitungsjobs und Job Scheduling-Prozesse.

- Die Komponenten des Spark-Clusters sind Driver Manager, Driver Program und Worker Nodes. Flink verfügt über eine weitere Funktion mit gutem Kompatibilitätsmodus, mit der verschiedene Apache-Projekte wie Apache Storm und Map Reduce-Jobs in der Ausführungsengine unterstützt werden, um die Datenstreaming-Leistung zu verbessern.

- Spark bietet verschiedene Arten von Cluster-Managern an, z. B. HADOOP Yarn-Cluster-Manager, Standalone-Modus (oben bereits erläutert), Apache Mesos (allgemeiner Cluster-Manager) und Kubernetes (experimentelles Open Source-System für die Automatisierungsbereitstellung). Flink hat nur eine Datenverarbeitungs-Engine im Vergleich zu Spark, die verschiedene Kernkomponenten hat.

- Spark-Cluster-Komponentenfunktionen enthalten Aufgaben, Cache und Ausführende innerhalb eines Arbeitsknotens, wobei ein Cluster-Manager mehrere Arbeitsknoten haben kann. Die Flink-Architektur funktioniert so, dass die Streams nicht jedes Mal geöffnet und geschlossen werden müssen.

- Spark und Flink verfügen über eine In-Memory-Verwaltung. Spark stürzt den Knoten ab, wenn der Speicher voll ist, aber Fehlertoleranz besteht. Flink verfolgt einen anderen Ansatz zur Speicherverwaltung. Flink schreibt auf die Festplatte, wenn der Arbeitsspeicher voll ist.

- Sowohl der Apache Spark als auch der Apache Flink arbeiten mit dem von LinkedIn entwickelten Apache Kafka-Projekt zusammen, bei dem es sich auch um eine starke Daten-Streaming-Anwendung mit hoher Fehlertoleranz handelt.

- Spark kann Speicher in verschiedenen Anwendungen gemeinsam nutzen, während Flink über eine explizite Speicherverwaltung verfügt, die das Auftreten gelegentlicher Spitzen in Apache Spark verhindert.

- Spark hat mehr Konfigurationseigenschaften, während Flink weniger Konfigurationseigenschaften hat.

- Flink kann die Stapelverarbeitungstechniken approximieren, und Spark verfügt über eine einheitliche Engine, die unabhängig von Hadoop ausgeführt werden kann, indem eine Verbindung zu vielen anderen Cluster-Managern und Speicherplattformen oder Servern hergestellt wird.

- Die Netzwerkauslastung von Apache Spark ist zu Beginn des Jobs geringer, wenn dieser ausgelöst wird, was zu Verzögerungen bei der Ausführung eines Jobs führt. Apache Flink nutzt das Netzwerk von Anfang an, was darauf hinweist, dass Flink seine Ressource effektiv nutzt.

- Die geringere Ressourcennutzung in Apache Spark führt zu einer geringeren Produktivität, während die Ressourcennutzung in Apache Flunk zu einer höheren Produktivität und besseren Ergebnissen führt.

Apache Spark vs Apache Flink Vergleichstabelle

| BASIS FÜR

VERGLEICH | Apache Spark | Apache Flink |

| Definition | Ein schneller Open-Source-Cluster für die Verarbeitung großer Datenmengen | Ein Open Source-Cluster zum Streamen und Verarbeiten von Daten |

| Präferenz | Bevorzugter und kann zusammen mit vielen Apache-Projekten verwendet werden | Flink, das sich in letzter Zeit weiterentwickelt, ist weniger bevorzugt |

| Benutzerfreundlichkeit | Einfacher APIs aufzurufen und zu verwenden | Verfügt über weniger APIs im Vergleich zu Spark |

| Plattform | Betrieb mit Cluster-Managern von Drittanbietern | Plattformübergreifend und unterstützt die meisten Anwendungsintegrationen |

| Allgemeinheit | Open Source und wird von vielen großen datenbasierten Unternehmen verwendet | Open Source und gewinnt in letzter Zeit an Popularität |

| Gemeinschaft | Etwas mehr Benutzergemeinschaft | Die Community muss im Vergleich zu Spark wachsen |

| Mitwirkende | Sehr große Open Source-Autoren | Haben Sie eine große Anzahl von Mitwirkenden |

| Laufzeit | Führt Prozesse 100-mal schneller als Hadoop aus | Etwas langsamer als Spark |

Fazit - Apache Spark vs Apache Flink

Apache Spark und Apache Flink sind Allzweckanwendungen zur Datenstromverarbeitung, bei denen die von ihnen bereitgestellten APIs und die Architektur und die Kernkomponenten unterschiedlich sind. Spark verfügt über mehrere Kernkomponenten, um unterschiedliche Anwendungsanforderungen zu erfüllen, während Flink nur über Datenstreaming und Verarbeitungskapazität verfügt.

Abhängig von den Geschäftsanforderungen kann das Software-Framework ausgewählt werden. Spark existiert seit einigen Jahren, während sich Flink heutzutage in der Branche allmählich weiterentwickelt, und es besteht die Möglichkeit, dass Apache Flink Apache Spark überholt.

Zur Integration in mehrere Frameworks wird Spark gegenüber Flink bevorzugt, um mehrere Anwendungen in einer verteilten Umgebung zu unterstützen.

Empfohlener Artikel

Dies war eine Anleitung zu Apache Spark und Apache Flink, deren Bedeutung, Kopf-an-Kopf-Vergleich, Hauptunterschiede, Vergleichstabelle und Schlussfolgerung. Sie können sich auch die folgenden Artikel ansehen, um mehr zu erfahren -

- Apache Hadoop gegen Apache Spark | Top 10 Vergleiche, die Sie kennen müssen!

- Die besten Dinge, die man über Apache Spark lernen kann (Anleitung)

- Apache Storm vs Apache Spark - Lerne 15 nützliche Unterschiede

- Die besten 15 Dinge, die Sie über MapReduce vs Spark wissen müssen