Einführung in Decision Tree im maschinellen Lernen

Der Entscheidungsbaum im maschinellen Lernen hat in der modernen Welt ein weites Feld. Es gibt viele Algorithmen in ML, die in unserem täglichen Leben verwendet werden. Einer der wichtigsten Algorithmen ist der Entscheidungsbaum, der zur Klassifizierung und auch zur Lösung von Regressionsproblemen verwendet wird. Da es sich um ein Vorhersagemodell handelt, erfolgt die Entscheidungsbaumanalyse über einen algorithmischen Ansatz, bei dem ein Datensatz gemäß den Bedingungen in Teilmengen aufgeteilt wird. Der Name selbst besagt, dass es sich um ein baumartiges Modell in Form von if-then-else-Anweisungen handelt. Je tiefer der Baum und je mehr die Knoten sind, desto besser ist das Modell.

Arten des Entscheidungsbaums beim maschinellen Lernen

Entscheidungsbaum ist ein baumartiges Diagramm, bei dem die Sortierung vom Stammknoten zum Blattknoten beginnt, bis das Ziel erreicht ist. Es ist das beliebteste Verfahren zur Entscheidung und Klassifizierung basierend auf überwachten Algorithmen. Es wird durch rekursive Partitionierung erstellt, wobei jeder Knoten als Testfall für einige Attribute fungiert und jede Kante, die vom Knoten stammt, eine mögliche Antwort im Testfall ist. Sowohl der Wurzel- als auch der Blattknoten sind zwei Entitäten des Algorithmus.

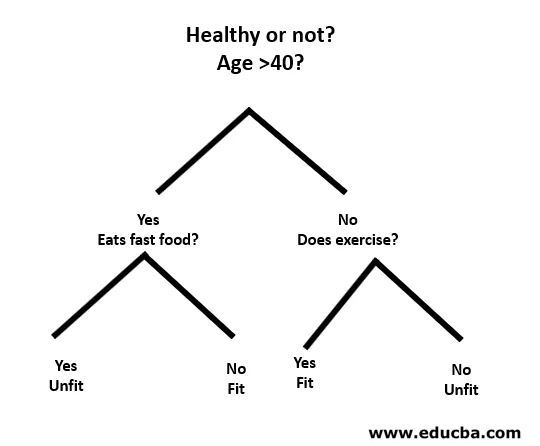

Lassen Sie uns anhand eines kleinen Beispiels Folgendes verstehen:

Hier ist der Wurzelknoten, ob Sie weniger als 40 Jahre alt sind oder nicht. Wenn ja, dann isst du Fast Food? Wenn ja, dann sind Sie nicht fit oder Sie sind fit. Und wenn Sie über 40 Jahre alt sind, trainieren Sie dann? Wenn ja, dann sind Sie fit oder Sie sind untauglich. Dies war im Grunde eine binäre Klassifikation.

Es gibt zwei Arten von Entscheidungsbäumen:

- Klassifikationsbäume: Das obige Beispiel ist ein kategorienbasierter Klassifikationsbaum.

- Regressionsbäume : Bei dieser Art von Algorithmus ist die Entscheidung oder das Ergebnis kontinuierlich. Es hat einen einzelnen numerischen Ausgang mit mehr Eingängen oder Prädiktoren.

In der Entscheidungsstruktur besteht die typische Herausforderung darin, das Attribut an jedem Knoten zu identifizieren. Der Prozess wird als Attributauswahl bezeichnet und hat einige zu verwendende Maßnahmen, um das Attribut zu identifizieren.

ein. Informationsgewinn (IG)

Informationsgewinn misst, wie viele Informationen ein einzelnes Feature über die Klasse liefert. Es fungiert als Hauptschlüssel für die Erstellung eines Entscheidungsbaums. Ein Attribut mit dem höchsten Informationsgewinn wird zuerst geteilt. Decision Tree maximiert also immer den Informationsgewinn. Wenn wir die Instanzen mithilfe eines Knotens in kleinere Teilmengen unterteilen, ändert sich die Entropie.

Entropie: Dies ist das Maß für die Unsicherheit oder Verunreinigung einer Zufallsvariablen. Die Entropie bestimmt, wie ein Entscheidungsbaum die Daten in Teilmengen aufteilt.

Die Gleichung für Informationsgewinn und Entropie lautet wie folgt:

Informationsgewinn = Entropie (Eltern) - (gewichteter Durchschnitt * Entropie (Kinder))

Entropie: ∑p (X) log p (X)

P (X) ist hier der Bruchteil von Beispielen in einer gegebenen Klasse.

b. Gini Index

Der Gini-Index ist eine Metrik, die entscheidet, wie oft ein zufällig ausgewähltes Element falsch identifiziert wird. Es wird eindeutig angegeben, dass ein Attribut mit einem niedrigen Gini-Index an erster Stelle steht.

Gini-Index: 1 - ∑ p (X) 2

Split-Erstellung

- Um einen Split zu erstellen, müssen wir zuerst den Gini-Score berechnen.

- Die Daten werden unter Verwendung einer Liste von Zeilen aufgeteilt, die einen Index eines Attributs und einen aufgeteilten Wert dieses Attributs aufweisen. Nachdem der rechte und der linke Datensatz gefunden wurden, können wir den Teilungswert durch die Gini-Punktzahl aus dem ersten Teil erhalten. Jetzt ist der Split-Wert der Entscheider, in dem sich das Attribut befindet.

- Im nächsten Teil werden alle Teilungen ausgewertet. Der bestmögliche Wert wird berechnet, indem die Kosten der Aufteilung bewertet werden. Die beste Aufteilung wird als Knoten des Entscheidungsbaums verwendet.

Einen Baum bauen - Entscheidungsbaum beim maschinellen Lernen

Es gibt zwei Schritte zum Erstellen eines Entscheidungsbaums.

1. Terminalknotenerstellung

Beim Erstellen des Endknotens ist es am wichtigsten, zu beachten, ob wir aufhören müssen, Bäume zu züchten, oder weiter vorgehen müssen. Hierzu können folgende Möglichkeiten genutzt werden:

- Maximale Baumtiefe: Wenn der Baum die maximale Anzahl von Knoten erreicht, wird die Ausführung dort gestoppt.

- Minimale Knotendatensätze: Dies kann als Minimum an Mustern definiert werden, die ein Knoten benötigt. Dann können wir aufhören, Endknoten hinzuzufügen, sobald wir diese minimalen Knotendatensätze erhalten.

2. Rekursives Teilen

Sobald der Knoten erstellt ist, können wir rekursiv einen untergeordneten Knoten erstellen, indem wir den Datensatz aufteilen und dieselbe Funktion mehrmals aufrufen.

Prognose

Nachdem ein Baum erstellt wurde, erfolgt die Vorhersage mithilfe einer rekursiven Funktion. Der gleiche Vorhersageprozess wird erneut mit linken oder rechten untergeordneten Knoten und so weiter verfolgt.

Vor- und Nachteile des Entscheidungsbaums

Nachfolgend sind einige Vor- und Nachteile aufgeführt:

Vorteile

Der Entscheidungsbaum bietet einige Vorteile beim maschinellen Lernen:

- Umfassend: Es berücksichtigt jedes mögliche Ergebnis einer Entscheidung und führt jeden Knoten entsprechend zum Abschluss.

- Spezifisch: Entscheidungsbäume weisen jedem Problem, jeder Entscheidung und jedem Ergebnis einen bestimmten Wert zu. Es reduziert Unsicherheit und Mehrdeutigkeit und erhöht auch die Klarheit.

- Einfachheit: Decision Tree ist einer der einfacheren und zuverlässigsten Algorithmen, da es keine komplexen Formeln oder Datenstrukturen enthält. Für die Berechnung werden nur einfache Statistiken und Berechnungen benötigt.

- Vielseitig: Entscheidungsbäume können manuell mithilfe von Mathematik erstellt und auch mit anderen Computerprogrammen verwendet werden.

Nachteile

Der Entscheidungsbaum hat einige Nachteile beim maschinellen Lernen:

- Entscheidungsbäume sind für Schätzungen und finanzielle Aufgaben weniger geeignet, wenn wir einen angemessenen Wert benötigen.

- Es ist ein fehleranfälliger Klassifizierungsalgorithmus im Vergleich zu anderen Berechnungsalgorithmen.

- Es ist rechenintensiv. An jedem Knoten muss der Kandidatensplit sortiert werden, bevor der beste ermittelt werden kann. Es gibt andere Alternativen, denen viele Unternehmen bei Finanzaufgaben folgen, da Decision Tree für die Bewertung zu teuer ist.

- Während der Arbeit mit kontinuierlichen Variablen ist Decision Tree nicht die beste Lösung, da beim Kategorisieren von Variablen Informationen verloren gehen.

- Es ist manchmal instabil, da kleine Abweichungen im Datensatz zur Bildung eines neuen Baums führen können.

Fazit - Entscheidungsbaum im maschinellen Lernen

Als einer der wichtigsten und überwachten Algorithmen spielt Decision Tree eine wichtige Rolle bei der Analyse von Entscheidungen im wirklichen Leben. Als Vorhersagemodell wird es in vielen Bereichen für seinen Split-Ansatz verwendet, mit dessen Hilfe Lösungen basierend auf verschiedenen Bedingungen entweder nach Klassifizierungs- oder Regressionsmethode identifiziert werden können.

Empfohlene Artikel

Dies ist eine Anleitung zum Entscheidungsbaum im maschinellen Lernen. Hier besprechen wir die Einführung, Typen von Entscheidungsbäumen im maschinellen Lernen, Split-Erstellung und Erstellen eines Baums. Sie können auch unsere anderen Artikelvorschläge durchgehen, um mehr zu erfahren.

- Python-Datentypen

- Tableau-Datensätze

- Cassandra Datenmodellierung

- Entscheidungstabellentest

- Top 8 Phasen des Lebenszyklus des maschinellen Lernens