Unterschied zwischen Hadoop und SQL

Die enormen Datenmengen, die jede Sekunde über soziale Medien wie Facebook, Twitter und Instagram generiert werden, haben den Weg für die Entwicklung des Hadoop / Big Data-Ökosystems geebnet. Der Begriff „3V“, der sich auf Lautstärke, Velocity und Veracity bezieht, definiert die Bedeutung von Hadoop für die Verarbeitung der Streaming-Daten. Heutzutage werden Daten aus mehreren Quellen generiert, die für verschiedene Zwecke wie Berichterstellung, Datenanalyse und Forschung sowie für die zentrale Speicherung von Daten integriert werden müssen. Dabei treten bei herkömmlichen Ansätzen zahlreiche Probleme auf, z. B. Speicherplatz, Zugriff, Integrität, Struktur und Bandbreite. Um all diese Probleme zu lösen, stellt Hadoop ein Framework zur Verfügung, mit dem Sie Daten mit großer Größe verarbeiten, einfachen Zugriff und hohe Verfügbarkeit bereitstellen und Daten dynamisch laden können. Es verfügt über ein verteiltes Dateisystem-Framework (Distributed File System Framework, HDFS) für die Speicherung von Daten und einen integrierten Abfrageprozessor namens "Map Reduce" für die Analyse und Verarbeitung von in HDFS gespeicherten Daten.

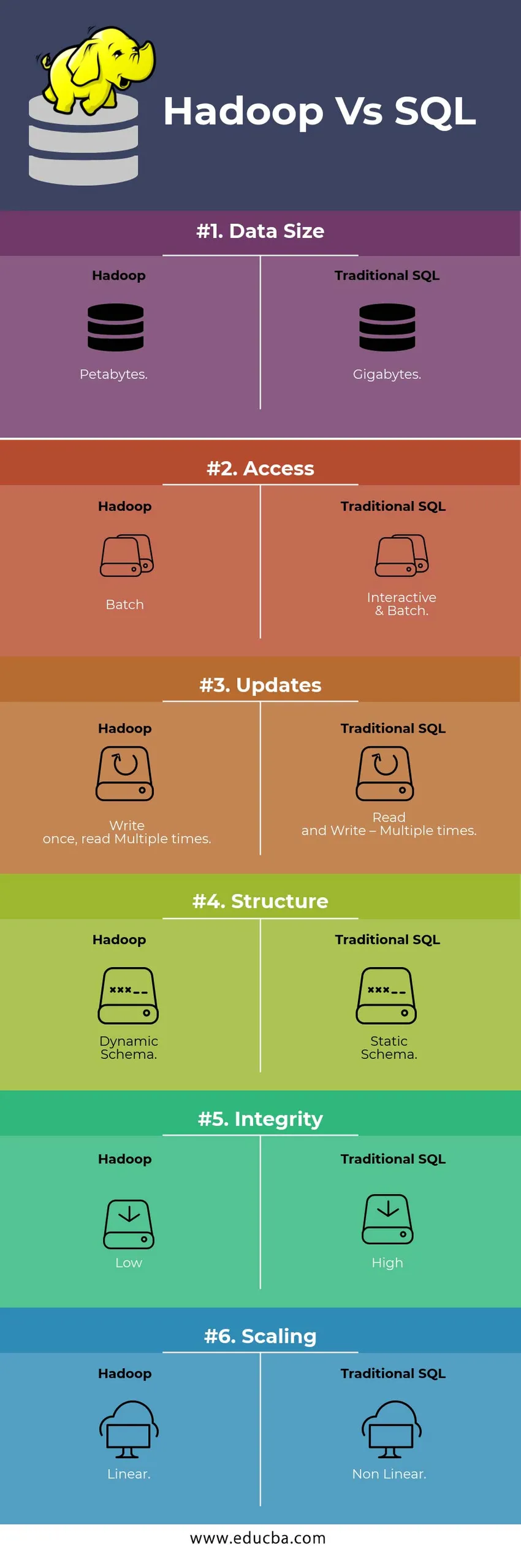

HEAD-TO-HEAD-Vergleich zwischen Hadoop und SQL

Unten ist der Top 6 Unterschied zwischen Hadoop Vs SQL

Hauptunterschiede zwischen Hadoop und SQL

Im Folgenden ist der Unterschied zwischen Hadoop und SQL wie folgt

- Schema bei WRITE Vs READ

Im Allgemeinen folgt eine herkömmliche Datenbank beim Laden / Migrieren von Daten von einer Datenbank zu einer anderen dem Schema-on-Write-Ansatz. Dadurch wird der Datenladeprozess angeregt / abgebrochen, und Datensätze werden aufgrund der unterschiedlichen Struktur der Quell- und Zieltabelle abgelehnt. Im Hadoop-System hingegen werden alle Daten in HDFS gespeichert und die Daten werden zentralisiert.

Das Hadoop-Framework wird hauptsächlich für den Datenanalyseprozess verwendet. Somit werden alle drei Datenkategorien unterstützt, dh strukturierte, halbstrukturierte und unstrukturierte Daten, und es wird ein Schema-on-Reading-Ansatz ermöglicht.

- Strukturierte Daten haben ein bestimmtes Format. Beispiel: XML-Datei.

- Semi Structures-Daten sind lockerer. Es könnte / kein Schema haben. g .: Tabellenkalkulation

- Unstrukturierte Daten haben keine bestimmte Struktur oder ein Schema. ZB: Nur Text oder Bild.

Hadoop arbeitet effizient mit unstrukturierten Daten, da es die Daten während der Verarbeitungszeit interpretieren kann.

| Ansatz | Vorteil | Dis Vorteil |

| Schema beim Schreiben | · Vordefinierte Strukturen

· Schnelleres Lesen. ZB: Traditionelles RDBMS. | Langsames Laden der Daten

Hohe Latenz |

| Schema beim Lesen | · Dynamische Struktur

· Schnelles Schreiben und Lesen. ZB: Hadoop | Schnelles Laden der Daten

Geringe Wartezeit |

Tabelle : Schema bei WRITE VS Schema bei READ.

- Skalierbarkeit & Kosten

Hadoop Framework ist für die Verarbeitung großer Datenmengen ausgelegt. Immer wenn die Datenmenge zunimmt, können dem Cluster sehr einfach eine Reihe zusätzlicher Ressourcen wie Datenknoten hinzugefügt werden, als dies bei der herkömmlichen statischen Speicherzuweisung der Fall ist. Zeit und Budget sind für die Implementierung relativ gering, und Hadoop stellt Datenlokalität bereit, in der die Daten auf dem Knoten verfügbar gemacht werden, auf dem der Auftrag ausgeführt wurde.

- FEHLERTOLERANZ

Wenn im herkömmlichen RDBMS Daten aufgrund einer Beschädigung oder eines Netzwerkproblems verloren gehen, sind mehr Zeit, Kosten und Ressourcen erforderlich, um die verlorenen Daten zurückzugewinnen. Hadoop verfügt jedoch über einen Mechanismus, bei dem die Daten mindestens drei Replikationsfaktoren für die in HDFS gespeicherten Daten aufweisen. Wenn einer der Datenknoten, der Daten enthält, ausfällt, können Daten einfach von anderen Datenknoten mit hoher Datenverfügbarkeit abgerufen werden. Somit stehen die Daten dem Benutzer unabhängig von einem Fehler jederzeit zur Verfügung.

- FUNKTIONALE PROGRAMMIERUNG

Hadoop unterstützt das Schreiben von funktionaler Programmierung in Sprachen wie Java, Scala und Python. Für jede Anwendung, die zusätzliche Funktionen benötigt, kann UDF - User Defined Functions im HDFS registriert werden. In RDBMS gibt es keine Möglichkeit, UDF zu schreiben, und dies erhöht die Komplexität beim Schreiben von SQL. Darüber hinaus können alle Ökosysteme von Hadoop wie Hive, Pig, Sqoop und HBase auf die in HDFS gespeicherten Daten zugreifen. Wenn also die UDF geschrieben ist, kann sie von jeder der oben genannten Anwendungen verwendet werden. Es erhöht die Leistung und die Unterstützbarkeit des Systems.

- OPTIMIERUNG

Hadoop speichert Daten in HDFS und Process through Map Reduce mit umfangreichen Optimierungstechniken. Die gängigsten Techniken für den Umgang mit Daten sind das Partitionieren und Auslagern der gespeicherten Daten. Partitionierung ist ein Ansatz zum Speichern der Daten in HDFS, indem die Daten auf der Grundlage der für die Partitionierung angegebenen Spalte aufgeteilt werden. Wenn die Daten in HDFS eingefügt oder geladen werden, wird die Partitionsspalte identifiziert und die Daten in das betreffende Partitionsverzeichnis verschoben. Die Abfrage ruft also die Ergebnismenge ab, indem sie die Daten direkt aus dem partitionierten Verzeichnis abruft. Dies reduziert den gesamten Tabellenscan, verbessert die Reaktionszeit und vermeidet Latenzen.

Ein anderer Ansatz nennt sich Bucketing der Daten. Auf diese Weise kann der Analyst die Daten problemlos auf die Datenknoten verteilen. Auf allen Knoten wird die gleiche Anzahl von Daten verteilt. Die Bucketing-Spalte wird so ausgewählt, dass sie die geringste Anzahl von Kardinalitäten aufweist.

Diese Ansätze sind in der herkömmlichen SQL-Methode nicht verfügbar.

- DATENTYP

In einem herkömmlichen Ansatz sind die unterstützten Datentypen sehr begrenzt. Es werden nur strukturierte Daten unterstützt. Das Bereinigen und Formatieren des Datenschemas selbst nimmt daher mehr Zeit in Anspruch. Hadoop unterstützt jedoch komplexe Datentypen wie Array, Struct und Map. Dies fördert die Verwendung der verschiedenen Arten eines Datasets, die zum Laden von Daten verwendet werden sollen. Zum Beispiel: Die XML-Daten können geladen werden, indem die Daten mit XML-Elementen definiert werden, die einen komplexen Datentyp enthalten.

- DATENKOMPRESSION

Für das traditionelle Datenbanksystem stehen nur sehr wenige eingebaute Komprimierungstechniken zur Verfügung. Für das Hadoop-Framework gibt es jedoch viele Komprimierungstechniken wie gzib, bzip2, LZO und snappy. Der Standardkomprimierungsmodus ist LZ4. Sogar die Tabellen können mit den Komprimierungstechniken Parkett, ORC komprimiert werden. Komprimierungstechniken sorgen dafür, dass die Tabellen weniger Speicherplatz belegen, und erhöhen den Durchsatz und beschleunigen die Ausführung von Abfragen.

Hadoop Vs SQL-Vergleichstabelle

| Eigenschaften | Traditionelles SQL | Hadoop |

| Datengröße | Gigabyte | Petabyte |

| Zugriff | Interaktiv & Batch | Stapel |

| Aktualisierung | Lesen und Schreiben - Mehrmals | Einmal schreiben, mehrmals lesen |

| Struktur | Statisches Schema | Dynamisches Schema |

| Integrität | Hoch | Niedrig |

| Skalierung | Nicht linear | Linear |

Tabelle : Vergleich zwischen traditionellem Hadoop und SQL Framework.

Fazit - Hadoop Vs SQL

Insgesamt ist Hadoop dem traditionellen SQL in Bezug auf Kosten, Zeit, Leistung, Zuverlässigkeit, Unterstützbarkeit und Verfügbarkeit von Daten für die sehr große Benutzergruppe einen Schritt voraus. Um die enorme Menge an Daten, die jeden Tag generiert werden, effizient zu verarbeiten, hilft Hadoop Framework bei der zeitnahen Erfassung, Speicherung, Verarbeitung, Filterung und endgültigen Speicherung an einem zentralen Ort.

Empfohlener Artikel

- Hadoop vs Hive - Finde die besten Unterschiede heraus

- Erfahren Sie die 10 nützlichen Unterschiede zwischen Hadoop und Redshift

- HADOOP vs RDBMS | Kennen Sie die 12 nützlichen Unterschiede

- Apache Hadoop gegen Apache Spark | Top 10 Vergleiche, die Sie kennen müssen!

- Hadoop vs Spark: Funktionen