Einführung in Hadoop fs-Befehle

In diesem Artikel werden die Dateihandhabungsbefehle von HADOOP beschrieben, mit denen die Dateien über die Konsole verwaltet werden.

Sie benötigen ein Linux-System und die neueste Hadoop-Version. Um die Hadoop-Version auszudrucken, um zu wissen, von wem das Release erstellt wurde, und um den Prüfsummenwert zu ermitteln, müssen wir nur den folgenden Befehl ausführen, nachdem wir uns auf der Hadoop-Plattform angemeldet haben.

Befehl: Hadoop-Version

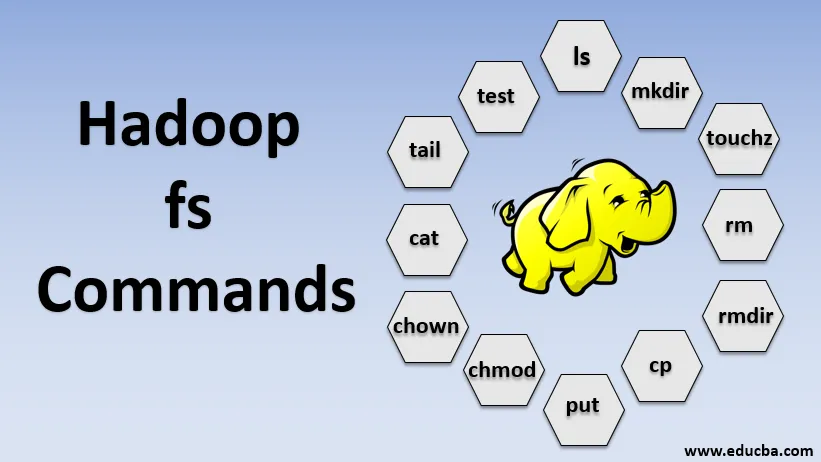

Befehle von Hadoop fs

Nun wollen wir lernen, wie man HADOOP-fs-Befehle verwendet.

Wir werden mit den Grundlagen beginnen. Geben Sie diese Befehle einfach in PUTTY oder in eine beliebige Konsole ein, mit der Sie vertraut sind.

1. hadoop fs -ls

Bei einem Verzeichnis wird die Liste der Dateien und Verzeichnisse zurückgegeben, während bei einer Datei die Statistik für die Datei zurückgegeben wird.

hadoop fs -lsr: Hiermit werden die Verzeichnisse und Dateien in bestimmten Ordnern rekursiv aufgelistet .

- Beispiel : hadoop fs -ls / oder hadoop fs -lsr

- -d: Hiermit werden die Verzeichnisse als reine Dateien aufgelistet.

- -h: Dies wird verwendet, um die Größe von Dateien so zu formatieren, dass sie besser lesbar sind als nur die Anzahl der Bytes.

- -R: Hiermit wird der Inhalt von Verzeichnissen rekursiv aufgelistet.

2. hadoop fs -mkdir

Dieser Befehl nimmt den Pfad als Argument und erstellt Verzeichnisse in hdfs.

- Beispiel : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Es erstellt eine leere Datei und verwendet keinen Speicherplatz

- Beispiel: hadoop fs -touchz URI

4. hadoop fs -rm

Löscht die als Argument angegebenen Dateien. Wir müssen die Option -r angeben, um das gesamte Verzeichnis zu löschen. Wenn die Option -skipTrash angegeben wird, wird der Papierkorb übersprungen und die Datei wird sofort gelöscht.

- Beispiel : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Es entfernt Dateien und Berechtigungen von Verzeichnissen und Unterverzeichnissen. Grundsätzlich handelt es sich um die erweiterte Version des Hadoop fs -rm.

6. hadoop fs -cp

Es kopiert die Datei von einem Ort zum anderen

- Beispiel : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Es kopiert die Datei von edgenode nach HDFS.

8. hadoop fs -put

Es kopiert die Datei von edgenode nach HDFS, es ähnelt dem vorherigen Befehl, aber put liest auch Eingaben von der Standardeingabe stdin und schreibt in HDFS

- Beispiel : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: Das Flag behält den Zugriff, die Änderungszeit, den Besitz und den Modus bei.

hadoop fs -put -f: Dieser Befehl überschreibt das Ziel, wenn die Datei vor dem Kopieren bereits vorhanden ist.

9. hadoop fs -moveFromLocal

Es ähnelt dem Kopieren von lokal, mit der Ausnahme, dass die Quelldatei nach dem Kopieren in HDFS von lokalem edgenode gelöscht wird

- Beispiel : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Es kopiert die Datei von HDFS nach edgenode.

- Beispiel : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Dieser Befehl hilft uns, den Zugriff auf eine Datei oder ein Verzeichnis zu ändern

- Beispiel : hadoop fs -chmod (-R) (Pfad)

12. hadoop fs -chown

Dieser Befehl hilft uns, den Besitz einer Datei oder eines Verzeichnisses zu ändern

- Beispiel : hadoop fs -chown (-R) (BESITZER) (:( GRUPPE)) PFAD

13. hadoop fs -cat

Es druckt den Inhalt einer HDFS-Datei auf dem Terminal

- Beispiel : hadoop fs -cat /user/data/abc.csv

14. Hadoop fs-Schwanz

Es zeigt die letzte KB der HDFS-Datei für die Standardausgabe an

- Beispiel : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Dieser Befehl wird für HDFS-Dateitestvorgänge verwendet und gibt 0 zurück, wenn er wahr ist.

- - e: prüft, ob die Datei existiert.

- -z: Überprüft, ob die Datei die Länge Null hat

- -d / -f: Überprüft, ob der Pfad Verzeichnis / Datei ist

Hier diskutieren wir ein Beispiel im Detail

- Beispiel : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Zeigt die Größe von Dateien und Verzeichnissen an, die im angegebenen Verzeichnis enthalten sind, oder die Länge einer Datei, falls es sich um eine Datei handelt

17. hadoop fs -df

Es zeigt freien Speicherplatz an

18. hadoop fs -checksum

Gibt die Prüfsummeninformationen einer Datei zurück

19. hadoop fs -getfacl

Es zeigt die Zugriffssteuerungsliste (ACLs) der jeweiligen Datei oder des jeweiligen Verzeichnisses an

20. hadoop fs -count

Es zählt die Anzahl der Verzeichnisse, Dateien und Bytes unter dem Pfad, der dem angegebenen Dateimuster entspricht.

21. hadoop fs -setrep

Ändert den Replikationsfaktor einer Datei. Wenn der Pfad ein Verzeichnis ist, ändert der Befehl den Replikationsfaktor aller Dateien im Verzeichnis.

- Beispiel : hadoop fs -setrep -R / user / datahub: Wird verwendet, um die Rückwärtsfähigkeit zu akzeptieren, und hat keine Auswirkung.

hadoop fs - setrep - w / user / datahub : Wartet, bis die Replikation abgeschlossen ist

22. hadoop fs -getmerge

Es verknüpft HDFS-Dateien in der Quelle mit der lokalen Zieldatei

- Beispiel : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Hängt eine einzelne Quelle oder mehrere Quellen aus dem lokalen Dateisystem an das Ziel an.

- Beispiel : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Es druckt die Statistiken über die Datei oder das Verzeichnis.

- Beispiel : hadoop fs -stat (Format)

Fazit - Hadoop fs Befehle

Wir haben also fast alle Befehle durchgearbeitet, die für die Dateiverwaltung erforderlich sind, und die Daten in den Dateien angezeigt. Sie können jetzt Ihre Dateien ändern und Daten in die Hadoop-Plattform einlesen.

Empfohlene Artikel

Dies ist eine Anleitung zu Hadoop fs-Befehlen. Hier diskutieren wir die Einführung in Hadoop-fs-Befehle zusammen mit ihrem Beispiel im Detail. Sie können sich auch die folgenden Artikel ansehen, um mehr zu erfahren.

- Installieren Sie Hadoop

- Hadoop Tools

- Hadoop-Architektur

- Hadoop-Komponenten

- Hadoop fs Befehle