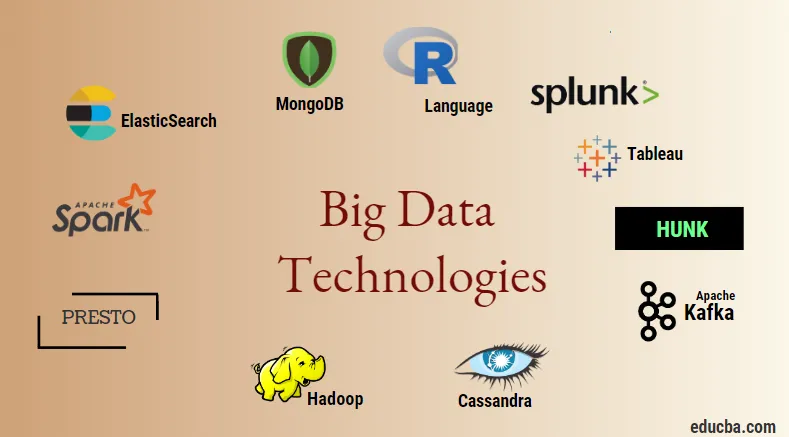

Einführung in Big Data-Technologien

Big Data-Technologie und Hadoop sind ein großes Schlagwort, wie es klingen mag. Da der Daten- und Informationsbereich in jeder Branche und Domäne enorm zugenommen hat, ist es sehr wichtig, eine effiziente Technik zu etablieren und einzuführen, die alle Bedürfnisse und Anforderungen von Kunden und großen Branchen berücksichtigt, die für die Datenerzeugung verantwortlich sind . Früher wurden die Daten von normalen Programmiersprachen und einer einfachen strukturierten Abfragesprache verarbeitet, aber jetzt scheinen diese Systeme und Tools bei Big Data nicht viel zu bewirken. Unter Big-Data-Technologie versteht man die Technologie und ein Software-Dienstprogramm, das zur Analyse, Verarbeitung und Extraktion von Informationen aus einem großen Satz extrem komplexer Strukturen und großer Datensätze entwickelt wurde, mit denen die traditionellen Systeme nur schwer fertig werden können. Die Big-Data-Technologie wird sowohl für Echtzeit- als auch für Batch-bezogene Daten verwendet. Maschinelles Lernen ist zu einem sehr wichtigen Bestandteil des Alltags und jeder Branche geworden, und daher wird das Verwalten von Daten über Big Data sehr wichtig.

Arten von Big Data-Technologien

Bevor wir mit der Liste der Technologien beginnen, sehen wir uns zunächst die breite Klassifizierung all dieser Technologien an. Sie können hauptsächlich in 4 Domänen eingeteilt werden.

- Datenspeicher

- Analytics

- Data Mining

- Visualisierung

Lassen Sie uns zunächst alle Technologien behandeln, die unter dem Dach des Speichers stehen.

1. Hadoop : Wenn es um Big Data geht, ist Hadoop die erste Technologie, die ins Spiel kommt. Dies basiert auf einer Map-Reduction-Architektur und hilft bei der Verarbeitung von Batch-bezogenen Jobs und der Verarbeitung von Batch-Informationen. Es wurde entwickelt, um die Daten in einer verteilten Datenverarbeitungsumgebung zusammen mit Standardhardware und einem einfachen Programmierausführungsmodell zu speichern und zu verarbeiten. Es kann zum Speichern und Analysieren der Daten verwendet werden, die in verschiedenen Maschinen mit hoher Speicherkapazität, Geschwindigkeit und geringen Kosten vorhanden sind. Dies ist eine der Hauptkomponenten der Big-Data-Technologie, die von der Apache-Softwarestiftung im Jahr 2011 entwickelt und in Java geschrieben wurde.

1. Hadoop : Wenn es um Big Data geht, ist Hadoop die erste Technologie, die ins Spiel kommt. Dies basiert auf einer Map-Reduction-Architektur und hilft bei der Verarbeitung von Batch-bezogenen Jobs und der Verarbeitung von Batch-Informationen. Es wurde entwickelt, um die Daten in einer verteilten Datenverarbeitungsumgebung zusammen mit Standardhardware und einem einfachen Programmierausführungsmodell zu speichern und zu verarbeiten. Es kann zum Speichern und Analysieren der Daten verwendet werden, die in verschiedenen Maschinen mit hoher Speicherkapazität, Geschwindigkeit und geringen Kosten vorhanden sind. Dies ist eine der Hauptkomponenten der Big-Data-Technologie, die von der Apache-Softwarestiftung im Jahr 2011 entwickelt und in Java geschrieben wurde.

2. MongoDB : Eine weitere wichtige und zentrale Komponente der Big-Data-Technologie im Hinblick auf die Speicherung ist die MongoDB NoSQL-Datenbank. Es ist eine NoSQL-Datenbank, was bedeutet, dass die relationalen Eigenschaften und andere RDBMS-bezogene Eigenschaften nicht auf sie zutreffen. Es unterscheidet sich von herkömmlichen RDBMS-Datenbanken, die eine strukturierte Abfragesprache verwenden. Es werden Schemadokumente verwendet, und auch die Struktur der Datenspeicherung ist unterschiedlich. Daher sind sie hilfreich, um eine große Datenmenge zu speichern. Es ist ein plattformübergreifendes dokumentenorientiertes Design- und Datenbankprogramm, das JSON-ähnliche Dokumente zusammen mit dem Schema verwendet. Dies wird zu einem sehr nützlichen Anwendungsfall für betriebliche Datenspeicher in den meisten Finanzinstituten, um die traditionellen Mainframes zu ersetzen. MongoDB verarbeitet Flexibilität und eine Vielzahl von Datentypen bei hohen Volumina und verteilten Architekturen.

2. MongoDB : Eine weitere wichtige und zentrale Komponente der Big-Data-Technologie im Hinblick auf die Speicherung ist die MongoDB NoSQL-Datenbank. Es ist eine NoSQL-Datenbank, was bedeutet, dass die relationalen Eigenschaften und andere RDBMS-bezogene Eigenschaften nicht auf sie zutreffen. Es unterscheidet sich von herkömmlichen RDBMS-Datenbanken, die eine strukturierte Abfragesprache verwenden. Es werden Schemadokumente verwendet, und auch die Struktur der Datenspeicherung ist unterschiedlich. Daher sind sie hilfreich, um eine große Datenmenge zu speichern. Es ist ein plattformübergreifendes dokumentenorientiertes Design- und Datenbankprogramm, das JSON-ähnliche Dokumente zusammen mit dem Schema verwendet. Dies wird zu einem sehr nützlichen Anwendungsfall für betriebliche Datenspeicher in den meisten Finanzinstituten, um die traditionellen Mainframes zu ersetzen. MongoDB verarbeitet Flexibilität und eine Vielzahl von Datentypen bei hohen Volumina und verteilten Architekturen.

3. Hunk : Es ist nützlich, um über entfernte Hadoop-Cluster auf Daten zuzugreifen, indem virtuelle Indizes verwendet werden. Außerdem wird die Verarbeitungssprache für Splunk-Suchvorgänge verwendet, die für die Analyse von Daten verwendet werden kann. Der Block kann verwendet werden, um große Datenmengen aus den Hadoop- und NoSQL-Datenbanken und -Quellen zu melden und zu visualisieren. Es wurde von Team Splunk im Jahr 2013 entwickelt und in Java geschrieben.

3. Hunk : Es ist nützlich, um über entfernte Hadoop-Cluster auf Daten zuzugreifen, indem virtuelle Indizes verwendet werden. Außerdem wird die Verarbeitungssprache für Splunk-Suchvorgänge verwendet, die für die Analyse von Daten verwendet werden kann. Der Block kann verwendet werden, um große Datenmengen aus den Hadoop- und NoSQL-Datenbanken und -Quellen zu melden und zu visualisieren. Es wurde von Team Splunk im Jahr 2013 entwickelt und in Java geschrieben.

4. Cassandra : Cassandra ist eine der beliebtesten NoSQL-Datenbanken. Es handelt sich um eine kostenlose und eine Open-Source-Datenbank, die verteilt ist, einen breiten spaltenweisen Speicher hat und Daten in großen Warengruppen effizient verarbeiten kann, dh wie gewohnt Bieten hohe Verfügbarkeit ohne einzelne Fehlerquellen. Zu den wichtigsten Funktionen gehören die Funktionen "Distributed Nature", "Scalability", "Fehlertoleranter Mechanismus", "MapReduce-Unterstützung", "Tunable Consistency", "Query Language Property", "Multi-Data-Center-Replikation" und "Eventual Consistency".

4. Cassandra : Cassandra ist eine der beliebtesten NoSQL-Datenbanken. Es handelt sich um eine kostenlose und eine Open-Source-Datenbank, die verteilt ist, einen breiten spaltenweisen Speicher hat und Daten in großen Warengruppen effizient verarbeiten kann, dh wie gewohnt Bieten hohe Verfügbarkeit ohne einzelne Fehlerquellen. Zu den wichtigsten Funktionen gehören die Funktionen "Distributed Nature", "Scalability", "Fehlertoleranter Mechanismus", "MapReduce-Unterstützung", "Tunable Consistency", "Query Language Property", "Multi-Data-Center-Replikation" und "Eventual Consistency".

Lassen Sie uns als Nächstes über die verschiedenen Bereiche der Big-Data-Technologie, dh Data Mining, sprechen.

5. Presto : Es handelt sich um eine beliebte Open-Source- und SQL-basierte verteilte Abfrage-Engine, die zum Ausführen interaktiver Abfragen für die Datenquellen jeder Skala verwendet wird und deren Größe von Gigabyte bis Petabyte reicht. Mit seiner Hilfe können wir Daten in Cassandra, Hive, proprietären Datenspeichern und relationalen Datenbankspeichersystemen abfragen. Dies ist eine Java-basierte Abfrage-Engine, die von der Apache-Stiftung im Jahr 2013 entwickelt wurde. Einige Unternehmen, die das Presto-Tool gut nutzen, sind Netflix, Airbnb, Checkr, Repro und Facebook.

5. Presto : Es handelt sich um eine beliebte Open-Source- und SQL-basierte verteilte Abfrage-Engine, die zum Ausführen interaktiver Abfragen für die Datenquellen jeder Skala verwendet wird und deren Größe von Gigabyte bis Petabyte reicht. Mit seiner Hilfe können wir Daten in Cassandra, Hive, proprietären Datenspeichern und relationalen Datenbankspeichersystemen abfragen. Dies ist eine Java-basierte Abfrage-Engine, die von der Apache-Stiftung im Jahr 2013 entwickelt wurde. Einige Unternehmen, die das Presto-Tool gut nutzen, sind Netflix, Airbnb, Checkr, Repro und Facebook.

6. ElasticSearch : Dies ist heute ein sehr wichtiges Tool für die Suche. Dies ist ein wesentlicher Bestandteil des ELK-Stacks, dh die elastische Suche, Logstash und Kibana. ElasticSearch ist eine auf Lucene-Bibliotheken basierende Suchmaschine, die Solr ähnelt und verwendet wird, um eine rein verteilte, mandantenfähige Volltextsuchmaschine bereitzustellen. Es verfügt über eine Liste schemafreier JSON-Dokumente und eine HTTP-Webschnittstelle. Es ist in der Sprache JAVA geschrieben und wird von Elastic Company in der Firma 2012 entwickelt. Die Namen einiger Firmen, die Elasticsearch verwenden, sind: LinkedIn, StackOverflow, Netflix, Facebook, Google, Accenture usw.

6. ElasticSearch : Dies ist heute ein sehr wichtiges Tool für die Suche. Dies ist ein wesentlicher Bestandteil des ELK-Stacks, dh die elastische Suche, Logstash und Kibana. ElasticSearch ist eine auf Lucene-Bibliotheken basierende Suchmaschine, die Solr ähnelt und verwendet wird, um eine rein verteilte, mandantenfähige Volltextsuchmaschine bereitzustellen. Es verfügt über eine Liste schemafreier JSON-Dokumente und eine HTTP-Webschnittstelle. Es ist in der Sprache JAVA geschrieben und wird von Elastic Company in der Firma 2012 entwickelt. Die Namen einiger Firmen, die Elasticsearch verwenden, sind: LinkedIn, StackOverflow, Netflix, Facebook, Google, Accenture usw.

Lassen Sie uns nun über alle Big-Data-Technologien lesen, die Teil der Datenanalyse sind:

7. Apache Kafka : Bekannt für seine Publish-Subscribe- oder Pub-Sub-Funktion, die im Volksmund als Direct-Messaging-, asynchrones Messaging-Broker-System bezeichnet wird, mit dem Daten in Echtzeit für Streaming-Daten erfasst und verarbeitet werden. Es sieht auch eine Bestimmung der Aufbewahrungsdauer vor und die Daten können mittels eines Erzeuger-Verbraucher-Mechanismus kanalisiert werden. Es ist eine der beliebtesten Streaming-Plattformen, die dem Enterprise-Messaging-System oder einer Messaging-Warteschlange sehr ähnlich ist. Kafka hat bis heute viele Verbesserungen eingeführt. Eine der wichtigsten Neuerungen ist die des Kafka-Zusammenflusses, die Kafka eine zusätzliche Ebene von Eigenschaften wie Schema-Registrierung, Ktables, KSql usw. bietet. Sie wurde von der Apache Software-Community im Jahr 2011 und 2011 entwickelt ist in Java geschrieben. Zu den Unternehmen, die diese Technologie einsetzen, gehören Twitter, Spotify, Netflix, Linkedin, Yahoo usw.

7. Apache Kafka : Bekannt für seine Publish-Subscribe- oder Pub-Sub-Funktion, die im Volksmund als Direct-Messaging-, asynchrones Messaging-Broker-System bezeichnet wird, mit dem Daten in Echtzeit für Streaming-Daten erfasst und verarbeitet werden. Es sieht auch eine Bestimmung der Aufbewahrungsdauer vor und die Daten können mittels eines Erzeuger-Verbraucher-Mechanismus kanalisiert werden. Es ist eine der beliebtesten Streaming-Plattformen, die dem Enterprise-Messaging-System oder einer Messaging-Warteschlange sehr ähnlich ist. Kafka hat bis heute viele Verbesserungen eingeführt. Eine der wichtigsten Neuerungen ist die des Kafka-Zusammenflusses, die Kafka eine zusätzliche Ebene von Eigenschaften wie Schema-Registrierung, Ktables, KSql usw. bietet. Sie wurde von der Apache Software-Community im Jahr 2011 und 2011 entwickelt ist in Java geschrieben. Zu den Unternehmen, die diese Technologie einsetzen, gehören Twitter, Spotify, Netflix, Linkedin, Yahoo usw.

8. Splunk : Splunk wird zum Erfassen, Korrelieren und Indizieren von Echtzeit-Streaming-Daten aus einem durchsuchbaren Repository verwendet, aus dem Berichte, Diagramme, Dashboards, Warnungen und Datenvisualisierungen generiert werden können. Es wird auch für das Sicherheits-, Compliance- und Anwendungsmanagement sowie für Webanalysen verwendet, um Geschäftserkenntnisse und Geschäftsanalysen zu generieren. Es wurde von Splunk in Python, XML, Ajax entwickelt.

8. Splunk : Splunk wird zum Erfassen, Korrelieren und Indizieren von Echtzeit-Streaming-Daten aus einem durchsuchbaren Repository verwendet, aus dem Berichte, Diagramme, Dashboards, Warnungen und Datenvisualisierungen generiert werden können. Es wird auch für das Sicherheits-, Compliance- und Anwendungsmanagement sowie für Webanalysen verwendet, um Geschäftserkenntnisse und Geschäftsanalysen zu generieren. Es wurde von Splunk in Python, XML, Ajax entwickelt.

9. Apache Spark : Jetzt kommt die kritischste und am meisten erwartete Technologie im Bereich der Big Data-Technologien, dh Apache Spark. Es gehört möglicherweise zu den derzeit gefragtesten und nutzt Java, Scala oder Python für seine Verarbeitung. Dies wird verwendet, um die Echtzeit-Streaming-Daten zu verarbeiten und zu verarbeiten, indem Spark Streaming verwendet wird, das Batching- und Fensteroperationen verwendet, um dies zu ermöglichen. Spark SQL wird verwendet, um Datenrahmen und Datasets auf RDDs zu erstellen und damit einen guten Überblick über Transformationen und Aktionen zu erhalten, die einen integralen Bestandteil von Apache Spark Core bilden. Andere Komponenten wie Spark Mllib, R und graphX eignen sich auch für Analysen, maschinelles Lernen und Data Science. Die In-Memory-Computing-Technik unterscheidet sich von anderen Tools und Komponenten und unterstützt eine Vielzahl von Anwendungen. Es wurde von der Apache Software Foundation hauptsächlich in Java-Sprache entwickelt.

9. Apache Spark : Jetzt kommt die kritischste und am meisten erwartete Technologie im Bereich der Big Data-Technologien, dh Apache Spark. Es gehört möglicherweise zu den derzeit gefragtesten und nutzt Java, Scala oder Python für seine Verarbeitung. Dies wird verwendet, um die Echtzeit-Streaming-Daten zu verarbeiten und zu verarbeiten, indem Spark Streaming verwendet wird, das Batching- und Fensteroperationen verwendet, um dies zu ermöglichen. Spark SQL wird verwendet, um Datenrahmen und Datasets auf RDDs zu erstellen und damit einen guten Überblick über Transformationen und Aktionen zu erhalten, die einen integralen Bestandteil von Apache Spark Core bilden. Andere Komponenten wie Spark Mllib, R und graphX eignen sich auch für Analysen, maschinelles Lernen und Data Science. Die In-Memory-Computing-Technik unterscheidet sich von anderen Tools und Komponenten und unterstützt eine Vielzahl von Anwendungen. Es wurde von der Apache Software Foundation hauptsächlich in Java-Sprache entwickelt.

10. R-Sprache : R ist eine Programmiersprache und eine freie Software-Umgebung, die für statistische Berechnungen sowie für Grafiken in einer der wichtigsten Sprachen in R verwendet wird. Dies ist eine der beliebtesten Sprachen unter Datenwissenschaftlern, Data Minern und Datenpraktiker für die Entwicklung statistischer Software und hauptsächlich für die Datenanalyse.

10. R-Sprache : R ist eine Programmiersprache und eine freie Software-Umgebung, die für statistische Berechnungen sowie für Grafiken in einer der wichtigsten Sprachen in R verwendet wird. Dies ist eine der beliebtesten Sprachen unter Datenwissenschaftlern, Data Minern und Datenpraktiker für die Entwicklung statistischer Software und hauptsächlich für die Datenanalyse.

Lassen Sie uns nun die Technologien im Zusammenhang mit der Datenvisualisierung diskutieren.

11. Tableau: Es ist das am schnellsten und leistungsfähigsten wachsende Datenvisualisierungstool, das im Bereich Business Intelligence eingesetzt wird. Die Datenanalyse ist eine sehr schnelle Maschine, die mit Hilfe von Tableau möglich ist, und Visualisierungen werden in Form von Arbeitsblättern und Dashboards erstellt. Es wurde vom Tableau-Unternehmen im Jahr 2013 entwickelt und ist in Python, C ++, Java und C geschrieben. Folgende Unternehmen setzen Tableau ein: QlikQ, Oracle Hyperion, Cognos usw.

11. Tableau: Es ist das am schnellsten und leistungsfähigsten wachsende Datenvisualisierungstool, das im Bereich Business Intelligence eingesetzt wird. Die Datenanalyse ist eine sehr schnelle Maschine, die mit Hilfe von Tableau möglich ist, und Visualisierungen werden in Form von Arbeitsblättern und Dashboards erstellt. Es wurde vom Tableau-Unternehmen im Jahr 2013 entwickelt und ist in Python, C ++, Java und C geschrieben. Folgende Unternehmen setzen Tableau ein: QlikQ, Oracle Hyperion, Cognos usw.

12. Plotly : Plotly wird hauptsächlich verwendet, um Diagramme und zugehörige Komponenten schneller und effizienter zu machen. Es verfügt über umfangreichere Bibliotheken und APIs wie MATLAB, Python, R, Arduino, Julia usw. Dies kann interaktiv in Jupyter Notebook und Pycharm verwendet werden und zum Erstellen interaktiver Diagramme verwendet werden. Es wurde erstmals im Jahr 2012 entwickelt und in Javascript geschrieben. Die wenigen Firmen, die Plotly verwenden, sind Paladine, Bitbanken usw.

12. Plotly : Plotly wird hauptsächlich verwendet, um Diagramme und zugehörige Komponenten schneller und effizienter zu machen. Es verfügt über umfangreichere Bibliotheken und APIs wie MATLAB, Python, R, Arduino, Julia usw. Dies kann interaktiv in Jupyter Notebook und Pycharm verwendet werden und zum Erstellen interaktiver Diagramme verwendet werden. Es wurde erstmals im Jahr 2012 entwickelt und in Javascript geschrieben. Die wenigen Firmen, die Plotly verwenden, sind Paladine, Bitbanken usw.

Fazit

In diesem Beitrag haben wir uns mit den wichtigsten Big-Data-Technologien befasst, die heute weit verbreitet sind. Hoffe es hat euch gefallen. Folgen Sie uns für weitere Beiträge wie diese.

Empfohlene Artikel

Dies ist eine Anleitung zu Big Data Technologies. Hier haben wir eine Einführung und Arten von Big Data-Technologien diskutiert. Sie können auch unsere anderen Artikelvorschläge durchgehen, um mehr zu erfahren -

- Was ist Splunk Tool?

- R gegen Python

- Was ist Matlab?

- Was ist MongoDB?

- Schritte zum Testen von Mainframes

- Arten von Joins in Spark SQL (Beispiele)

- Lernen Sie die verschiedenen Arten von Kafka-Werkzeugen