Unterschied zwischen Hadoop vs Spark

Hadoop ist ein Open-Source-Framework, mit dem Big Data in einer verteilten Umgebung auf mehreren Computerclustern gespeichert und verarbeitet werden kann. Hadoop wurde für die Skalierung von einem einzelnen Server auf Tausende von Computern entwickelt, auf denen jeder Computer lokale Berechnungen und Speicher bietet. Spark ist ein Open-Source-Cluster-Computing, das für schnelle Berechnungen entwickelt wurde. Es bietet eine Schnittstelle für die Programmierung ganzer Cluster mit impliziter Datenparallelität und Fehlertoleranz. Das Hauptmerkmal von Spark ist das In-Memory-Cluster-Computing, das die Geschwindigkeit einer Anwendung erhöht.

Hadoop

- Hadoop ist eine eingetragene Marke der Apache Software Foundation. Es verwendet ein einfaches Programmiermodell, um die erforderliche Operation zwischen Clustern auszuführen. Alle Module in Hadoop basieren auf der grundlegenden Annahme, dass Hardwarefehler häufig vorkommen und vom Framework behandelt werden sollten.

- Die Anwendung wird mit dem MapReduce-Algorithmus ausgeführt, bei dem Daten auf verschiedenen CPU-Knoten parallel verarbeitet werden. Mit anderen Worten, das Hadoop-Framework ist in der Lage, Anwendungen zu entwickeln, die auch auf Computerclustern ausgeführt werden können, und sie können eine vollständige statistische Analyse für eine große Datenmenge durchführen.

- Der Kern von Hadoop besteht aus einem Speicherteil, der als Hadoop Distributed File System bezeichnet wird, und einem Verarbeitungsteil, dem MapReduce-Programmiermodell. Hadoop teilt Dateien grundsätzlich in große Blöcke auf und verteilt sie auf die Cluster. Paketcode wird in Knoten übertragen, um Daten parallel zu verarbeiten.

- Dieser Ansatzdatensatz soll schneller und effizienter verarbeitet werden. Andere Hadoop-Module sind Hadoop-Common, eine Reihe von Java-Bibliotheken und -Dienstprogrammen, die von Hadoop-Modulen zurückgegeben werden. Diese Bibliotheken stellen eine Abstraktion auf Dateisystem- und Betriebssystemebene bereit und enthalten auch die erforderlichen Java-Dateien und -Skripts, um Hadoop zu starten. Hadoop Yarn ist auch ein Modul, das für die Auftragsplanung und die Verwaltung von Clusterressourcen verwendet wird.

Funke

- Spark basiert auf dem Hadoop MapReduce-Modul und erweitert das MapReduce-Modell, um mehr Arten von Berechnungen effizient zu nutzen, einschließlich interaktiver Abfragen und Stream-Verarbeitung. Spark wurde von der Apache-Softwarestiftung eingeführt, um den Prozess der Hadoop-Computersoftware zu beschleunigen.

- Spark verfügt über eine eigene Clusterverwaltung und ist keine modifizierte Version von Hadoop. Spark nutzt Hadoop auf zwei Arten - zum einen im Speicher und zum anderen in der Verarbeitung. Da die Clusterverwaltung von Spark selbst stammt, wird Hadoop nur zu Speicherzwecken verwendet.

- Spark ist eines der Teilprojekte von Hadoop, das 2009 entwickelt wurde und später unter einer BSD-Lizenz Open Source wurde. Es hat viele wundervolle Funktionen, indem bestimmte Module modifiziert und neue Module eingebaut werden. Es hilft dabei, eine Anwendung in einem Hadoop-Cluster auszuführen, und zwar um ein Vielfaches schneller im Arbeitsspeicher.

- Dies wird ermöglicht, indem die Anzahl der Lese- / Schreibvorgänge auf der Festplatte verringert wird. Es speichert die Zwischenverarbeitungsdaten im Speicher und speichert Lese- / Schreibvorgänge. Spark bietet auch integrierte APIs in Java, Python oder Scala. Somit kann man Anwendungen auf verschiedene Arten schreiben. Spark bietet nicht nur eine Map and Reduce-Strategie, sondern unterstützt auch SQL-Abfragen, Streaming-Daten, maschinelles Lernen und Graph-Algorithmen.

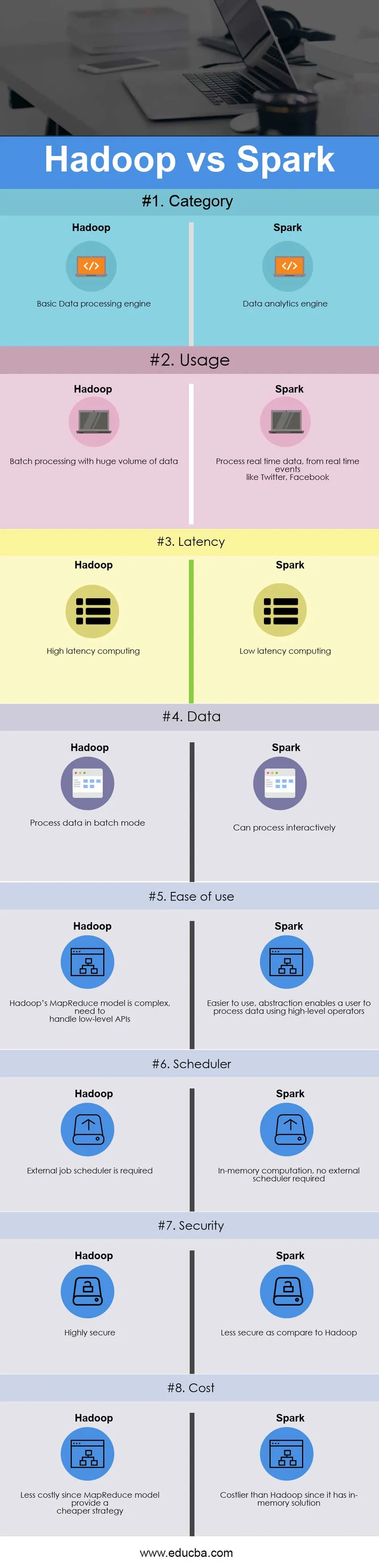

Head to Head Vergleich zwischen Hadoop und Spark (Infografik)

Unten ist der Top 8 Unterschied zwischen Hadoop vs Spark

Hauptunterschiede zwischen Hadoop und Spark

Sowohl Hadoop als auch Spark sind auf dem Markt sehr beliebt. Lassen Sie uns einige der wichtigsten Unterschiede zwischen Hadoop und Spark diskutieren:

- Hadoop ist ein Open-Source-Framework, das einen MapReduce-Algorithmus verwendet, während Spark eine blitzschnelle Cluster-Computing-Technologie ist, die das MapReduce-Modell erweitert, um effizientere Berechnungen zu ermöglichen.

- Das MapReduce-Modell von Hadoop liest und schreibt von einer Festplatte und verlangsamt so die Verarbeitungsgeschwindigkeit, während Spark die Anzahl der Lese- / Schreibzyklen auf der Festplatte und das Speichern von Zwischendaten im Speicher verringert und somit die Verarbeitungsgeschwindigkeit erhöht.

- Bei Hadoop müssen Entwickler jeden Vorgang selbst programmieren, während Spark mit RDD - Resilient Distributed Dataset einfach zu programmieren ist.

- Das Hadoop MapReduce-Modell bietet eine Batch-Engine, die für andere Anforderungen von verschiedenen Engines abhängig ist, während Spark Batch-, interaktive, maschinelle Lern- und Streaming-Funktionen in demselben Cluster ausführt.

- Hadoop ist für eine effiziente Stapelverarbeitung ausgelegt, während Spark für eine effiziente Verarbeitung von Echtzeitdaten ausgelegt ist.

- Hadoop ist ein Computing-Framework mit hoher Latenz, das keinen interaktiven Modus hat, während Spark ein Computing mit niedriger Latenz ist und Daten interaktiv verarbeiten kann.

- Mit Hadoop MapReduce kann ein Entwickler Daten nur im Batch-Modus verarbeiten, während Spark Echtzeitdaten über Spark Streaming verarbeiten kann.

- Hadoop wurde für die Behandlung von Fehlern und Ausfällen entwickelt. Es ist von Natur aus fehlerunempfindlich und daher ein hochgradig fehlertolerantes System, während RDD mit Spark die Wiederherstellung von Partitionen auf ausgefallenen Knoten ermöglicht.

- Hadoop benötigt beispielsweise einen externen Job-Scheduler - Oozie zum Planen komplexer Abläufe, während Spark über speicherinterne Berechnungen verfügt und daher über einen eigenen Flow-Scheduler verfügt.

- Hadoop ist eine billigere Option, wenn man die Kosten vergleicht, wohingegen Spark viel RAM benötigt, um im Arbeitsspeicher ausgeführt zu werden, was den Cluster und damit die Kosten erhöht.

Hadoop vs Spark Vergleichstabelle

Der primäre Vergleich zwischen Hadoop und Spark wird im Folgenden erörtert

| Die Vergleichsbasis zwischen Hadoop vs Spark |

Hadoop |

Funke |

| Kategorie | Basic Data Processing Engine | Datenanalyse-Engine |

| Verwendung | Stapelverarbeitung mit einem riesigen Datenvolumen | Verarbeiten Sie Echtzeitdaten von Echtzeitereignissen wie Twitter, Facebook |

| Latenz | Rechnen mit hoher Latenz | Computer mit geringer Latenz |

| Daten | Daten im Batch-Modus verarbeiten | Kann interaktiv verarbeiten |

| Benutzerfreundlichkeit | Das MapReduce-Modell von Hadoop ist komplex und muss mit APIs auf niedriger Ebene umgehen | Die einfachere Verwendung der Abstraktion ermöglicht es einem Benutzer, Daten mit Operatoren auf hoher Ebene zu verarbeiten |

| Planer | Externer Job Scheduler ist erforderlich | In-Memory-Berechnung, kein externer Scheduler erforderlich |

| Sicherheit | Sehr sicher | Weniger sicher als bei Hadoop |

| Kosten | Weniger kostspielig, da das MapReduce-Modell eine günstigere Strategie bietet | Kostspieliger als Hadoop, da es eine In-Memory-Lösung gibt |

Fazit - Hadoop vs Spark

Hadoop MapReduce ermöglicht die parallele Verarbeitung großer Datenmengen. Es zerlegt einen großen Teil in kleinere Teile, die separat auf verschiedenen Datenknoten verarbeitet werden sollen, und sammelt die Ergebnisse automatisch auf mehreren Knoten, um ein einzelnes Ergebnis zurückzugeben. Falls der resultierende Datensatz größer ist als der verfügbare Arbeitsspeicher, kann Hadoop MapReduce die Leistung von Spark übertreffen.

Auf der anderen Seite ist Spark einfacher zu verwenden als Hadoop, da es benutzerfreundliche APIs für Scala (seine Muttersprache), Java, Python und Spark SQL enthält. Da Spark die Möglichkeit bietet, Streaming, Stapelverarbeitung und maschinelles Lernen in demselben Cluster durchzuführen, ist es für Benutzer einfach, ihre Infrastruktur für die Datenverarbeitung zu vereinfachen.

Die endgültige Entscheidung zwischen Hadoop und Spark hängt von den grundlegenden Parameteranforderungen ab. Apache Spark ist eine weitaus fortschrittlichere Cluster-Computing-Engine als MapReduce von Hadoop, da sie alle Arten von Anforderungen verarbeiten kann, z. B. Stapelverarbeitung, interaktive Verarbeitung, iterative Verarbeitung, Streaming usw. Gleichzeitig ist Spark mit seiner In-Memory-Funktion teurer als Hadoop, was schließlich viel RAM erfordert. Letztendlich hängt alles vom Budget und den funktionalen Anforderungen eines Unternehmens ab. Ich hoffe, Sie haben jetzt eine bessere Vorstellung von Hadoop und Spark.

Empfohlener Artikel

Dies war ein Leitfaden für den Hauptunterschied zwischen Hadoop und Spark. Hier werden auch die Hauptunterschiede zwischen Hadoop und Spark mit Infografiken und die Vergleichstabelle besprochen. Weitere Informationen finden Sie auch in den folgenden Artikeln zu Hadoop vs Spark.

- Data Warehouse gegen Hadoop

- Splunk vs Spark

- Hadoop vs Cassandra - 17 Awesome Unterschiede

- Pig vs Spark - Welches ist besser

- Hadoop vs SQL-Leistung: Unterschied