Was ist das Apache Hadoop-Ökosystem?

Das Apache Hadoop-Ökosystem ist ein Framework oder eine Open-Source-Datenplattform, die zum Speichern und Untersuchen der riesigen unstrukturierten Datensammlungen vorgesehen ist. Überall auf der Welt werden mit der führenden innovativen Technologie von Big Data Unmengen von Daten von zahlreichen digitalen Plattformen übertragen. Darüber hinaus war Apache Hadoop der erste, der diesen Innovationsstrom erhielt.

Was beinhaltet die Hadoop Data Architektur / das Ökosystem?

Das Hadoop-Ökosystem ist keine Programmiersprache oder ein Dienst, sondern ein Framework oder eine Plattform, die sich um Big-Data-Probleme kümmert. Sie können es als eine Suite identifizieren, die verschiedene Dienste umfasst, z. B. das Speichern, Aufnehmen, Verwalten und Analysieren von Inhalten. Dann prüfen Sie und verschaffen Sie sich einen prägnanten Überblick darüber, wie die Dienste ausschließlich und in Zusammenarbeit funktionieren. Die Apache Hadoop-Architektur besteht aus verschiedenen Innovationen und Hadoop-Elementen, mit denen auch die komplizierten Informationsprobleme effektiv gelöst werden können.

Das Folgende ist die Darstellung jedes Teils:

1) Namenode: Er leitet den Informationsprozess

2) Datanode: Es setzt die Informationen zum lokalen Speicher zusammen. Es wird nicht empfohlen, alle Informationen an einem bestimmten Ort zu speichern, da dies bei einem Ausfall zu Informationsverlust führen kann.

3) Task Tracker: Sie erhalten dem Slave-Knoten zugewiesene Aufgaben

4) Map: Es werden Informationen aus einem Stream entnommen und jede Zeile wird aufgeteilt, um sie in verschiedene Felder aufzuteilen

5) Vermindern: Hier werden die über Map erfassten Felder gesammelt oder miteinander verknüpft

Apache Hadoop Ecosystem - Schritt für Schritt

Jedes Element des Hadoop-Ökosystems, da bestimmte Aspekte offensichtlich sind. Die umfassende Perspektive auf die Hadoop-Struktur bietet Hadoop Distributed File Systems (HDFS), Hadoop YARN, Hadoop MapReduce und Hadoop MapReduce aus dem Hadoop-Ökosystem eine bemerkenswerte Qualität. Hadoop bietet sogar jede Java-Bibliothek, signifikante Java-Datensätze, Reflexion auf Betriebssystemebene, Vorteile und Skripte für den Betrieb von Hadoop. Hadoop YARN ist eine Methode für Business Outlining und Bunch Resource Management. In der Hadoop-Konfiguration ermöglicht das HDFS die Weitergabe von Anwendungsinformationen mit hohem Durchsatz und Hadoop MapReduce die parallele Erstellung umfangreicher Datensortimente auf YARN-Basis.

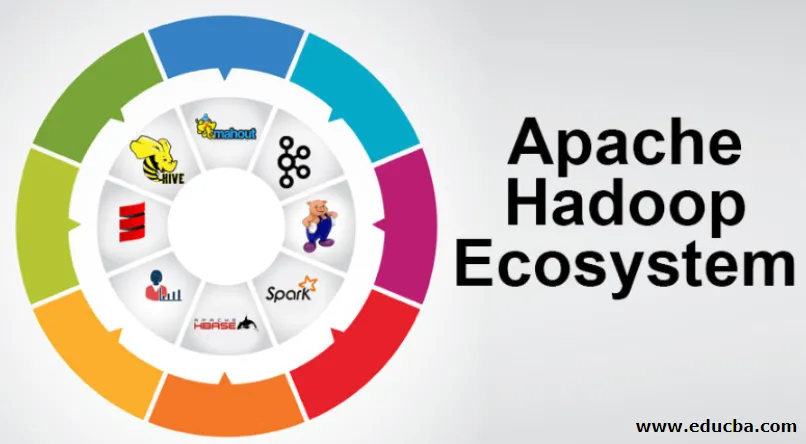

Überblick über das Apache Hadoop-Ökosystem

Es ist ein grundlegendes Thema, das Sie verstehen müssen, bevor Sie mit dem Hadoop-Ökosystem arbeiten. Nachfolgend sind die wesentlichen Komponenten aufgeführt:

- HDFS: Dies ist der zentrale Teil des Hadoop-Ökosystems und kann eine enorme Menge an unstrukturierten, strukturierten und halbstrukturierten Informationen speichern.

- YARN: Es ähnelt der Denkweise des Hadoop-Ökosystems, und die gesamte Verarbeitung wird direkt hier durchgeführt. Dies kann die Zuweisung von Ressourcen, die Planung von Jobs und die Vorbereitung von Aktionen umfassen.

- MapReduce: Es handelt sich um eine Mischung aus zwei Prozessen, die als Map und Reduce bezeichnet werden und im Wesentlichen Teile vorbereiten, aus denen riesige Informationssammlungen bestehen, die parallele und verteilte Algorithmen im Hadoop-Ökosystem verwenden.

- Apache Pig: Dies ist eine Verfahrenssprache, die für Anwendungen zur parallelen Verarbeitung von umfangreichen Informationssammlungen unter Hadoop-Bedingungen verwendet wird. Diese Sprache ist eine Option für die Java-Programmierung.

- HBase: Es ist eine Open-Source- und eine nicht assoziierte oder NoSQL-Datenbank. Es stärkt alle Informationstypen und kann somit mit jedem Informationstyp innerhalb eines Hadoop-Frameworks umgehen.

- Mahout, Spark MLib: Mahout wird für maschinelles Lernen verwendet und ermöglicht die Erstellung maschineller Lernanwendungen.

- Zookeeper: Um mit den Gruppen fertig zu werden, kann man den Zookeeper verwenden, der auch als "Lord of Coordination" bezeichnet wird und zuverlässige, schnelle und aussortierte Verwaltungsaufgaben für die Hadoop-Gruppen übernimmt.

- Oozie: Apache Oozie führt die Arbeitsplanung durch und fungiert als Alarm- und Uhrendienst innerhalb des Hadoop-Ökosystems.

- Ambari: Es ist ein Unternehmen der Apache Software Foundation und kann das Hadoop-Ökosystem schrittweise und flexibel ausführen.

Hadoop YARN:

Denken Sie an YARN als den Geist Ihres Hadoop-Ökosystems. Es spielt die Gesamtheit Ihrer Verarbeitungsvorgänge aus, indem es Assets und Planungsaufgaben zuweist.

Es hat zwei bemerkenswerte Segmente, ResourceManager und NodeManager.

- ResourceManager: - Es ist wieder ein wichtiger Knoten in der operativen Division. Es erhält die vorbereitenden Anfragen und leitet die Anfragen anschließend an die entsprechenden NodeManager weiter, in denen die eigentliche Bearbeitung stattfindet.

- NodeManager: - Diese werden auf jedem DataNode installiert. Es ist für die Ausführung eines Auftrags auf jedem einzelnen DataNode verantwortlich.

Wie funktioniert Apache Hadoop?

- Es ist vorgesehen, von einzelnen Servern auf eine große Anzahl von Computern aufzusteigen, von denen jeder eine lokale Berechnung und Kapazität bietet. Anstatt von der Ausstattung abhängig zu sein, die eine hohe Zugänglichkeit ermöglicht, soll die Bibliothek selbst Enttäuschungen auf der Anwendungsebene erkennen und behandeln, sodass über eine Reihe von PCs ein überaus zugänglicher Dienst bereitgestellt wird, von denen jeder zu Enttäuschungen neigt.

- Schauen Sie jedoch weiter und es gibt deutlich zunehmenden Reiz bei der Arbeit. Hadoop ist vollständig modular aufgebaut, was bedeutet, dass Sie praktisch jedes seiner Segmente gegen ein alternatives Softwaretool austauschen können. Das macht die Architektur fantastisch anpassungsfähig, ebenso leistungsfähig und effektiv.

Apache Hadoop Spark:

- Apache Spark ist ein System für die Echtzeit-Informationsanalyse in einer Umgebung mit verteilten Computern. Es implementiert speicherinterne Berechnungen, um die Geschwindigkeit der Informationsverarbeitung zu erhöhen.

- Es ist schneller für den Umgang mit umfangreichen Informationen, da es speicherinterne Berechnungen und verschiedene Verbesserungen verwendet. In diesem Sinne erfordert es eine hohe Verarbeitungskraft.

Wie funktioniert Apache Pig?

- Apache Pig ist ein nützliches System, das Yahoo entwickelt hat, um riesige Informationspositionen effektiv und reibungslos zu untersuchen. Es bietet eine Information-Stream-Sprache der obersten Ebene, Pig Latin, die erweitert, erweiterbar und einfach zu verwenden ist.

- Die außergewöhnliche Komponente von Pig-Programmen, in der ihre Zusammensetzung für eine umfassende Parallelisierung zur Verfügung steht, vereinfacht die Pflege umfangreicher Informationssammlungen.

Schwein-Anwendungsfall:

- Die privaten Gesundheitsinformationen einer Person sind privat und dürfen nicht an andere Personen weitergegeben werden. Diese Daten sollten zur Wahrung der Geheimhaltung verborgen werden, doch die Informationen zu Arzneimitteldiensten sind so umfangreich, dass das Erkennen und Ausschließen individueller Gesundheitsinformationen unerlässlich ist. Apache Pig kann unter solchen Bedingungen verwendet werden, um Gesundheitsdaten zu erkennen.

Fazit:

- Es ist vorgesehen, von nur einem Server auf eine große Anzahl von Computern aufzusteigen, die alle in der Nähe Berechnungen und Kapazitäten bereitstellen. Wenn Sie jedoch weiter schauen, wird die Verzauberung bei der Arbeit immer größer.

- Hadoop ist vollständig modular aufgebaut, was bedeutet, dass Sie praktisch jedes seiner Teile gegen ein alternatives Softwaretool austauschen können. Das macht die Struktur fantastisch anpassungsfähig, ebenso leistungsfähig und effektiv.

Empfohlene Artikel

Dies war ein Leitfaden für das Apache Hadoop-Ökosystem. Hier haben wir diskutiert, was ist Apache Hadoop Ecosystem? Überblick über die Hadoop-Architektur und die Funktionsweise des Hadoop-Ökosystems. Sie können auch unsere anderen Artikelvorschläge durchgehen, um mehr zu erfahren -

- Hadoop-Ökosystemkomponenten

- So installieren Sie Apache

- Apache Spark Training

- Karriere in Hadoop