Einführung in Hadoop Framework

Bevor wir uns eingehend mit den technischen Rahmenbedingungen von Hadoop befassen, werden wir mit einem einfachen Beispiel beginnen.

Es gibt eine Farm, in der Tomaten geerntet und in einem einzigen Lagerraum gelagert werden. Mit zunehmender Nachfrage nach Gemüse begann die Farm Kartoffeln und Karotten zu ernten - mit zunehmender Nachfrage gab es einen Mangel an Bauern, so dass sie mehr Bauern anstellten. Nach einiger Zeit stellten sie fest, dass es einen Mangel im Lagerraum gab - so verteilten sie das Gemüse auf verschiedene Lagerflächen. Beim Abrufen der Daten arbeiten alle parallel mit ihrem eigenen Speicherplatz.

Wie hängt diese Geschichte mit Big Data zusammen?

Früher hatten wir begrenzte Daten, mit dem begrenzten Prozessor und einer Speichereinheit. Aber dann nahm die Erzeugung von Daten zu, was zu einem hohen Volumen und unterschiedlichen Sorten führte - strukturiert, halbstrukturiert und unstrukturiert. Die Lösung bestand darin, für jeden Prozessor einen verteilten Speicher zu verwenden, wodurch ein einfacher Zugriff auf die Speicherung und den Zugriff auf Daten ermöglicht wurde.

So können wir jetzt das Gemüse als verschiedene Arten von Daten und Speicherorten als verteilte Orte zum Speichern der Daten und verschiedene Arbeiter, die jeder Verarbeiter ist, ersetzen.

Big Data ist also die Herausforderung und Hadoop spielt die Rolle der Lösung.

HADOOP

1. Lösung für BIG DATA: Bewältigt die Komplexität von hohem Datenvolumen, Geschwindigkeit und Datenvielfalt.

2. Set des Open-Source-Projekts.

3. Speichert eine große Datenmenge zuverlässig und ermöglicht große verteilte Berechnungen.

4. Die Hauptmerkmale von Hadoop sind Redundanz und Zuverlässigkeit (absolut kein Datenverlust).

5. Konzentriert sich hauptsächlich auf die Stapelverarbeitung.

6. Läuft auf Standardhardware - Sie müssen keine teure Spezialhardware kaufen.

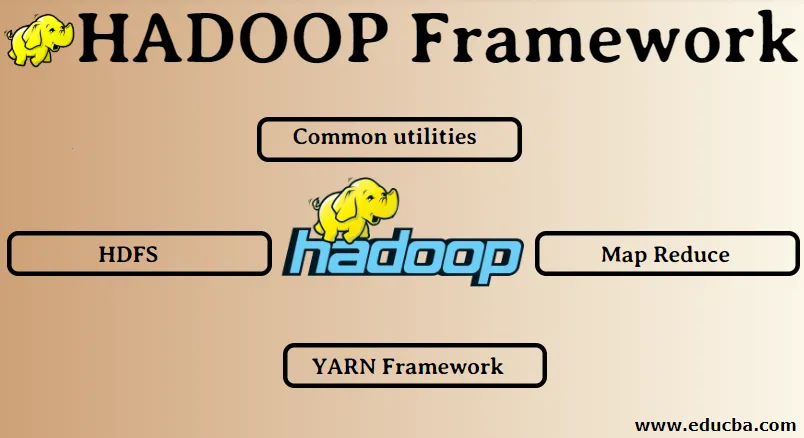

Hadoop Framework:

1. Gemeinsame Dienstprogramme

2. HDFS

3. Karte verkleinern

4. YARN Framework

1. Gemeinsame Dienstprogramme:

Wird auch als Hadoop-Common bezeichnet. Hierbei handelt es sich lediglich um die JAVA-Bibliotheken, -Dateien, -Skripts und -Dienstprogramme, die für die Ausführung der anderen Hadoop-Komponenten tatsächlich erforderlich sind.

2. HDFS: Hadoop Distributed File System

Warum hat sich Hadoop für ein verteiltes Dateisystem entschieden?

Verstehen wir dies anhand eines Beispiels: Wir müssen 1 TB Daten lesen und wir haben eine Maschine mit 4 E / A-Kanälen pro Kanal mit 100 MB / s. Das Lesen der gesamten Daten dauerte 45 Minuten. Jetzt wird die gleiche Datenmenge von 10 Maschinen mit jeweils 4 E / A-Kanälen mit jeweils 100 MB / s gelesen. Wie lange hat das Lesen der Daten gedauert? 4, 3 Minuten. HDFS löst das Problem der Speicherung von Big Data. Die beiden Hauptkomponenten von HDFS sind NAME NODE und DATA NODE. Der Namensknoten ist der Master, wir haben möglicherweise auch einen sekundären Namensknoten, falls der primäre Namensknoten nicht mehr funktioniert, fungiert der sekundäre Namensknoten als Sicherung. Der Namensknoten verwaltet und verwaltet die Datenknoten im Wesentlichen durch Speichern von Metadaten. Der Datenknoten ist der Slave, der im Grunde die kostengünstige Standardhardware ist. Wir können mehrere Datenknoten haben. Der Datenknoten speichert die tatsächlichen Daten. Dieser Datenknoten unterstützt den Replikationsfaktor. Wenn ein Datenknoten ausfällt, kann der andere replizierte Datenknoten auf die Daten zugreifen. Dadurch wird die Zugänglichkeit der Daten verbessert und ein Datenverlust verhindert.

3. Kartenverkleinerung:

Es löst das Problem der Verarbeitung von Big Data. Lassen Sie uns das Konzept der Kartenreduzierung verstehen, indem Sie dieses reale Problem lösen. ABC will den Gesamtumsatz stadtbezogen berechnen. Hier funktioniert das Hash-Tabellen-Konzept nicht, da die Daten in Terabyte vorliegen. Daher verwenden wir das Map-Reduce-Konzept.

Es gibt zwei Phasen: a) MAP. b) REDUZIEREN

a) Map : Zuerst werden wir die Daten auf der Grundlage des Schlüssel / Wert-Paares in kleinere Abschnitte aufteilen, die als Mapper bezeichnet werden. Der Schlüssel ist hier also der Name der Stadt und der Wert ist der Gesamtumsatz. Jeder Mapper erhält die monatlichen Daten, die einen Städtenamen und die entsprechenden Verkäufe enthalten.

b) Reduzieren: Diese Datenmengen werden abgerufen, und jeder Reduzierer ist für die Städte Nord / West / Ost / Süd verantwortlich. Die Arbeit des Reduzierers wird also darin bestehen, diese kleinen Stücke zu sammeln und in größere Mengen (durch Addition) für eine bestimmte Stadt umzuwandeln.

4. YARN Framework: Ein weiterer Verhandlungspartner für Ressourcen.

Die ursprüngliche Version von Hadoop hatte nur zwei Komponenten: Map Reduce und HDFS. Später stellte sich heraus, dass Map Reduce viele Big-Data-Probleme nicht lösen konnte. Die Idee war, die Ressource-Management- und Job-Scheduling-Verantwortlichkeiten von der alten Map-Reduction-Engine abzunehmen und sie einer neuen Komponente zu übergeben. So kam YARN ins Bild. Es ist die mittlere Ebene zwischen HDFS und Map Reduce, die für die Verwaltung der Clusterressourcen zuständig ist.

Es hat zwei Schlüsselrollen zu erfüllen: a) Job Scheduling. b) Ressourcenverwaltung

a) Auftragsplanung: Wenn eine große Datenmenge für die Verarbeitung bereitgestellt wird, muss sie verteilt und in verschiedene Aufgaben / Aufträge unterteilt werden. Jetzt entscheidet der JS, welchem Job die höchste Priorität zugewiesen werden muss. Das Zeitintervall zwischen zwei Jobs, die Abhängigkeit zwischen den Jobs, überprüft, ob es keine Überlappungen zwischen den ausgeführten Jobs gibt.

b) Ressourcenmanagement: Zum Verarbeiten der Daten und zum Speichern der Daten benötigen wir Ressourcen oder? Der Ressourcenmanager stellt also die Ressourcen zum Speichern und Verarbeiten der Daten bereit, verwaltet sie und verwaltet sie.

Jetzt ist klar, was Hadoop bedeutet und wie es die Herausforderungen der BIG DATA löst !!!

Empfohlene Artikel

Dies war ein Leitfaden für Hadoop Framework. Hier haben wir auch die Top 4 Hadoop Frameworks besprochen. Sie können auch unsere anderen Artikelvorschläge durchgehen, um mehr zu erfahren -

- Hadoop-Datenbank

- Hadoop-Ökosystem

- Verwendung von Hadoop

- Hadoop Administrator Jobs

- Hadoop Administrator | Fähigkeiten & Karriereweg