Was ist Hadoop?

Fünf Metriken von Hadoop sind Volumen, Vielfalt, Geschwindigkeit, Wahrhaftigkeit und Wert. Daten nehmen rasant zu und liegen in einem strukturierten, unstrukturierten und halbstrukturierten Format vor. Die Daten nehmen mit hoher Geschwindigkeit zu, und wir sollten uns einen aussagekräftigen Einblick in die Daten verschaffen. Daten müssen einen gewissen Wert haben, aber es gibt einige Inkonsistenzen und Unsicherheiten in den Daten. Herkömmliche Systeme, die Daten speichern, sind aufgrund des Speicherplatzes nicht in der Lage, diese schnell wachsenden Daten zu speichern. Das herkömmliche System ist nicht in der Lage, Daten zu verarbeiten, da es eine komplexe Datenstruktur aufweist und die Verarbeitung der Daten sehr viel Zeit in Anspruch nimmt. Hadoop würde das Problem des traditionellen Datenbanksystems lösen. Hadoop ist ein Framework, das eine große Datenmenge parallel verarbeitet und in einer verteilten Umgebung speichert. Hadoop besteht aus zwei Komponenten: 1) HDFS (Daten in einem Cluster speichern) 2) MapReduce (Daten parallel verarbeiten). HDFS speichert Daten in Form verschiedener Blöcke. Die Standardblockgröße beträgt 128 MB.

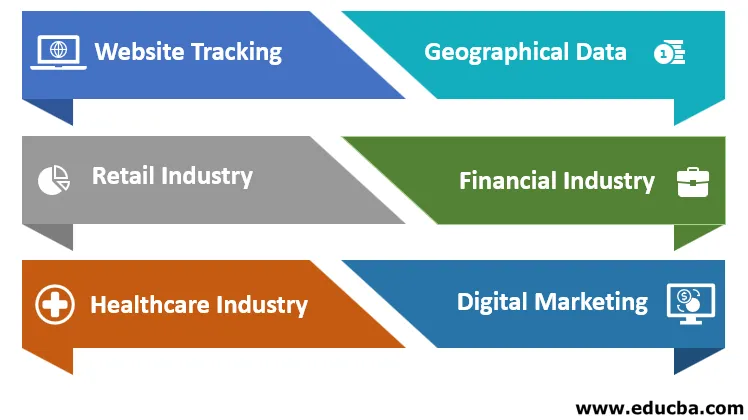

Anwendungen von Hadoop

Die Anwendungen von Hadoop werden nachfolgend erläutert:

ein. Website-Tracking

Angenommen, Sie haben eine Website erstellt und möchten Informationen zu den Besuchern erhalten. Hadoop wird eine riesige Menge an Daten darüber erfassen. Es gibt Auskunft über den Standort des Besuchers, welchen Seitenbesucher er zuerst und am meisten besucht hat, wie viel Zeit er auf der Website verbracht hat und auf welcher Seite, wie oft ein Besucher die Seite besucht hat, worüber sich der Besucher am meisten freut. Dies wird eine vorhersagende Analyse des Interesses der Besucher liefern. Hadoop akzeptiert Daten in mehreren Formaten aus mehreren Quellen. Mit Apache HIVE werden Millionen von Daten verarbeitet.

b. Geografische Daten

Wenn wir Produkte von einer E-Commerce-Website kaufen. Die Website verfolgt den Standort des Benutzers und prognostiziert Kundeneinkäufe mit Smartphones und Tablets. Der Hadoop-Cluster hilft dabei, das Geschäft an geografischen Standorten zu ermitteln. Dies wird den Branchen helfen, das Geschäftsdiagramm in jedem Bereich (positiv oder negativ) anzuzeigen.

c. Einzelhandelsindustrie

Einzelhändler verwenden Daten von Kunden, die im strukturierten und unstrukturierten Format vorliegen, um die Daten zu verstehen und zu analysieren. Dies hilft einem Benutzer, die Kundenanforderungen zu verstehen und sie mit besseren Vorteilen und verbesserten Dienstleistungen zu bedienen.

d. Finanzindustrie

Finanzbranche und Finanzunternehmen bewerten das finanzielle Risiko, den Marktwert und erstellen ein Modell, mit dem Kunden und Industrie bessere Ergebnisse in Bezug auf Investitionen wie Aktienmarkt, FD usw. erzielen können. Verstehen Sie den Handelsalgorithmus. Hadoop wird das Build-Modell ausführen.

e. Gesundheitsindustrie

Hadoop kann große Datenmengen speichern. Medizinische Daten liegen in einem unstrukturierten Format vor. Dies hilft dem Arzt bei einer besseren Diagnose. Hadoop speichert eine Patientenanamnese von mehr als 1 Jahr und analysiert die Krankheitssymptome.

f. Digitales Marketing

Wir befinden uns in der Ära der 20er Jahre, jeder einzelne Mensch ist digital verbunden. Informationen werden über Mobiltelefone oder Laptops an den Benutzer weitergeleitet, und die Menschen werden auf jedes Detail in Bezug auf Nachrichten, Produkte usw. aufmerksam. Hadoop speichert online generierte Daten, speichert, analysiert und liefert die Ergebnisse an die digitalen Marketingunternehmen.

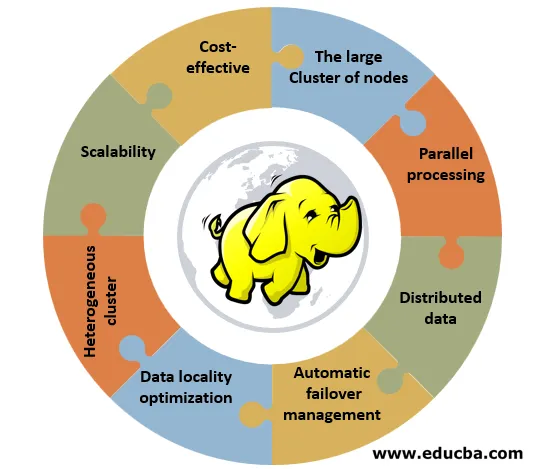

Funktionen von Hadoop

Im Folgenden sind die Funktionen von Hadoop aufgeführt:

1. Kostengünstig: Für die Implementierung von Hadoop ist keine spezielle oder effektive Hardware erforderlich. Es kann auf einfacher Hardware implementiert werden, die als Community-Hardware bezeichnet wird.

2. Der große Cluster von Knoten: Ein Cluster kann aus 100 oder 1000 Knoten bestehen. Der Vorteil eines großen Clusters besteht darin, dass er den Kunden mehr Rechenleistung und ein riesiges Speichersystem bietet.

3. Parallelverarbeitung: Daten können in allen Clustern gleichzeitig verarbeitet werden, was viel Zeit spart. Das traditionelle System war nicht in der Lage, diese Aufgabe zu erledigen.

4. Verteilte Daten: Das Hadoop-Framework sorgt für die Aufteilung und Verteilung der Daten auf alle Knoten innerhalb eines Clusters. Es repliziert Daten über alle Cluster. Der Replikationsfaktor ist 3.

5. Automatisches Failover-Management: Wenn einer der Knoten in einem Cluster ausfällt, ersetzt das Hadoop-Framework die fehlerhafte Maschine durch eine neue Maschine. Die Replikationseinstellungen des alten Computers werden automatisch auf den neuen Computer übertragen. Der Administrator muss sich keine Sorgen machen.

6. Datenlokalitätsoptimierung: Angenommen, der Programmierer benötigt Daten eines Knotens aus einer Datenbank, die sich an einer anderen Stelle befindet, und der Programmierer sendet ein Byte Code an die Datenbank. Das spart Bandbreite und Zeit.

7. Heterogener Cluster: Es gibt einen unterschiedlichen Knoten, der unterschiedliche Maschinen mit unterschiedlichen Versionen unterstützt. IBM unterstützt Red Hat Linux.

8. Skalierbarkeit: Hinzufügen oder Entfernen von Knoten und Hinzufügen oder Entfernen von Hardwarekomponenten zum oder vom Cluster. Wir können diese Aufgabe ausführen, ohne den Clusterbetrieb zu stören. RAM oder Festplatte können dem Cluster hinzugefügt oder daraus entfernt werden.

Vorteile von Hadoop

Die Vorteile von Hadoop werden nachfolgend erläutert:

- Hadoop kann große Datenmengen verarbeiten und die Daten basierend auf den Datenanforderungen skalieren. Jetzt sind die Daten eines Tages in 1 bis 100 Tera-Bytes vorhanden.

- Es wird ein riesiges Datenvolumen ohne große Herausforderungen skalieren. Nehmen wir ein Beispiel für Facebook - Millionen von Menschen verbinden sich, tauschen Gedanken, Kommentare usw. aus. Es kann Software- und Hardwarefehler reibungslos behandeln.

- Wenn ein System ausfällt, gehen keine Daten oder Informationen verloren, da der Replikationsfaktor 3 beträgt. Die Daten werden dreimal kopiert, und Hadoop verschiebt Daten von einem System auf ein anderes. Es kann mit verschiedenen Datentypen wie strukturierten, unstrukturierten oder halbstrukturierten Daten umgehen.

- Strukturieren Sie Daten wie eine Tabelle (wir können leicht Zeilen- oder Spaltenwerte abrufen), unstrukturierte Daten wie Videos und Fotos und halbstrukturierte Daten wie eine Kombination aus strukturierten und halbstrukturierten Daten.

- Die Kosten für die Implementierung von Hadoop mit dem BigData-Projekt sind gering, da Unternehmen Speicher- und Verarbeitungsservices von Cloud-Service-Providern erwerben, da die Kosten für die Speicherung pro Byte niedrig sind.

- Es bietet Flexibilität bei der Wertschöpfung aus den Daten wie strukturiert und unstrukturiert. Wir können wertvolle Daten aus Datenquellen wie Social Media, Unterhaltungskanälen und Einkaufswebsites ableiten.

- Hadoop kann Daten mit CSV-Dateien, XML-Dateien usw. verarbeiten. Die Daten werden parallel in der Distributionsumgebung verarbeitet. Wir können die Daten zuordnen, wenn sie sich im Cluster befinden. Server und Daten befinden sich am selben Ort, sodass die Daten schneller verarbeitet werden können.

- Wenn wir eine große Menge unstrukturierter Daten haben, können wir innerhalb einer Minute Terabyte an Daten verarbeiten. Entwickler können für Hadoop mit verschiedenen Programmiersprachen wie Python, C, C ++ programmieren. Es ist eine Open-Source-Technologie. Der Quellcode ist einfach online verfügbar. Wenn die Datenmenge von Tag zu Tag zunimmt, können wir dem Cluster Knoten hinzufügen. Es müssen keine weiteren Cluster hinzugefügt werden. Jeder Knoten führt seine Arbeit aus, indem er seine eigenen Ressourcen verwendet.

Fazit

Hadoop kann große Datenmengen berechnen. Um dies zu verarbeiten, hat Google einen Map-Reduce-Algorithmus entwickelt, den Hadoop ausführen wird. Dies wird eine wichtige Rolle bei der statistischen Analyse, Business Intelligence und ETL-Verarbeitung spielen. Einfach zu bedienen und kostengünstiger erhältlich. Es kann Daten in Tera-Bytes verarbeiten, analysieren und ohne Informationsverlust Datenwerte bereitstellen.

Empfohlene Artikel

Dies ist eine Anleitung zu What is Hadoop ?. Hier diskutieren wir die Anwendung von Hadoop und Funktionen zusammen mit den Vorteilen. Sie können auch unsere anderen Artikelvorschläge durchgehen, um mehr zu erfahren.

- Clustering-Methoden

- IoT-Software

- Hadoop FS Befehlsliste

- Vorteile von Hadoop

- Wie funktionieren Kommentare in PHP?