Unterschied zwischen Kleine Daten und große Daten

Kleine Daten sind nichts anderes als die Daten, die für den Menschen in einem Volumen und auch für die Formatierung ausreichend klein sind, sodass sie zugänglich, informativ und umsetzbar sind. Die herkömmliche Datenverarbeitung kann keine großen oder komplexen Daten verarbeiten. Diese Daten werden als Big Data bezeichnet. Wenn das Datenvolumen eine bestimmte Grenze überschreitet, reichen herkömmliche Systeme und Methoden nicht aus, um Daten zu verarbeiten oder in ein nützliches Format umzuwandeln. Aus diesem Grund werden Daten im Allgemeinen in zwei Kategorien eingeteilt: Kleine Daten und große Daten

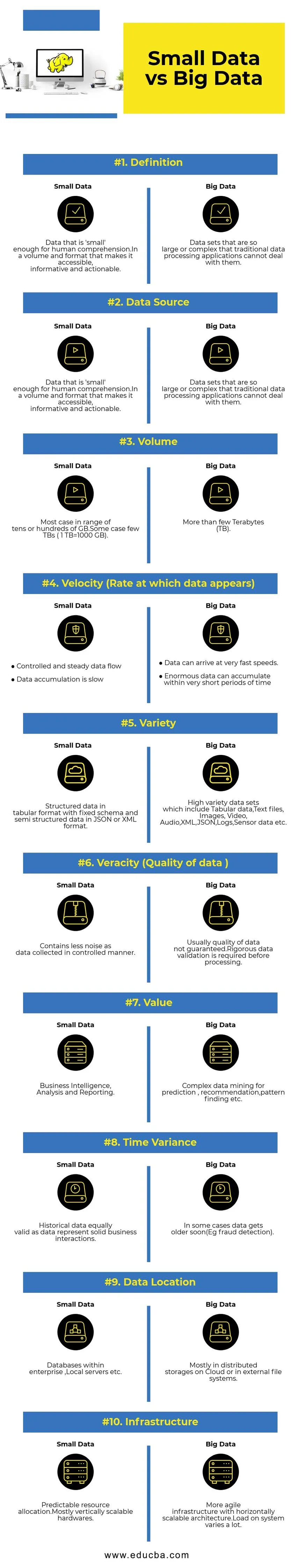

Head to Head Vergleich zwischen Small Data und Big Data (Infografiken)

Nachfolgend finden Sie die 10 wichtigsten Unterschiede zwischen kleinen und großen Datenmengen

Hauptunterschiede zwischen kleinen und großen Datenmengen

- Datenerfassung - Normalerweise sind kleine Daten Teil von OLTP-Systemen und werden kontrollierter erfasst als in die Caching-Ebene oder Datenbank eingefügt. Datenbanken verfügen über Lesereplikate, um bei Bedarf sofortige Analyseabfragen zu unterstützen. Die Big Data-Erfassungspipeline wird Warteschlangen wie AWS Kinesis oder Google Pub / Sub haben, um Hochgeschwindigkeitsdaten auszugleichen. Downstream verfügt über Streaming-Pipelines für Echtzeitanalysen und Batch-Jobs für die Verarbeitung kalter Daten.

- Datenverarbeitung - Da die meisten kleinen Daten über das Transaktionssystem generiert werden, erfolgt die Analyse die meiste Zeit stapelweise. In einigen seltenen Fällen werden Analytics-Abfragen direkt auf Transaktionssystemen ausgeführt. Big Data-Umgebungen verfügen über Batch- und Stream-Verarbeitungs-Pipelines. Ein Stream wird für Echtzeitanalysen wie die Erkennung von Kreditkartenbetrug oder die Vorhersage von Aktienkursen verwendet. Stapelverarbeitung zur Implementierung komplexer Geschäftslogik mit Daten und erweiterten Algorithmen.

- Skalierbarkeit - Small Data-Systeme werden normalerweise vertikal skaliert. Durch die vertikale Skalierung wird die Systemkapazität erhöht, indem mehr Ressourcen zur gleichen Maschine hinzugefügt werden. Vertikale Skalierung ist teuer, aber weniger komplex in der Verwaltung. Big-Data-Systeme hängen meist von einer horizontal skalierbaren Architektur ab, die mehr Flexibilität bei geringeren Kosten bietet. In der Cloud verfügbare virtuelle Maschinen machen horizontal skalierbare Systeme noch erschwinglicher.

- Datenmodellierung - Kleine Daten, die aus Transaktionssystemen generiert werden, liegen in normalisierter Form vor. ETL-Datenpipelines (Extract Transform Load) konvertieren sie in ein Stern- oder Schneeflockenschema in einem Data Warehouse. Hier wird das Schema beim Schreiben von Daten immer erzwungen, was relativ einfach ist, da die Daten strukturierter sind. Wie oben erwähnt, machen Tabellendaten nur einen Bruchteil von Big Data aus. Hier werden Daten aus verschiedenen Gründen, z. B. aus Gründen der Übergabe von Fehlern oder aufgrund einer Einschränkung des zugrunde liegenden Datenbankmoduls, viel häufiger repliziert (z. B. unterstützen einige Datenbanken nur einen sekundären Index pro Datensatz). Beim Schreiben wird kein Schema erzwungen. Stattdessen wird ein Schema beim Lesen von Daten überprüft.

- Storage & Computation Coupling - In traditionellen Datenbanken, die hauptsächlich kleine Datenmengen verarbeiten, sind Storage und Computing eng miteinander verbunden. Das Einfügen und Abrufen von Daten in und aus der Datenbank ist nur über die angegebene Schnittstelle möglich. Daten können nicht direkt in das Datenbank-Dateisystem gestellt werden, oder vorhandene Daten können nicht mit anderen DB-Engines abgefragt werden. Tatsächlich trägt diese Architektur wesentlich zur Gewährleistung der Datenintegrität bei. Big Data-Systeme haben eine sehr lose Kopplung zwischen Speicher und Computer. In der Regel werden Daten in einem verteilten Datenspeichersystem wie HDFS, AWS S3 oder Google GCS gespeichert und mit der Compute Engine abgefragt oder ETL zu einem späteren Zeitpunkt ausgewählt. Beispielsweise können interaktive Abfragen mithilfe von Presto (Link) und ETL mithilfe von Apache Hive mit denselben Daten ausgeführt werden.

- Data Science - Algorithmen für maschinelles Lernen erfordern Eingabedaten in einem gut strukturierten und ordnungsgemäß codierten Format. Die meisten Eingabedaten stammen von Transaktionssystemen wie einem Data Warehouse und der Speicherung von Big Data wie einem Data Lake. Algorithmen für maschinelles Lernen, die nur mit kleinen Daten ausgeführt werden, sind einfach, da die Datenvorbereitungsphase eng ist. Das Vorbereiten und Anreichern von Daten in der Big Data-Umgebung nimmt viel mehr Zeit in Anspruch. Big Data bietet aufgrund des großen Datenvolumens und der großen Datenvielfalt viele Möglichkeiten für datenwissenschaftliche Experimente.

- Datensicherheit - Sicherheitspraktiken für kleine Daten, die sich auf Enterprise Data Warehouse- oder Transaktionssystemen befinden, die von entsprechenden Datenbankanbietern bereitgestellt werden und möglicherweise Benutzerrechte, Datenverschlüsselung, Hashing usw. enthalten. Das Sichern von Big Data-Systemen ist viel komplizierter und herausfordernder. Zu den bewährten Sicherheitsmethoden gehört das Verschlüsseln von Daten im Ruhezustand und bei der Übertragung, das Isolieren des Clusternetzwerks, strenge Zugriffssteuerungsregeln usw.

Vergleichstabelle zwischen kleinen und großen Daten

| Vergleichsbasis | Kleine Daten | Große Daten |

| Definition | Daten, die für das menschliche Verständnis "klein" genug sind. In einem Volumen und Format, das sie zugänglich, informativ und umsetzbar macht | Datenmengen, die so groß oder komplex sind, dass herkömmliche Datenverarbeitungsanwendungen sie nicht verarbeiten können |

| Datenquelle | ● Daten aus herkömmlichen Unternehmenssystemen wie ○ Unternehmensressourcenplanung ○ Kundenbeziehungsmanagement (CRM) ● Finanzdaten wie Hauptbuchdaten ● Zahlungsverkehrsdaten von der Website | ● Kaufdaten von der Verkaufsstelle ● Clickstream-Daten von Websites ● GPS-Stream-Daten - Mobilitätsdaten, die an einen Server gesendet werden ● Soziale Medien - Facebook, Twitter |

| Volumen | Die meisten Fälle in einem Bereich von zehn oder Hunderten von GB. Einige wenige TBs (1 TB = 1000 GB) | Mehr als ein paar Terabyte (TB) |

| Geschwindigkeit (Rate, mit der Daten angezeigt werden) | ● Kontrollierter und stetiger Datenfluss ● Die Datenakkumulation ist langsam | ● Daten können sehr schnell ankommen. ● Innerhalb kürzester Zeit können sich enorme Datenmengen ansammeln |

| Vielfalt | Strukturierte Daten im Tabellenformat mit festem Schema und halbstrukturierten Daten im JSON- oder XML-Format | Hochwertige Datensätze, einschließlich Tabellendaten, Textdateien, Bilder, Video, Audio, XML, JSON, Protokolle, Sensordaten usw. |

| Richtigkeit (Qualität der Daten) | Enthält weniger Rauschen als Daten, die auf kontrollierte Weise erfasst werden. | In der Regel kann die Datenqualität nicht garantiert werden. Vor der Verarbeitung ist eine strenge Datenüberprüfung erforderlich. |

| Wert | Business Intelligence, Analyse und Berichterstellung | Komplexes Data Mining für Vorhersage, Empfehlung, Mustersuche usw. |

| Zeitabweichung | Historische Daten, die ebenso gültig sind wie Daten, repräsentieren solide Geschäftsinteraktionen | In einigen Fällen werden Daten bald älter (z. B. Betrugserkennung). |

| Datenposition | Datenbanken innerhalb eines Unternehmens, lokale Server usw. | Meist in verteilten Speichern in der Cloud oder in externen Dateisystemen. |

| Infrastruktur | Vorhersehbare Ressourcenzuweisung. Hauptsächlich vertikal skalierbare Hardware | Agilere Infrastruktur mit horizontal skalierbarer Architektur. Die Belastung des Systems ist sehr unterschiedlich. |

Fazit - Kleine Daten versus große Daten

Das ultimative Ziel für die Datenanalyse ist es, zeitnahe Einblicke zu erhalten, um die Entscheidungsfindung zu unterstützen. Das Kategorisieren von Daten in "Klein" und "Groß" hilft dabei, die Herausforderungen bei der Analyse der Daten jeder Welt separat mit geeigneten Tools zu bewältigen. Die Grenze zwischen zwei Kategorien variiert je nach neuem, fortschrittlichem Datenverarbeitungssystem, wodurch selbst Abfragen von großen Datenmengen viel schneller und weniger komplex werden.

Empfohlene Artikel:

Dies war ein Leitfaden für Small Data vs Big Data, deren Bedeutung, Kopf-an-Kopf-Vergleich, Hauptunterschiede, Vergleichstabelle und Schlussfolgerung. Dieser Artikel enthält alle wichtigen Unterschiede zwischen Small Data und Big Data. Sie können sich auch die folgenden Artikel ansehen, um mehr zu erfahren -

- Big Data vs Data Science - Wie unterscheiden sie sich?

- Big Data: Wichtig für den Zusammenfluss von Technologie und Geschäftsanalyse

- Top 5 Big Data-Trends, die Unternehmen meistern müssen

- 16 Interessante Tipps, um Big Data zu großem Erfolg zu machen