Unterschiede zwischen Spark SQL und Presto

Presto ist in einfachen Worten 'SQL Query Engine', ursprünglich für Apache Hadoop entwickelt. Es handelt sich um eine Open-Source-Abfrage-Engine für verteiltes SQL, mit der interaktive analytische Abfragen für Datensätze aller Größen ausgeführt werden können.

Spark SQL ist eine verteilte In-Memory-Berechnungsengine mit einer SQL-Schicht auf strukturierten und halbstrukturierten Datensätzen. Seit seiner In-Memory-Verarbeitung ist die Verarbeitung in Spark SQL schnell.

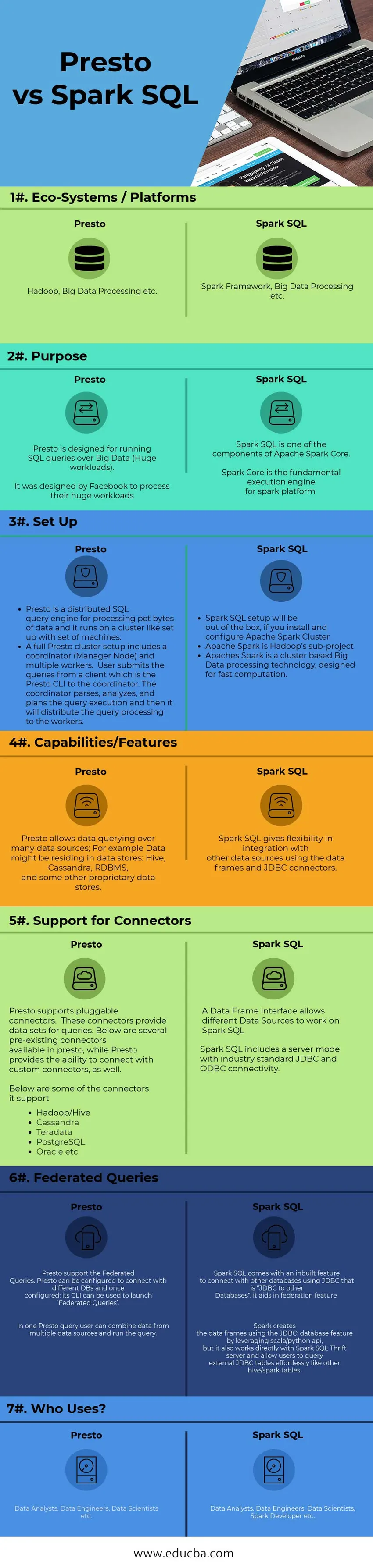

Head to Head Vergleich zwischen Spark SQL und Presto (Infographics)

Nachfolgend finden Sie die Top 7-Vergleiche zwischen Spark SQL und Presto

Hauptunterschiede zwischen Spark SQL und Presto

Nachfolgend finden Sie eine Liste mit den wichtigsten Unterschieden zwischen Presto und Spark SQL

- Apache Spark führt ein Programmiermodul für die Verarbeitung strukturierter Daten mit dem Namen Spark SQL ein. Spark SQL enthält eine Codierungsabstraktion namens Data Frame, die als verteiltes SQL-Abfragemodul fungieren kann.

- Das Motiv für den Beginn von Presto bestand darin, interaktive Analysen und Ansätze für die Geschwindigkeit kommerzieller Data Warehouses zu ermöglichen, mit denen die Größe von Organisationen skaliert werden kann, die mit Facebook übereinstimmen.

- Während Spark SQL eine Komponente auf Spark Core ist, die eine neue Datenabstraktion namens SchemaRDD (Resilient Distributed Datasets) einführt, bietet es Unterstützung für strukturierte / semistrukturierte Daten.

- Presto wurde als Alternative zu Tools entwickelt, die HDFS-Daten mithilfe von MapReduce-Jobs wie Hive oder Pig abfragen. Presto ist jedoch nicht auf HDFS beschränkt.

- Spark SQL folgt der In-Memory-Verarbeitung, wodurch die Verarbeitungsgeschwindigkeit erhöht wird. Spark wurde entwickelt, um eine breite Palette von Workloads wie Stapelabfragen, iterative Algorithmen, interaktive Abfragen, Streaming usw. zu verarbeiten.

- Presto kann föderative Abfragen ausführen. Unten sehen Sie das Beispiel für Presto Federated Queries

Nehmen wir ein beliebiges RDBMS mit der Tabelle sample1 an

Und HIVE mit Tabelle sample2,

'Testdb' ist die Datenbank in Hive und MYSQL. Mit Presto können wir Daten in einer einzigen Abfrage auswerten, sobald die Konnektoren wie unten gezeigt korrekt konfiguriert sind.

presto> hive.Testdb.sample2

Funktion (Auswahl / Gruppieren nach … usw.)> mysql.Testdb.sample1

- Die Spark-SQL-Architektur besteht aus Spark-SQL, Schema-RDD und Datenrahmen

- Ein Datenrahmen ist eine Sammlung von Daten. Die Daten sind in benannten Spalten organisiert. Technisch ist es dasselbe wie relationale Datenbanktabellen.

- Schema RDD: Spark Core enthält eine spezielle Datenstruktur namens RDD. Spark SQL funktioniert mit Schemas, Tabellen und Datensätzen. Daher kann ein Benutzer die Schema-RDD als temporäre Tabelle verwenden. Damit der Benutzer diese Schema-RDD als Datenrahmen aufrufen kann

- Datenrahmenfähigkeiten: Datenrahmen verarbeiten die Daten in der Größe von Kilobyte bis Petabyte auf einem einzelnen Knotencluster zu mehreren Knotenclustern.

- Data Frame unterstützt verschiedene Datenformate (CSV, Elasticsearch, Cassandra usw.) und Speichersysteme (HDFS, HIVE-Tabellen, MySQL usw.). Es kann über Spark-Core in alle Big Data-Tools / Frameworks integriert werden und bietet API für Sprachen wie Python-, Java-, Scala- und R-Programmierung.

- Während Presto eine verteilte Engine ist, arbeitet sie an einem Cluster-Setup. Die Presto-Architektur ist einfach zu verstehen und erweiterbar. Presto Client (CLI) sendet SQL-Anweisungen an einen Master-Daemon-Koordinator, der die Verarbeitung verwaltet.

- Unternehmen, die Presto nutzen: Facebook, Netflix, Airbnd, Dropbox usw.

- Apache Spark Use Cases finden sich in Branchen wie Finanzen, Einzelhandel, Gesundheitswesen und Reisen usw. Viele E-Commerce-Websites wie eBay, Alibaba und Pinterest verwenden Spark SQL, um Hunderte von Petabytes an Daten auf ihrer E-Commerce-Plattform zu analysieren.

Vergleichstabelle Spark SQL vs Presto

Unten sehen Sie den höchsten Vergleich zwischen SQL und Presto

| Vergleichsbasis zwischen SQL und Presto | Presto | Spark SQL |

| Ökosysteme / Plattformen | Hadoop, Big Data Processing usw | Spark Framework, Big Data Processing usw |

| Zweck | Presto wurde für die Ausführung von SQL-Abfragen über Big Data (enorme Workloads) entwickelt. Es wurde von Facebook entwickelt, um ihre enormen Arbeitslasten zu verarbeiten. | Spark SQL ist eine der Komponenten von Apache Spark Core. Spark Core ist die grundlegende Ausführungsmaschine für die Spark-Plattform |

| Installieren |

|

|

| Funktionen / Features | Mit Presto können Daten über viele Datenquellen abgefragt werden. Beispielsweise befinden sich Daten möglicherweise in Datenspeichern: Hive, Cassandra, RDBMS und einige andere proprietäre Datenspeicher. | Spark SQL bietet Flexibilität bei der Integration in andere Datenquellen mithilfe von Datenrahmen und JDBC-Konnektoren. |

| Unterstützung für Connectors | Presto unterstützt steckbare Steckverbinder. Diese Connectors stellen Datensätze für Abfragen bereit.

Im Folgenden sind einige bereits vorhandene Konnektoren aufgeführt, die in presto verfügbar sind, während Presto auch die Möglichkeit bietet, eine Verbindung mit benutzerdefinierten Konnektoren herzustellen.

| Über eine Datenrahmenschnittstelle können verschiedene Datenquellen in Spark SQL verwendet werden. Spark SQL enthält einen Servermodus mit JDBC- und ODBC-Konnektivität nach Industriestandard. |

| Föderierte Abfragen | Presto unterstützt die Verbundabfragen. Presto kann so konfiguriert werden, dass eine Verbindung mit verschiedenen DBs hergestellt und einmal konfiguriert wird. Über die CLI können "Verbundabfragen" gestartet werden. In einer Presto-Abfrage kann der Benutzer Daten aus mehreren Datenquellen kombinieren und die Abfrage ausführen. | Spark SQL verfügt über eine integrierte Funktion zum Herstellen einer Verbindung mit anderen Datenbanken mithilfe von JDBC, die als "JDBC für andere Datenbanken" bezeichnet wird. Sie unterstützt die Verbundfunktion. Spark erstellt die Datenrahmen mithilfe der JDBC: -Datenbankfunktion, indem es die Scala / Python-API nutzt. Es funktioniert jedoch auch direkt mit dem Spark SQL Thrift-Server und ermöglicht Benutzern das mühelose Abfragen externer JDBC-Tabellen wie bei anderen Hive / Spark-Tabellen. |

| Wer benutzt? | Datenanalysten, Dateningenieure, Datenwissenschaftler usw | Datenanalysten, Dateningenieure, Datenwissenschaftler, Spark - Entwickler usw |

Schlussfolgerungen - Park SQL vs Presto

Spark SQL und Presto sind verteilte SQL-Engines, die auf dem Markt erhältlich sind.

Presto ist sehr hilfreich, wenn es um BI-Abfragen geht, und Spark SQL ist in Bezug auf die Leistung bei umfangreichen Analyse-Abfragen führend. Im Vergleich zur Konfiguration ist Presto einfacher einzurichten als Spark SQL. Sowohl Spark SQL als auch Presto sind auf einem Markt gleichberechtigt und lösen unterschiedliche Geschäftsprobleme.

Empfohlener Artikel

Dies war ein Leitfaden für Spark SQL vs Presto, deren Bedeutung, Kopf-an-Kopf-Vergleich, Hauptunterschiede, Vergleichstabelle und Schlussfolgerung. Sie können sich auch die folgenden Artikel ansehen, um mehr zu erfahren -

- Apache Spark vs Apache Flink - 8 nützliche Dinge, die Sie wissen müssen

- Apache Hive gegen Apache Spark SQL - 13 erstaunliche Unterschiede

- Beste 6 Vergleiche zwischen Hadoop Vs SQL

- Hadoop vs Teradata - Wertvolle Unterschiede