Einführung in Data Science-Algorithmen

Eine allgemeine Beschreibung der wichtigsten in Data Science verwendeten Algorithmen. Wie Sie bereits wissen, handelt es sich bei Data Science um ein Untersuchungsgebiet, in dem Entscheidungen auf der Grundlage der Erkenntnisse getroffen werden, die wir aus den Daten gewinnen, anstatt aus klassischen regelbasierten deterministischen Ansätzen. Normalerweise können wir eine maschinelle Lernaufgabe in drei Teile unterteilen

- Beschaffung der Daten und Abbildung des Geschäftsproblems

- Anwendung maschineller Lerntechniken und Beobachtung der Leistungsmetrik

- Testen und Bereitstellen des Modells

In diesem gesamten Lebenszyklus verwenden wir verschiedene datenwissenschaftliche Algorithmen, um die jeweilige Aufgabe zu lösen. In diesem Artikel werden wir die am häufigsten verwendeten Algorithmen nach ihren Lerntypen unterteilen und diese auf hoher Ebene diskutieren.

Arten von Data Science-Algorithmen

Basierend auf den Lernmethoden können wir maschinelles Lernen oder datenwissenschaftliche Algorithmen einfach in die folgenden Typen unterteilen

- Überwachte Algorithmen

- Unüberwachte Algorithmen

1. Überwachte Algorithmen

Wie der Name schon sagt, handelt es sich bei überwachten Algorithmen um eine Klasse von Algorithmen für maschinelles Lernen, bei denen das Modell mit den gekennzeichneten Daten trainiert wird. Anhand der Verlaufsdaten möchten Sie beispielsweise vorhersagen, dass ein Kunde einen Kredit in Verzug bringt oder nicht. Nach dem Pre-Process- und Feature-Engineering der gekennzeichneten Daten werden überwachte Algorithmen auf die strukturierten Daten trainiert und über einen neuen Datenpunkt oder in diesem Fall auf die Vorhersage eines Kreditausfalls getestet. Kommen wir zu den beliebtesten Algorithmen für überwachtes maschinelles Lernen.

- K Nächste Nachbarn

K Nearest Neighbours (KNN) ist einer der einfachsten und leistungsfähigsten Algorithmen für maschinelles Lernen. Es handelt sich um einen überwachten Algorithmus, bei dem die Klassifizierung anhand von k nächsten Datenpunkten erfolgt. Die Idee hinter KNN ist, dass ähnliche Punkte zu Clustern zusammengefasst werden, indem die Eigenschaften der nächsten Datenpunkte gemessen werden, um einen Testdatenpunkt zu klassifizieren. Zum Beispiel lösen wir ein Standardklassifizierungsproblem, bei dem wir vorhersagen möchten, dass ein Datenpunkt zur Klasse A oder Klasse B gehört. Wenn k = 3, testen wir jetzt 3 nächstgelegene Datenpunkte des Testdatenpunkts, wenn zwei von ihnen zur Klasse gehören A Wir deklarieren den Testdatenpunkt als Klasse A, ansonsten als Klasse B. Der richtige Wert von K wird durch Kreuzvalidierung ermittelt. Es hat eine lineare Zeitkomplexität und kann daher nicht für Anwendungen mit geringer Latenz verwendet werden.

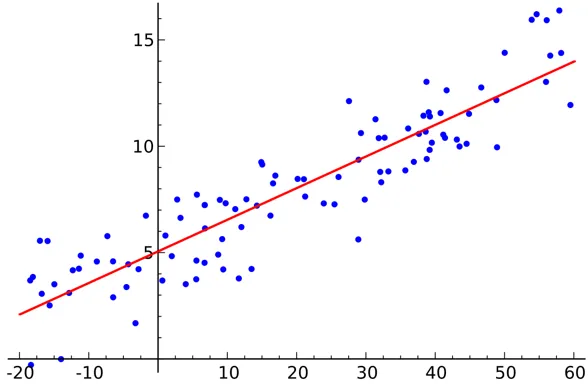

- Lineare Regression

Die lineare Regression ist ein überwachter datenwissenschaftlicher Algorithmus.

Ausgabe:

Variable ist stetig. Die Idee ist, eine Hyperebene zu finden, in der die maximale Anzahl von Punkten in der Hyperebene liegt. Beispielsweise ist die Vorhersage der Regenmenge ein Standard-Regressionsproblem, bei dem die lineare Regression verwendet werden kann. Bei der linearen Regression wird davon ausgegangen, dass die Beziehung zwischen den unabhängigen und abhängigen Variablen linear ist und es nur eine sehr geringe oder keine Multikollinearität gibt.

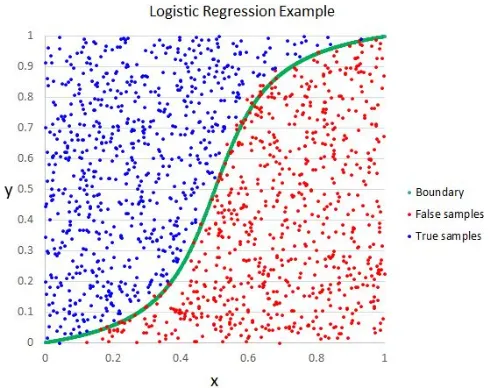

- Logistische Regression

Obwohl der Name Regression sagt, ist die logistische Regression ein überwachter Klassifizierungsalgorithmus.

Ausgabe:

Die geometrische Intuition ist, dass wir verschiedene Klassenbeschriftungen unter Verwendung einer linearen Entscheidungsgrenze trennen können. Die Ausgabevariable der logistischen Regression ist kategorisch. Bitte beachten Sie, dass wir den mittleren quadratischen Fehler nicht als Kostenfunktion für die logistische Regression verwenden können, da er für die logistische Regression nicht konvex ist.

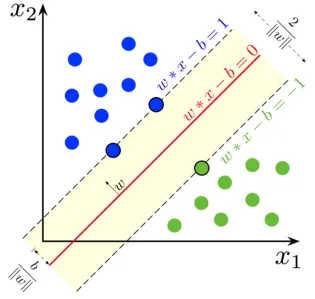

- Unterstützung Vektor Maschine

In der logistischen Regression war es unser Hauptmotto, eine trennende lineare Fläche zu finden.

Ausgabe:

Wir können die Support-Vektor-Maschine als eine Erweiterung dieser Idee betrachten, bei der wir eine Hyperebene finden müssen, die den Spielraum maximiert. Aber was ist ein Spielraum? Für einen Vektor W (die Entscheidungsfläche, die wir brauchen) zeichnen wir zwei parallele Linien auf beiden Seiten. Der Abstand zwischen diesen beiden Linien wird als Rand bezeichnet. SVM geht davon aus, dass die Daten linear trennbar sind. Obwohl wir SVM auch mit dem Kernel-Trick für nichtlineare Daten verwenden können.

- Entscheidungsbaum

Decision Tree ist ein geschachtelter If-Else-basierter Klassifikator, der eine baumartige Diagrammstruktur verwendet, um die Entscheidung zu treffen. Entscheidungsbäume sind sehr beliebt und einer der am häufigsten verwendeten Algorithmen für überwachtes maschinelles Lernen auf dem gesamten Gebiet der Datenwissenschaft. Es bietet in den meisten Fällen eine bessere Stabilität und Genauigkeit als andere überwachte Algorithmen und ist robust gegenüber Ausreißern. Die Ausgabevariable des Entscheidungsbaums ist normalerweise kategorial, kann jedoch auch zur Lösung von Regressionsproblemen verwendet werden.

- Ensembles

Ensembles sind eine beliebte Kategorie von datenwissenschaftlichen Algorithmen, bei denen mehrere Modelle zusammen verwendet werden, um eine bessere Leistung zu erzielen. Wenn Sie mit Kaggle (einer Plattform von Google zum Üben und zur Bewältigung datenwissenschaftlicher Herausforderungen) vertraut sind, werden Sie feststellen, dass die meisten Gewinnerlösungen Ensembles verwenden.

Wir können Ensembles grob in die folgenden Kategorien einteilen

- Absacken

- Erhöhen

- Stapeln

- Kaskadieren

Random Forest, Gradient Boosting Decision Trees sind Beispiele für einige beliebte Ensemble-Algorithmen.

2. Unüberwachte Algorithmen

Unbeaufsichtigte Algorithmen werden für die Aufgaben verwendet, bei denen die Daten nicht beschriftet sind. Der beliebteste Anwendungsfall für nicht überwachte Algorithmen ist das Clustering. Clustering ist die Aufgabe, ähnliche Datenpunkte ohne manuelles Eingreifen zu gruppieren. Lassen Sie uns hier einige der beliebten unbeaufsichtigten Algorithmen für maschinelles Lernen diskutieren

- K bedeutet

K Means ist ein randomisierter, nicht überwachter Algorithmus, der für das Clustering verwendet wird. K Means befolgt die folgenden Schritte

1.Initialisiere K Punkte nach dem Zufallsprinzip (c1, c2..ck)

2. Für jeden Punkt (Xi) im Datensatz

Wähle nächstgelegenes Ci (i = 1, 2, 3..k)

Addieren Sie Xi zu Ci

3. Berechnen Sie den Schwerpunkt neu mit geeigneten Metriken (z. B. Intracluster-Abstand).

4. Wiederholen Sie Schritt (2) (3), bis Sie konvergieren

- K bedeutet ++

Der Initialisierungsschritt in K means ist rein zufällig und basierend auf der Initialisierung ändert sich die Clusterbildung drastisch. K bedeutet, ++ löst dieses Problem, indem k auf probabilistische Weise anstelle einer reinen Randomisierung initialisiert wird. K bedeutet ++ ist stabiler als klassisches K bedeutet.

- K Medoids:

K medoids ist auch ein Clustering-Algorithmus, der auf K means basiert. Der Hauptunterschied zwischen den beiden besteht darin, dass die Zentroide des K-Mittels nicht unbedingt im Datensatz vorhanden sind, was bei K-Medoiden nicht der Fall ist. K-Medoide bieten eine bessere Interpretierbarkeit von Clustern. K bedeutet minimiert den quadratischen Gesamtfehler, während K Medoide die Unähnlichkeit zwischen Punkten minimieren.

Fazit

In diesem Artikel haben wir die populärsten Algorithmen für maschinelles Lernen diskutiert, die auf dem Gebiet der Datenwissenschaft verwendet werden. Nach all diesen Überlegungen stellt sich möglicherweise die Frage: Welcher Algorithmus ist der beste? Es ist klar, dass es hier keinen Gewinner gibt. Dies hängt ausschließlich von der jeweiligen Aufgabe und den geschäftlichen Anforderungen ab. Als Best Practice wird immer mit dem einfachsten Algorithmus begonnen und die Komplexität schrittweise erhöht.

Empfohlene Artikel

Dies war ein Leitfaden für Data Science-Algorithmen. Hier haben wir einen Überblick über datenwissenschaftliche Algorithmen und zwei Arten von datenwissenschaftlichen Algorithmen diskutiert. Sie können auch in unseren Artikeln nachlesen, um mehr zu erfahren.

- Data Science Platform

- Data Science Languages

- Klassifizierungsalgorithmen

- Data Mining-Algorithmen

- Meist verwendete Techniken des Ensemble-Lernens

- Einfache Möglichkeiten zum Erstellen eines Entscheidungsbaums

- Vollständiger Leitfaden zum Data Science-Lebenszyklus