Einführung in die Datenvorverarbeitung im maschinellen Lernen

Datenvorverarbeitung im maschinellen Lernen ist eine Möglichkeit, Daten aus dem Rohformular in ein viel formatierteres, unbrauchbares oder gewünschtes Formular zu konvertieren. Es ist eine integrale Aufgabe des maschinellen Lernens, die vom Datenwissenschaftler durchgeführt wird. Da die gesammelten Daten in einem Rohformat vorliegen, ist es möglicherweise nicht möglich, das Modell damit zu trainieren. Es ist wichtig, diese Rohdaten sorgfältig zu verarbeiten, um sie richtig zu interpretieren und letztendlich negative Ergebnisse bei der Vorhersage zu vermeiden. Kurz gesagt, die Qualität unseres Lernalgorithmus hängt stark von der Art des Datasets ab, mit dem wir das Modell gespeist haben, sodass die Datenvorverarbeitung verwendet wird, um diese Qualität aufrechtzuerhalten.

Die für das Training des Modells gesammelten Daten stammen aus verschiedenen Quellen. Diese gesammelten Daten liegen im Allgemeinen in ihrem Rohformat vor, dh sie können Geräusche wie fehlende Werte und relevante Informationen, Zahlen im Zeichenfolgenformat usw. aufweisen oder sie können unstrukturiert sein. Die Datenvorverarbeitung erhöht die Effizienz und Genauigkeit der maschinellen Lernmodelle. Dies hilft, diese Geräusche aus dem Datensatz zu entfernen und dem Datensatz eine Bedeutung zu geben

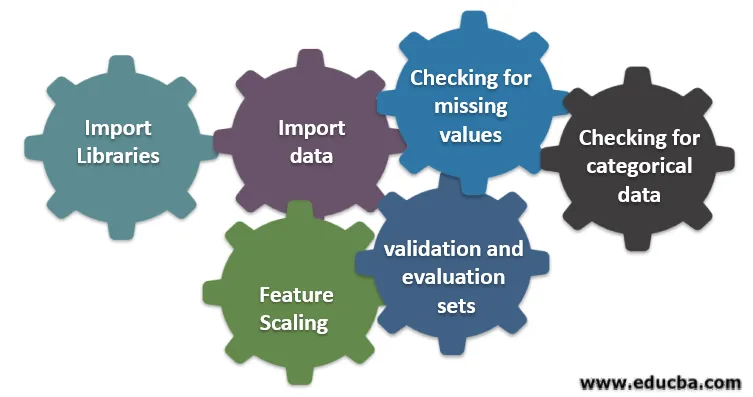

Sechs verschiedene Schritte des maschinellen Lernens

Es folgen sechs verschiedene Schritte beim maschinellen Lernen, um die Datenvorverarbeitung durchzuführen:

Schritt 1: Bibliotheken importieren

Schritt 2: Daten importieren

Schritt 3: Überprüfung auf fehlende Werte

Schritt 4: Suche nach kategorialen Daten

Schritt 5: Feature-Skalierung

Schritt 6: Aufteilen der Daten in Trainings-, Validierungs- und Bewertungssätze

Lassen Sie uns jeden dieser Schritte im Detail verstehen:

1. Bibliotheken importieren

Der allererste Schritt besteht darin, einige der wichtigen Bibliotheken zu importieren, die für die Datenvorverarbeitung erforderlich sind. Eine Bibliothek ist eine Sammlung von Modulen, die aufgerufen und verwendet werden können. In Python gibt es viele Bibliotheken, die bei der Datenvorverarbeitung hilfreich sind.

Einige der folgenden wichtigen Bibliotheken in Python sind:

- Numpy: Meistens wurde die Bibliothek zum Implementieren oder Verwenden komplizierter mathematischer Berechnungen für maschinelles Lernen verwendet. Es ist nützlich, wenn Sie eine Operation für mehrdimensionale Arrays ausführen.

- Pandas : Es handelt sich um eine OpenSource-Bibliothek, die eine hohe Leistung sowie benutzerfreundliche Datenstruktur- und Datenanalysetools in Python bietet. Es ist so konzipiert, dass das Arbeiten mit relativen und beschrifteten Daten einfach und intuitiv ist.

- Matplotlib: Dies ist eine von Python bereitgestellte Visualisierungsbibliothek für 2D-Diagramme oder Arrays. Es basiert auf einem Numpy-Array und wurde für die Verwendung mit einem breiteren Scipy-Stack entwickelt. Die Visualisierung von Datensätzen ist hilfreich in Szenarien, in denen große Datenmengen verfügbar sind. In matplot lib verfügbare Diagramme sind Linie, Balken, Streuung, Histogramm usw.

- Seaborn: Es ist auch eine Visualisierungsbibliothek, die von Python bereitgestellt wird. Es bietet eine übergeordnete Oberfläche zum Zeichnen attraktiver und informativer statistischer Diagramme.

2. Importieren Sie den Datensatz

Sobald die Bibliotheken importiert sind, besteht unser nächster Schritt darin, die gesammelten Daten zu laden. Die Pandas-Bibliothek wird zum Importieren dieser Datensätze verwendet. Meistens sind die Datensätze in CSV-Formaten verfügbar, da sie eine geringe Größe haben und daher schnell verarbeitet werden können. So laden Sie eine CSV-Datei mit der Funktion read_csv der Pandabibliothek. Verschiedene andere Formate des Datensatzes, die angezeigt werden können, sind

Sobald der Datensatz geladen ist, müssen wir ihn untersuchen und nach Geräuschen suchen. Dazu müssen wir eine Merkmalsmatrix X und einen Beobachtungsvektor Y in Bezug auf X erstellen.

3. Überprüfung auf fehlende Werte

Wenn Sie die Feature-Matrix erstellt haben, fehlen möglicherweise Werte. Wenn wir nicht damit umgehen, kann es zum Zeitpunkt des Trainings zu Problemen kommen.

Es gibt zwei Methoden, mit den fehlenden Werten umzugehen:

- Wenn Sie die gesamte Zeile entfernen, die den fehlenden Wert enthält, können jedoch möglicherweise wichtige Informationen verloren gehen. Dies kann ein guter Ansatz sein, wenn der Datensatz groß ist.

- Wenn in einer numerischen Spalte ein Wert fehlt, können Sie den Wert anhand des Mittelwerts, des Medians, des Modus usw. schätzen.

4. Überprüfung auf kategoriale Daten

Die Daten im Datensatz müssen in numerischer Form vorliegen, um eine Berechnung durchführen zu können. Da Modelle für maschinelles Lernen komplexe mathematische Berechnungen enthalten, können wir ihnen keinen nicht numerischen Wert zuweisen. Daher ist es wichtig, alle Textwerte in numerische Werte umzuwandeln. Die erlernte LabelEncoder () -Klasse wird verwendet, um diese kategorialen Werte in numerische Werte umzuwandeln.

5. Funktionsskalierung

Die Werte der Rohdaten variieren extrem und dies kann zu einem verzerrten Training des Modells führen oder letztendlich die Rechenkosten erhöhen. Deshalb ist es wichtig, sie zu normalisieren. Die Merkmalsskalierung ist eine Technik, die verwendet wird, um den Datenwert in einen kürzeren Bereich zu bringen.

Für die Merkmalsskalierung verwendete Methoden sind:

- Neuskalierung (Min-Max-Normalisierung)

- Mittlere Normalisierung

- Standardisierung (Z-Score-Normalisierung)

- Skalierung auf Einheitslänge

6. Aufteilung der Daten in Trainings-, Validierungs- und Bewertungssätze

Schließlich müssen wir unsere Daten in drei verschiedene Sätze aufteilen, einen Trainingssatz zum Trainieren des Modells, einen Validierungssatz zum Validieren der Genauigkeit unseres Modells und einen Testsatz zum Testen der Leistung unseres Modells anhand generischer Daten. Vor dem Teilen des Datensatzes ist es wichtig, den Datensatz zu mischen, um Verzerrungen zu vermeiden. Ein ideales Verhältnis zum Teilen des Datensatzes ist 60:20:20, dh 60% als Trainingssatz, 20% als Test- und Validierungssatz. Verwenden Sie zum Teilen des Datensatzes train_test_split von sklearn.model_selection zweimal. Einmal, um den Datensatz in Zug und Validierungssatz zu unterteilen, und dann, um den verbleibenden Zugdatensatz in Zug und Testsatz zu unterteilen.

Fazit - Datenvorverarbeitung beim maschinellen Lernen

Datenvorverarbeitung ist etwas, das Übung erfordert. Es ist nicht wie eine einfache Datenstruktur, in der Sie lernen und direkt anwenden, um ein Problem zu lösen. Um gute Kenntnisse zum Bereinigen eines Datasets oder zum Visualisieren Ihres Datasets zu erhalten, müssen Sie mit verschiedenen Datasets arbeiten.

Je öfter Sie diese Techniken anwenden, desto besser werden Sie verstehen, wie Sie damit umgehen. Dies war eine allgemeine Vorstellung davon, wie die Datenverarbeitung beim maschinellen Lernen eine wichtige Rolle spielt. Gleichzeitig haben wir auch die Schritte gesehen, die für die Datenvorverarbeitung erforderlich sind. Bevor Sie das Modell das nächste Mal mit den gesammelten Daten trainieren, müssen Sie die Datenvorverarbeitung anwenden.

Empfohlene Artikel

Dies ist eine Anleitung zur Datenvorverarbeitung beim maschinellen Lernen. Hier diskutieren wir die Einführung, sechs verschiedene Schritte im maschinellen Lernen. Sie können auch unsere anderen Artikelvorschläge durchgehen, um mehr zu erfahren.

- Bedeutung der künstlichen Intelligenz

- IoT-Technologie

- PL / SQL-Datentypen

- Hive-Datentypen

- R Datentypen